Mit dem Aufkommen elektronischer Rechenmaschinen eröffneten sich dem Menschen zuvor nie gekannte Möglichkeiten, sowohl was die maschinenunterstützte Rechenleistung, also die Geschwindigkeit , mit der vorgefertigte Algorithmen abgearbeitet werden konnten, als auch, was die Vielseitigkeit der Problemstellungen betraf, bei denen diese Algorithmen angewendet werden konnten.. Am Anfang der AI-Forschung stand der Wunsch mit Hilfe solcher elektronischer Systeme, spezifische Fähigkeiten des Menschen auf Maschinen zu übertragen. Dabei waren die Vorstellungen, was genau menschliches und im Speziellen „intelligentes“ Verhalten ausmacht, durchaus unterschiedlich. Letztlich entzieht sich der Begriff „Intelligenz“ bis heute einer allgemeinen und allgemein anerkannten Definition.

>Historische Vorstellungen künstlicher Menschen

>Der Begriff „Intelligenz“

>Philosophische Grundlagen

>Frühe Versuche, Denken zu formalisieren

>Psychologische Grundlagen

Historische Vorstellungen künstlicher Menschen

Der Wunsch künstliche Menschen herzustellen ist denkbar alt und ebenso besteht ein zeitloses Bedürfnis das Unbelebte zu „beleben“.Belebte Materie

So wird in der griechischen Mythologie der Versuch des Bildhauers Pygmalion geschildert, der vollkommenen Statue Galatea Leben einzuhauchen.Ebenfalls aus Griechenland stammt der Mythos von Prometheus, der aus Lehm Menschen erschafft und ihnen das Feuer bringt. Allerdings war Prometheus ein Halbgott, was sich nicht ganz mit der Vorstellung des Menschen aus Menschenhand deckt.

In der ägyptischen Königsstadt Napata existierte ein Standbild des Gottes Amon. Dieses erwählte nach dem Tod des Pharaos aus den vorüberziehenden Kandidaten den Nachfolger. Dabei streckte die Statue den Arm aus, packte den Erwählten und hielt ein Weiheansprache. Allerdings saß ein Priester im Verborgenen, der die Bewegung über einen Hebel steuerte. Dennoch war, so vermutet Daniel Crevier, in der Vorstellung der Menschen „das aus Priester und Standbild bestehende System mehr als die Summe seiner Teile und verkörperte die Gottheit.“ (Crevier 1994, S. 15).

In der jüdischen Überlieferung existiert die Vorstellung von einem Golem, einem Mann aus Lehm, der mithilfe einer Oblate und dem täglich gesprochenen Wort „Ameth“ (Wahrheit) zum Leben erweckt werden kann. Der berühmteste Golem soll von Rabbi Loew in Prag geschaffen worden sein, um die Juden vor Verfolgung zu schützen.

Mary Shelley’s Frankenstein aus dem Jahr 1816 zeigt ein eher

düsteres Bild des künstlich erschaffenen Menschen.

Künstliche Menschen

Neben der Vorstellung der „Belebung“ wurde auch immer wieder versucht, Menschen mit mechanischen Mitteln zu imitieren. Auch hier gehen frühe Beispiele in das antike Griechenland zurück.Homer, bzw. der Autor der Ilias, beschreibt selbsttätige Mechanismen (Automaten), wie zum Beispiel zierlich schreitende Dreifüßer als goldene Gehilfinnen, als Werke des göttlichen Schmiedes Hephaistos.

Im Daedalus-Mythos wird vom kupfernen Riesen Talos berichtet, der an Kretas Gestaden auf-und abpatroullierte.

Vorlage dazu sind vermutlich tatsächliche Automaten in Alexandria

im Griechenland des 3. bis 1. Jahrhunders. v. Chr., hergestellt durch Ingenieure

einer von Ktesibios gegründeten Schule und vom römischen Autor

und Architekten Vitruv beschrieben: „automatische Vorrichtungen und vergnügliche

Gegenstände aller Art [...] Raben, die vermittels durch Wasserkraft

angetriebener Vorrichtungen sangen, und Gestalten, die tranken und umhergingen“

(zit. n. Crevier, S. 15)

Im 13. Jahrhundert soll der Franziskanermönch Roger Bacon sieben

Jahre lang sprechende Gestalten angefertigt haben.

Leonardo da Vinci fertigte einen Automaten in Gestalt eines Löwen

zur Ehre von Ludwig XII an.

Im 16.und 17.Jahrhundert gab es eine Weiterentwicklung der Alexandrinischen

Automaten durch italienische und französische Techniker (wie Gio Battista

Aleotti und Salomon de Caus): Sie schufen künstliche Vögel, die

singen, mechanische Flötenspieler, und vieles mehr.

Rene’ Descartes konstruierte 1649 einen Automaten, den er„meine Tochter Francine“ nannte. Die Puppe konnte „dem Leben täuschend ähnlich nachempfundene Bewegungen“ (Crevier, S.15) vollziehen und wurde auf einer Seereise zufällig von einem abergläubischen Kapitän entdeckt, der sie verängstigt samt Kiste über Board warf.

In diesem Zusammenhang muss auch der französische Kunsthandwerker Jacques de Vaucanson genannt werden, der im 18. Jahrhundert eine nahezu vollständige Nachbildung einer natürlichen Ente schuf, die sich im Wasser bewegte, schnatterte, trank, fraß und sogar verdaut haben soll.

All diese Versuch zielen auf die eine oder andere Art auf die künstliche Neuerschaffung eines Menschen ab. Mit den Möglichkeiten elektronischer System schien in der Mitte des 20. Jahrhunderts erstmals die reale Möglichkeit greifbar auch den Prozess des menschlichen Denkens oder intelligentes Verhalten, was auch immer das bedeuten soll, künstlich nachzubilden.

>[www.aaai.org/AITopics/bbhist.html]

Ein kurzer Überblick über die Geschichte der AI

Der Begriff „Intelligenz“

Das Wort Intelligenz ist sowohl in seiner historischen Dimension als auch in seinem kulturellen Kontext zu betrachten. Noch vor ca. 100 Jahren wurde Intelligenz im Deutschen in einer umfassenderen Bedeutung gebraucht. So gab es die sogenannten Intelligenzblätter, die nichts anderes als Anzeigenblätter waren. Im Englischen wird Intelligence allgemeiner für Nachrichten gebraucht, man denke an das Intelligence Service oder die Central Intelligence Agency.In der Vorlesung "Menschliche und künstliche Intelligenz" geht Zemanek der Frage nach, in welcher Relation Computerprogramme zur Simulation menschlicher Intelligenzleistung. zur menschlichen Intelligenz stehen und welche Rolle dabei das Bewusstsein spielt. Ist der Computer also eine Denkmaschine? Die Berechtigung des Begriffes und die geistige Einbettung der "Künstlichen Intelligenz" werden beleuchtet.

Schon 1843 hat der Mathematiker Joseph Petzval das Wort "Denkmaschine" in seinen "Dioptrischen Untersuchungen" verwendet: "..die reine Mathematik, die überhaupt die Vervollkommnung einer großen und mächtigen Denkmaschine zum Zwecke hat, ohne Rücksicht auf den verarbeiteten Stoff." Die Begriffe Denken, Bewusstsein, Intelligenz und Wissen sind aber nur in dem Sinn äquivalent, was das Verhalten, die Funktion oder die Erscheinung betrifft, nicht im inneren Wesen. Der Computer hat kein Bewusstsein, darin unterscheidet er sich vom Menschen. Das Erleben der eigenen Existenz als Ganzheit hat im Computer keine Entsprechung. Newell, Simon und Shaw sind daran beim Problem Solver gescheitert.

Durch die technische Entwicklung wird immer mehr menschliche Intelligenz in die Maschine verpackt, bis man einmal keinen Unterschied im Verhalten zum Menschen feststellen kann. Die Prüfung dazu ist der Turing-Test. Wären Computer gleich intelligent wie Menschen, würden sie zuerst gleichberechtigt sein und in weiterer Entwicklung die Führung übernehmen und ohne Menschen auskommen. Eine solche Perspektive hat bereits 1872 der Schriftsteller Samuel Butler im Buch Erewhon entwickelt.

Der Computer hat kein Bewusstsein und damit auch keinen Geist, es fehlt

ihm die Gabe der Sprache.

Zur Begriffsbildung führt Zemanek aus:

Intelligenz ist die Fähigkeit des Erkennens und der Erkenntnis. Im englischen ist Intelligence jedoch weiter gefasst (Intelligence Service bedeutet Sammeln und Auswerten von Information).Unter Geist versteht man das höhere, über den Naturgesetzen

stehende psychische Leben. Die Seele steht für die Einheit des Bewusstseins

und das Ich. Das Ich koordiniert Die Beurteilung, das Wollen und das Tun,

dazu bedarf es wiederum Erkenntnis, Geschmack und Charakter. Wissen ist

nicht nur Faktensammeln, sondern die geistige Fähigkeit, aus der Verknüpfung

der Information mehrerer Sinnesorgane und der Erinnerung zur Erkenntnis

des Ganzen zu kommen und seine Einbettung in die Welt zu verstehen.

Entstehung des Begriffs KI

Der Ausdruck Künstliche Intelligenz wurde zum ersten Mal 1956 von John McCarthy verwendet. W.R. Ashby schrieb 1956 den Beitrag Design for an Intelligence Amplifier, in dem er die Intelligenz auf die Kraft der Auswahl zurückführt. Außerdem hielt er 1961 den Vortrag Was ist eine intelligente Maschine?, in dem er nur eine Intelligenz anerkennt, egal ob in Maschine oder im Menschen.1963 erschien das Buch Computers and Thought von Edward E. Feigenbaum und Julian Feldman, in dem Einwände gegen die KI widerlegt wurden.

1943 gab es eine Arbeit über das aussagenlogische Verhalten der Nervenzellen von Warren S. McCulloch und Walter Pitts, was die Vorstellung förderte, dass die Funktionsweisen von Gehirn und Computer im Grunde die gleichen sind.

C.E. Shannon entwickelte die Informationstheorie, ein syntaktisches Modell. Carnap und Bar-Hillel scheiterten daran, die Informationstheorie auf die Semantik zu erweitern. Norbert Wiener meinte, dass die telegraphische Übermittlung eines Menschen nur eine technische, aber keine fundamentale Schwierigkeit sei. Das System der Regelung erklärte viele Phänomene im Nervensystem auf physikalische Weise. Die Kybernetik modellierte Körperfunktionen, an denen auch das Gehirn beteiligt ist. Die Modellbildung für den ganzen Menschen wurde zur natürlichen Fortführung.

Die Programmierung des Schachspiels wurde 1945 von Zuse als Beispiel für seinen Plankalkül herangezogen. Es wurden viele Schachprogramme entwickelt und ab 1974 sogar internationale Wettbewerbe ausgetragen.

Danach wurden auch Sprachexperimente betrieben. Von Joseph Weizenbaum wurde 1965 durch das Programm ELIZA ein Psychiater simuliert. Er stellte jedoch klar, dass es sich hierbei nicht um die allgemeine Lösung des Problems handle, wie weit ein Computer natürliche Sprache verstehen könne. Der Technologie wurden übertriebene Eigenschaften zugeschrieben.

1959 gab es ein Programm von H. Gelernter und N. Rochester über ein Programm, das im Rahmen einer formalisierten Geometrie Beweise führen konnte.

A. Newell, J.C. Shaw und H.A. Simon versuchten mit dem General Problem Solver, ausgehend vom Lösen von Aufgaben der Aussagenlogik, Probleme der formalen Logik und alle formalisierten Aufgaben zu lösen, was nicht gelang, da sich das Programm in Unteraufgaben verstrickte.

(Quelle Zemanek: Das geistige Umfeld der Informationstechnik, Springer-Verlag

1992)

Philosophische Grundlagen

John Haugeland lieferte 1985 in Artificial Intelligence - The Very Idea, in deutsch Künstliche Intelligenz - Programmierte Vernunft? eine philosophische Untermauerung der Überansprüche an die Künstliche Intelligenz: "Vielleicht sollte die KI Synthetische Intelligenz genannt werden. Unter künstlichen Diamanten versteht man ja Imitationen, während synthetische Diamanten wirkliche Diamanten sind, lediglich anders hergestellt."Die Fragestellung, was Denken sei und ob Maschinen denken können, beschäftigen die Menschen schon seit Alters her. Verschiedene Denkrichtungen und Modelle beeinflussten die Forscher. Bei Descartes finden wir den Dualismus Körper - Geist, bei Leibnitz den Physikalismus und Materialismus. Turing versuchte in "Computing Machinery and Intelligence" in einem Experiment, dem Turing-Test festzulegen, wann eine Maschine für intelligent zu gelten hat. Searle stellte mit seinem Chinese Room Experiment dar, dass wenn ein Objekt etwas nicht bewusst verstehen kann, so auch jedes aus solchen Objekten gebildetes System das nicht verstehen kann.

Man könnte sich nun die Frage stellen, ob nicht die Philosophie ohnehin nur der Entwicklung hinterherläuft und sozusagen nachträglich einer bereits erfolgten Entwicklung ein geistiges Fundament verleihen möchte. Doch die Betrachtungen Haugelands bewirken ein Weltbild, durch welches man Forschungsergebnisse erhofft, die man auf der Basis von Zemaneks Ansichten gar nicht erst in Betracht ziehen würde. Dieser schließt ja das Erzeugen eines künstlichen Bewusstseins aus. Es ist das Denkmodell, der konkrete Denkansatz und das Weltbild eines Entwicklers, die die tatsächliche Forschung und damit die Ergebnisse beeinflussen. Der eingeschlagene Weg in einem Labyrinth an Möglichkeiten wird auch durch die philosophische Grundhaltung beeinflusst. So ließe sich eine Forschungsrichtung durch Einwirken auf eine solche Grundhaltung in eine spezielle Richtung hin bewegen. Und dies geht auch mit scheinbar wenig philosophischen Dingen wie dem Turing-Test, der ja auch eine - eventuell irreführende Grundhaltung nahelegt, wie dies von Zemanek und auch in einem Artikel im Spektrum der Wissenschaft durch Ford und Hayes kritisiert wird.

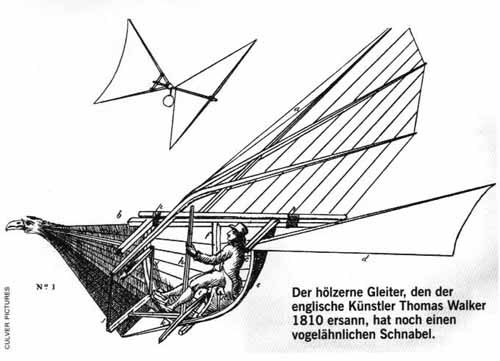

Zur besseren Illustration bringen Kenneth M. Ford und Patrick J. Hayes im Spektrum der Wissenschaften Spezial, Nachdruck 1/2000 einen historischen Vergleich mit dem Fliegen. Die immense Bedeutung des Denkansatzes kommt dabei deutlich zum Ausdruck.

Nach Ansicht der Autoren gibt es trotz der theoretisch untermauerten Kritik, es sei unmöglich, eine wirklich intelligente Maschine zu bauen, in der Praxis "intelligente Geräte". In den Neurowissenschaften wird das Gehirn als eine Art biologischer Computer aufgefasst.

Fliegen galt ja auch lange Zeit als hoffnungslos, wurde dann aber doch gelöst. So könnte man vermuten, dass das Ziel der KI nicht im Prinzip unerreichbar ist, sondern nur in der Form, in der man es sich gegenwärtig vorzustellen pflegt, nämlich den menschlichen Geist zu imitieren.

Bild: Idee eines Holzgleiters aus 1810, Abbildung aus Spektrum der

Wissenschaft Spezial, Nachdruck 1/2000

Die Ziele der KI folgen dem Schema, das biologische Vorbild zu imitieren. Turing steckte 1950 der Forschung als Fernziel das Bestehen in einem Zwiegespräch, dem Turing-Test. Ein menschlicher Gutachter führt dabei eine Konversation über Tastatur und Bildschirm mit einem menschlichen und einem Computerpartner, mit dem Ziel, herauszufinden, wer der Mensch und wer die Maschine ist. Dieser hat zu großem Schaden geführt:

- er führte zum weitverbreiteten Irrglauben über die eigentlichen Ziele des Forschungsgebietes KI.

- er ist schlecht geplant, denn die subjektive Entscheidung des Gutachters hat ein zu großes Gewicht.

- das dahinter stehende Ziel ist fragwürdig: Wozu müssen wir menschliche Intelligenz imitieren?

- das Versuchsergebnis ist kulturabhängig.

- Turing merkte selbst an, auch ein Mensch könne beim Test durchfallen - durch zu hohe Intelligenz.

Der Test beschränkt sich auf eine biologische Art. Daher wird

mittlerweile nach den informatischen Grundlagen der Intelligenz an sich

gesucht. Theoretisch will man Intelligenzleistungen als eine Art Rechenleistung

begreifen. man will Maschinen bauen, die in ausgewählten Bereichen

menschliche geistige Fähigkeiten erweitern und übertreffen. Die

Menschenähnlichkeit ist kein Maßstab mehr für Fortschritt

in der KI.

Es geht um eine informatische Wissenschaft von Intelligenz an sich, egal, ob menschlich oder maschinell. Diesen Anspruch vertraten schon die KI-Pioniere Allen Newell und Herbert A. Simon, der Kognitionsforscher Zenon Pylyshyn, der Philosoph Daniel c. Dennett und andere. Zwischen diesem Anspruch und dem Turing-Test besteht ein krasser Widerspruch.

Als empirische Wissenschaft untersucht die KI die von Newell und Simon als solche bezeichneten "Gesetze qualitativer Strukturen".

Die Unmöglichkeit künstlicher Intelligenz will Roger Penrose mithilfe des Gödelschen Unvollständigkeitssatzes beweisen. Der Durchbruch der KI hat laut Simon aber schon stattgefunden, da Computer täglich Intelligenzleistungen erbringen. Zu Turings Zeiten war unbestritten, dass Rechnen Intelligenz erfordert, inzwischen gilt es nicht mehr als wesentliches Kennzeichen von Intelligenz.

Entgegen Peter Bieris Ansicht, dass die informatische Sichtweise niemals das Phänomen des Bewusstseins erklären könne (Spektrum der Wissenschaft, Oktober 1992, S. 48), glauben die Autoren, dass sie die größten Chancen unter allen gegenwärtig diskutierten Theorien über die Natur des Bewusstseins hat. Das Ziel der KI sei, eine informatische Gesamtsicht der geistigen Fähigkeiten zu liefern, nicht nur der menschlichen. Sollte das Gehirn eine Art biologischer Computer sein, das ist es ein bemerkenswerter Computer.

(Quelle: Spektrum der Wissenschaft - spezial, Ausgabe 1/2000: Neue Wege

zur denkenden Maschine. Von Kenneth M. Ford und Patrick J. Hayes)

Frühe Versuche, Denken zu formalisieren

Wichtige Voraussetzung für die Schaffung künstlicher "denkender" oder "intelligenter" Systeme ist die formale Beschreibung menschlichen Denkens. Dies ist im Grunde bis heute nicht gelungen, da wir noch zu wenig über die Funktion den menschlichen Gehirns wissen. Leichter ist es als Teilgebiet des Denkens logisches Schlussfolgern formal zu beschreiben.Der erste systematisch Versuch, Vorstellungen auf künstlichem Weg durch mechanische Hilfsmittel zu erzeugen wird dem spanischen Missionar, Philosophen und Theologen Ramón Lull (Raimundus Lullus) zugesprochen. Im 13. Jahrhundert entwickelte er Zairja – ein Instrument, das bestimmte Begriffe in zufälliger Weise miteinander kombinierte. (allerdings fehlte die Möglichkeit, gewonnene Kombinationen automatisch zu deuten und zu bewerten.)

Gottfried Wilhelm Leibniz spricht im 17. Jahrhundert die Hoffnung auf einen calculus ratiocinator (eine auf Vernunft gründende Berechnungsmethode) aus. Die Idee dahinter: Jedem Begriff wird eine Zahl zugeordnet. Dadurch würde die Möglichkeit bestehen, diese Zahlen auf formale Weise zu bearbeiten. Diese Idee liegt ja im Grunde moderner elektronischer Datenverarbeitung zugrunde. (Leibniz verband mit seinem calculus ratiocinator allerdings noch viel weitreichender die Hoffnung auf eine gemeinsame Sprache zur Verständigung unter verschiedenen Völkern.) Als Hindernis zum vollständigen Formalisieren des Denkens sieht Leibniz die wechselseitige Beziehung aller Begriffe untereinander (eine vollkommene Analyse führe von einem Begriff immer auf andere, wenn nicht zu allen). Bis heute hindert genau diese wie auch immer geartete Beziehung der Begriffe untereinander die Schaffung eines allgemeinen intelligenten Systems, das den Fähigkeiten des Menschen auch nur annähernd ebenbürtig ist.

Äußerst wichtig im Zusammenhang mit der künstlichen Intelligenz sind die Überlegungen des Autodidakten George Boole. Im Versuch, Denken formal zu beschreiben, entwickelte er in "The Laws of Thought" (1854) die heute unter seinem Namen bekannte Algebra, mittels derer man nicht nur Mengen, sondern in analoger Weise auch Aussagen miteinander verknüpfen kann und somit aus dem Wahrheitswerten der ursprünglichen Aussagen auf den Wahrheitswert der verknüpften Aussage schließen kann. Boole lieferte damit nicht nur ein Konzept für logisches Denken, sondern legte damit auch die Grundlage für Claude Shannons Analyse elektrischer Schaltkreise 90 Jahre später, die wiederum die theoretische Grundlage für den Bau moderner Computer bildet.

Booles Algebra stellt allerdings kein vollständiges, allgemeines Werkzeug zum Ausdruck logischer Aussagen dar. Innerhalb ihrer können keine Aussagen zu allgemeinen oder unbestimmten Objekten erzeugt oder behandelt werden. 1879 legte Gottlob Frege in seiner "Begriffsschrift" eine seiner Meinung nach "der arithmetischen nachgebildeten Formelsprache des reinen Denkens" (so der Untertitel) vor. Wichtig dabei war eine saubere Definition des Wortes "Begriff" wie die Unterscheidung zwischen geschlossenen und offenen Sätzen. Letztere enthalten erst einen Wahrheitswert wenn die in ihnen enthaltenen Leerstellen (wie Variablen in einer mathematischen Gleichung) besetzt werden. Da logische Sätze in natürlichen Sprachen nur sehr schwer und manchmal gar nicht eindeutig formulierbar sind, entwickelte Frege eine "Begriffsschrift", die allerdings nicht linear aufschreibbar ist. Sie hat sich nie wirklich durchgesetzt und wäre auch in den Computer nur sehr schwer einzugeben.

einfache Elemente von Freges Begriffsschrift

und ihre heutige Notation

Auch wenn Bertrand Russel 1902 in Freges System einen Wiederspruch fand, und damit den Anspruch einer allumfassenden logischen Sprache zunichte machte, so wurde durch Freges Werk doch der Grundstein für die Aussagenlogik gelegt, ein mächtiges Werkzeug zur Formulierung logischer Sätze.

Als Kurt Gödel 1931 in seinem Aufsatz "Über formal unentscheidbare Sätze der Principia Mathematica und verwandter Systeme I" nahelegte, dass wohl in jedem widerspruchsfreien logischen System wahre Sätze formulierbar sind, die man mit Hilfe dieses Systems nicht beweisen kann, war mit einem Schlag jede Hoffnung begraben, ein allumfassendes logisches System beschreiben zu können. Bemerkenswert ist, dass die von Gödel betrachteten Sätze durch den Verstand des Menschen sehr wohl als wahr erkannt werden können, während das logische System in dem diese Aussagen formuliert wurden, dies nicht leisten kann.

Der erste, der eine Formelsprache reinen Denkens mit der Konstruktion einer "Maschine" verband, war Alan Turing. Er führte die Idee einer "Turing-Maschine" ein, einer abstrakten Apparatur, die einen Schreib- und Lesekopf besitzt, der sich wiederum an einer wohldefinierten Stelle eines endlosen, linear mit Nullen und Einsen bechriebenes Bandes befindet.. Dabei kann sich die Maschine stets in genau einem von beliebig vielen Zuständen befinden, die festlegen, wie die Maschine auf ein Symbol auf dem Band reagiert. Mögliche Reaktionen sind: Beschreiben der aktuellen Position des Bandes mit "0" oder "1", den Lesekopf auf dem Band eine Stelle vorwärts bewegen oder den Lesekopf eine Stelle nach hinten bewegen und schließlich die Änderung des Zustands der Maschine.

Schema einer Turingmaschine ([Quelle des Bildes])

Turing vertrat die Ansicht, dass jede systematische Prozedur zur Verarbeitung

von Zahlen als Abfolge solcher elementarer Operationen codierbar ist (Church-Turing-Hypothese).

Auch Turing fiel auf, dass es gewisse Arten von Rechnungen gibt, die keine

Turing-Maschine je ausführen könnte, obwohl sie einem Menschen

banal erscheinen können. Dennoch zweifelte Turing nicht daran, dass

es möglich sei, Maschinen in gewissem Sinne das Denken beizubringen!

(Siehe hier!)

Heutige Computer können durchaus als Realisation von Turing-Maschinen

angesehen werden. Aufgrund von Turings Überlegungen schien es machbar,

mit Hilfe von Computern Systeme zu bauen, die komplexe Aufgabenstellungen

bewältigen können, ja sogar "intelligentes" Verhalten zeigen.

Psychologische Grundlagen

Um menschliche Denkprozesse künstlich nachzubilden, ist es auch wichtig nachzufragen, welche psychologischen Modelle den Vorstellungen vom menschlichen Denken zugrunde liegen. Eine wichtige Rolle spielte in der frühen AI-Szene die im Amerika der späten 1940er Jahre vorherrschende Schule des Behaviorismus. Die Verbindung zur AI wurde vor allem durch die Person des AI-forschers Marvin Minsky hergestellt, der in seiner Studienzeit in den verschiedensten wissenschaftlichen Disziplinen, unter ihnen eben auch die Psychologie, herumschnupperte.Pawlow hatte in seinen Experimenten gezeigt, dass Hunde, die bei jeder Fütterung einen Glockenton zu hören bekamen, schließlich auch schon beim bloßen ertönen der Glocke Speichel absonderten, ohne dass ihnen tatsächlich Futter vorgestzt wurde. Von derartigen Beobachtungen ausgehend und auf den Menschen übertragen, vertraten die Behavioristen die Meinung, dass jedes Verhalten, ja jeder Gedanke oder Wunsch ein Reflex ist, eine spontane Reaktion auf einen wie auch immer gearteten Reiz ist. Der Unterschied zwischen Mensch und Tier wurde dadurch erklärt, dass der Mensch fähig ist, auf komplexere Reizmuster zu reagieren, die als "Situationen" bezeichnet wurden. Lernen war demnach nichts anderes, als die Koppelung von bestimmten Reizen und deren Reaktionen zu verstärken. Diese Vorstellung veranlasste Minsky schließlich auch, eine Maschine auf der Grundlage eines neuronalen Netzes zu bauen.

>[www.ik.fh-hannover.de/person/becher/edvhist/ki/allgemein.htm] Entwicklungsperioden der KI, vom 14.4.02

>[www.aaai.org/AITopics/bbhist.html] Ein kurzer Überblick über die Geschichte der AI

>[library.thinkquest.org/2705/history.html] Wichtige Ereignisse in der AI Geschichte

>[www.aaai.org/Library/Magazine/Vol19/19-02/vol19-02.html] Hier befindet sich ein Artikel über Ramón Lull

Print:

>Daniel Crevier: Eine schöne neue Welt? ECON Verlag. Düsseldorf,

Wien, New York 1994

>Steve Tarrance, The Mind and the Machine, philosophical

aspects of artificial Intelligence

>Jörg Papke, Markus Schröder, KI, Geschichte, Grundlagen,

Perspektiven, Grenzen, Studienarbeit an der TU Berlin 1986

>Dreyfus u Dreyfus, KI von den Grenzen der Denkmaschine und

dem Wert der Intuition

>U. van Essen; Bedrohungsmodell in KI-Systemen

>Barbara Becker, Künstliche Intelligenz, Konzepte, Systeme,

Verheißungen, 1992, Campus Verlag

>„Informatik – Fluch oder Segen“, Andrea Sieber, Martin Söns,

Werner Dilger; Ergebnisse des Seminars “Informatik, KI und Kritik”, 8.

Juli 1999, TU Chemnitz

>Heinz Zemanek, Das geistige Umfeld der Informationstechnik,

8. Vorlesung: Menschliche und künstliche Intelligenz, Springer-Verlag

Berlin Heidelberg New York 1992

>Kenneth M. Ford und Patrick J. Hayes, Neue Wege zur denkenden

Maschine, in: Spektrum der Wissenschaft Spezial, Nachdruck 1/2000, Spektrum

der Wissenschaft Verlagsgesellschaft mbH, Heidelberg Juli 1999, unveränderte

Neuauflage Oktober 2000

>Heinz Zemanek, Computer, Gehirn und Bewusstsein in der Sicht

der Informatik, in: Ausgewählte Beiträge zu Geschichte und Philosophie

der Informationsverarbeitung, Schriftenreihe der OCG, Verlag Oldenbourg

Wien München 1988

>Ludger Pfeil, Künstliche Intelligenz und sprachanalytische

Philosophie, Wissenschaftlicher Verlag Trier 1990

>Helmut Schauer, Michael Tauber (Hrsg.), Informatik und Philosophie,

Verlag Oldenbourg Wien München 1981

>Alfred Kobsa, Künstliche Intelligenz und Kognitive Psychologie,

in: Informatik und Psychologie, herausgegeben von Helmut Schauer und Michael

Tauber, Verlag Oldenbourg Wien München 1982

>[Entstehungskontext.deklarative Sprachen@Programmiersprachentypen] Logik, wie wir sie heute kennen geht in ihren Ursprüngen auf das antike Griechenland zurück. Zwar hatten andere Kulturen wie etwa die Ägypter bereits eine sehr komplexe Mathematik entwickelt, die Methode des logischen Schließens von bekannten Tatsachen auf weitere, neue Tatsachen wurde erst von den alten Griechen bewusst angewandt und untersucht.

>[Entstehungskontext.deklarative Sprachen@Programmiersprachentypen] Ein Philosoph, der die Entwicklung der Logik voran trieb, war Leibniz. Leibniz entwickelte auch eine Rechenmaschine.