fit 2001>

Gruppenthema >

Interaktivität

Interaktivität

Interaktivität, Gesellschaftliches & Zukunftsaussichten

1. DVD

1a. Technik

Technisch unterscheidet sich die DVD fast gar nicht von einer herkömmlichen CD. Beide Scheiben haben einen Durchmesser von 120 Millimetern und sind 1,2 Millimeter dick. Selbst beschichtet sind beide Medien gleich.

Warum passen aber auf eine DVD so viel mehr Daten?

Ein Hauptpunkt ist der geringere Spurabstand (Track pitch). Der Abstand zwischen den einzelnen Spiralwindungen, die auf eine Scheibe gepresst werden, wurde von 1,6 mm bei der CD auf 0.74 mm bei der DV verringert.

Ein weiterer Grund ist, dass die minimale Pit- Länge (Pit sind die Rillen in der Scheibe, die die Zustände 0 und 1 unterscheiden) von 0.83 auf 0,4 mm reduziert.

Der dritte Grund, der nicht bei allen DVDs zum Tragen kommt, ist dass die Dicke der Beschichtung um die Hälfte verringert wurde, was zur Folge hat, dass man natürlich zwei Schichten auftragen kann.

So ergeben sich auch die Unterschiede bei den DVDs:

- DVD 5: einfach beschichtet und einseitig bespielt; Fassungsvermögen von 4,7GB

- DVD 9: zweifach beschichtet und einseitig bespielt; Fassungsvermögen von 8,5GB

- DVD 10: einfach beschichtet und beidseitig bespielt; Fassungsvermögen von 9,4GB

- DVD 18: zweifach beschichtet und beidseitig bespielt; Fassungsvermögen von 17GB

1b. Vorteil von großen Speichermedien

Dieses Kapitel beschäftigt sich mit dem Thema, warum ich so große Speichermedien brauche bzw. worin der Vorteil für den Heimanwender bei einer Video DVD liegt.

Erstens einmal um optimale Bildqualität zu garantieren, brauche ich Unmengen an Informationen. Diese Informationen schlagen sich natürlich in der Dateigröße nieder. Wenn ich z.B. von einer digitalen Videokamera aufnehme, bekomme ich auf einen Gigabyte unkomprimiert um die acht Minuten Video. Auf einer DVD werden die Videoinformationen im MPEG 2 Komprimierformat abgespeichert und zwar mit einer Auflösung von 500 Linien (besser als es mir jeder Fernseher darstellen kann).

Eine DVD bietet aber noch weit mehr Vorteile als „nur“ viel bessere Bildqualität:

- Perfekte Tonqualität: Audiodaten werden in Dolby Digital (AC3 oder DTS Format) abgespeichert, welches klanglich einiges über dem herkömmlichen Dolby Surround liegt.

- Verschiedene Sprachen: Auf einer DVD können bis zu acht verschiedene Sprachen sein, die man meistens während dem Film umschalten kann

- Bis zu 32 verschiedene Untertitel

- 4:3 oder/und 16:9 Videoformat

- Multi- Angle Funktion: Mit dieser Funktion kann man z.B. bei Sportberichten oder –filmen während dem Film den Kamerawinkel verändern.

- Multi- Story Funktion: Ich kann ins Geschehen des Filmes eingreifen und z.B. entscheiden ob der Film gut oder schlecht ausgeht.

- Animierte Menüs, die man intuitiv bedienen kann

- Zusatztitel: Es werden auf der DVD zusätzliche Tracks wie Making off, geschnittene Szenen usw. abgespeichert

1c. Der Unterschied zwischen DVD und VHS Filmen

Die oberen Kapitel haben schon die Möglichkeiten der DVD beschrieben und genannt. Der Unterschiede zwischen Filmen auf herkömmlichen VHS Bändern und einer DVD ist daher in einem Wort zusammenzufassen- Interaktivität.

Das macht sich schon bemerkbar, wenn ich meinen DVD Film in den Player lege. Als erstes kommt ein animiertes Menü, in dem ich intuitiv mit der Fernbedienung navigieren kann. Hier kann ich erstens Grundlegendes einstellen wie die Sprache. Will ich den Film auf Deutsch oder doch im englischen Original anschauen (oder überhaupt in einer anderen Sprache). Meist im selben Menü kann ich die Sprache des Untertitels angeben oder ob ich überhaupt keinen haben will.

Im Hauptmenü gibt es dann immer die Möglichkeit, Zusatzmaterial anzuschauen. Dies umfasst unter anderem Making off, geschnittene Szenen, Kommentare des Regisseurs, Biografien der Schauspieler, Soundtrack usw.

Es gibt dann auch die Möglichkeit, während des Filmes die Handlung zu verändern. Man kann hierbei auf ein alternatives Ende zurückgreifen.

Während dem Film verändern kann man auch die Kameraperspektiven, was vor allem bei Sportfilmen bzw. –berichten interessant ist.

Nicht direkt interaktiv ist die Komponente Klang. Sie schafft es auf Grund der Dolby Digital Kodierung einen in das Geschehen hinein zu versetzen. Man hat nicht wie bei Dolby Surround nur vier Kanäle (Center, Rechts, Links, Hinten) sonder sechs Kanäle (Center, Rechts, Links, Rechts hinten, Links hinten, Subwoofer). Auf Grund der Tatsache, dass der Subwoofer bei Dolby Digital extra angesteuert wird, lässt sich auch die Bezeichnung 5.1 erklären- 5 Surroundlautsprecher und ein Subwoofer.

Da bei AC3 und DTS (den zwei verbreitetsten Digitalformaten) die hinteren Lautsprecher getrennt (in Stereo) angesteuert werden, kommt der DVD Benutzer in den Genuss eines viel größeren Surroundspektrums. Man glaubt wirklich, dass man sich im Geschehen bzw. im Film befindet.

Alle diese Eigenschaften machen DVD zu einem perfekten interaktiven Heimkinoerlebnis, dem herkömmliche VHS- Filme nichts mehr entgegen zu setzen haben.

2. Videoschnitt/ -bearbeitung

2a. Hardware

Videoschnitt in einfacher Form ist heutzutage kein Problem mehr. Die meisten Rechner sind bezüglich ihrer Hardware leistungsstark genug, um mit dem Quantum an Datenmengen, wie sie beim Videoschnitt verarbeitet werden, umgehen zu können. Natürlich braucht man Zusatzhardware, um wirklich seinen eigenen Urlaubsfilm perfekt in Szene setzen zu können.

Kamera:

Fangen wir beim logischen Punkt an, der Videokamera. Im Endeffekt gibt es zwei digitale Videoformate- Digital 8 und DV (Digital Video), wobei es bei DV wieder einen Unterschied zwischen DV und Mini DV gibt. Bei Mini DV sind die Speichermedien, sprich die Kassetten, wesentlich kleiner als bei DV, was dazu führt, dass auch die Kameras wesentlich kompakter gebaut sind.

Digital 8 hat einen großen Vorteil: Es ist kompatibel zum alten- analogen- Hi 8. Das heißt ich kann meine alten Filme hernehmen, sie in eine Digital 8 Kamera geben und sie dann „digitalisieren“. Digitalisieren unter Anführungszeichen, da die Qualität natürlich nicht besser wird als sie ist, ich aber beim weiterbearbeiten zumindest keine weiteren Qualitätseinbußen hinnehmen muss, was sehr wohl der Fall wäre, wenn ich sie analog bearbeiten würde. Ein weiterer Vorteil der Digitalisierung ist natürlich die Beständigkeit des aufgenommenen Materials. Ich habe auch noch in 40 Jahren die gleiche Qualität.

Der große Vorteil bei Mini DV ist, wie schon angesprochen, natürlich die Kompaktheit. Deswegen natürlich auch generell sehr beliebt- die Kameras sind auch bekannt unter dem Namen Handycams. Sie passen wirklich in eine Hand und sind sehr angenehm vor allem wenn man unterwegs ist. Teilweise sind sie nicht mehr viel größer als manche Fotoapparate.

Wichtiges Detail bei beiden Kameratypen: Je nach Preisklasse besitzen die Kameras einen DV Ein- und Ausgang beziehungsweise nur einen Ausgang. Ist insofern relevant, als dass ich mein bearbeitetes Material dann auf dem Videoband wieder digital abspeichern kann, was mich am Computer viel Speicherplatz kosten würde.

Schnittkarte:

Da beim Überspielen des Bildmaterials riesige Datenmengen zum Computer transportiert werden, reichen herkömmliche Standards nicht aus, um Video in Echtzeit zu überspielen. Daher gibt es sogenannte Firewire Schnittstellen, die jetzt immer mehr nicht nur für Videoschnitt, sondern allgemein verwendet werden, um Peripheriegeräte wie DVD Laufwerke, Brenner und externe Festplatten anzuschließen. Dieser Standard garantiert hohe Übertragungsraten und ist daher optimal geeignet für den Videoschnitt am PC und am Mac. Hierfür brauchen sie natürlich auch auf ihrem Computer einen Firewire Anschluss, da dieser noch nicht Standard bei PC`s ist. Und damit nicht die ganze Videobearbeitung ihr Prozessor vornehmen muss, kauft man am Besten gleich eine Videoschnittkarte. Diese hat zumindest einen Firewire Anschluss und schafft es bestimmte Videoeffektberechnungen hardwareseitig zu übernehmen, damit das Rendering des Filmes wesentlich schneller funktioniert.

Ein weiterer Vorteil, wenn man jetzt den Computer durch ein Firewire Kabel mit der Kamera verbindet ist, dass ich wirklich nur ein Kabel brauche, welches mir Audio-, Videodaten und die Steuerung der Kamera übernimmt, damit ich meine Kamera komplett vom Computer aus steuern kann.

Software:

Um die zwei Komponenten, Kamera und Schnittkarte, richtig nutzen zu können, brauche ich natürlich die entsprechende Software. Diese ist bei den meisten Schnittkarten schon dabei.

Mit ihr kann ich mein Rohmaterial in den Computer einspielen. Danach die Szenen anordnen wie ich sie brauche, Überblendungen einfügen und Titel. Natürlich den ganzen Film dann noch nachvertonen, damit ich zum Beispiel eine passende Hintergrundmusik habe und mir das Ergebnis dann in der Vorschau ansehen. Diese ist natürlich in relativ schlechter Qualität, aber ich merke hier schon an der Rechendauer, dass der Computer einiges zu tun hat. Das abspeichern des Endproduktes dauert natürlich noch einmal länger. Hab ich dann meinen fertig bearbeiteten Film kann ich ihn entweder vom Computer aus direkt auf einen VHS Rekorder überspielen oder, wenn ich in digital abspeichern will, wieder zurück auf meine Videokamera.

Das ganze ist natürlich sehr zeitaufwendig und auch kostenintensiv, aber ich kann wirklich selbstständig meine Filme bearbeiten und bestimmen, welche Szenen ich jetzt auf Band haben will oder nicht. Zusätzlich kann ich nette Effekte einfügen ebenso wie Titel und Hintergrundmusik. Und das, in der Grundform, eigentlich sehr einfach.

3. Videoconferencing

3a. Allgemeines zu Videoconferencing

Mit Videoconferencing ist es ähnlich wie mit dem Telefon – es verbindet Menschen. Jedoch mit dem einem großen Vorteil: Beim Videoconferencing kann man seinen Gesprächspartner nicht nur hören, sonder auch sehen. Mit allem, was dazu gehört: Mimik, Gestik, Reaktionen,... . Videokonferenzsysteme ermöglichen aber auch die gemeinsame Arbeit an Dokumenten und Unterlagen und dabei hat man immer das Gefühl, man würde mit seinem Gegenüber im gleichen Raum sitzen.

Durch die Hilfe von Videoconferencing ist es möglich noch effektiver miteinander zu arbeiten, da der Vorteil der visuellen Kommunikation genutzt wird, die ja die natürlichste aller Kommunikationsarten ist.

Die Nützlichkeit von Videoconferencing besteht nun darin, dass die Teilnehmer trotz Entfernung im wahrsten Sinne des Wortes „interagieren“ können. Dabei ist es völlig egal, ob die Gesprächspartner 10 Gehminuten oder 10 Flugstunden voneinander entfernt sind. Per Videokonferenz zu kommunizieren bedeutet also seine Arbeitszeit wirkungsvoll einzusetzen.

3b. Vorteile

Videoconferencing bringt zahlreiche Vorteile mit sich, die sich in drei Gruppen kategorisieren lassen. In „harte“, messbare Faktoren, sowie in „weiche“ und „strategische“ Faktoren, die wesentlich schwieriger zu messen sind. Im Rahmen der Entscheidungsfindung sollten jedoch alle Faktoren berücksichtigt werden.

Harte Faktoren:

Reduzierte Kosten: Weniger Reisekosten

Höhere Produktivität: Die Zeit, die sonst durch reisen verloren geht, kann statt dessen für produktive Arbeit genutzt werden.

Optimierte Ressourcen-Nutzung: Experten und Fachwissen sind leichter zu erreichen.

Weiche Faktoren:

Verbesserte Kommunikation:Mitarbeiter kommen öfter zusammen und tauschen sich regelmäßiger aus

Schnellere Entscheidungsfindung:Videoconferencing garantiert schnellere Erreichbarkeit der wichtigen Entscheider.

Höhere Lebensqualität: Weniger Zeit und Energie geht für Reisen verloren, Stress wird abgebaut.

Mehr Umweltfreundlichkeit: Weniger schädliche Emissionen von Pkws oder Flugzeugen, dadurch höheres Ansehen des Unternehmens.

Strategische Faktoren:

Optimierte Entscheidungsfindung:Unabhängig von Ihrem Standort können Teams wesentlich produktiver miteinander arbeiten, und Entscheidungen werden nicht nur schneller, sondern mit größerem Konsens und eindeutiger Zustimmung von jedem Beteiligten getroffen.

Unverzügliches Krisenmanagement:Krisensituationen lassen sich ohne große zeitliche Verzögerung rund um den Erdball managen.

Schneller am Markt: Abstimmungsprozesse werden erheblich verkürzt, und neue Produkte können schneller auf den Markt gebracht werden.

Größere Kundenzufriedenheit: Mit einer optimiertenErreichbarkeit der Mitarbeiter kann die Kundenzufriedenheit maßgeblich gesteigert werden.

3c. Die 3 Formen der Videokonferenz-Verbindungen

Punkt-zu-Punkt Videokonferenzen

Die meisten Videokonferenzen werden als Punkt-zu-Punkt Verbindung aufgebaut, d.h. zwei Videokonferenzsysteme werden über ein Netzwerk (bsp. ISDN) direkt miteinander verbunden. Diese Verbindung ist vergleichbar mit einem normalen Telefongespräch mit dem Unterschied, dass zusätzlich zur Sprach- eine Bildverbindung aufgebaut wird.

Punkt-zu-Mehrpunkt Videokonferenzen

Punkt-zu-Mehrpunkt Verbindungen werden „lecture mode“ oder auch „broadcast mode“ genannt. Bild und Ton von einem definierten Standort (lecture) wird an mehrere andere Standorte übertragen. Anhängig von der Anzahl der Standorte ist hierzu eine sogenannte Multipoint-Brücke notwendig, die entweder im Unternehmen vorhanden ist oder als Dienstleistung extern eingekauft wird. Unternehmen setzen Punkt-zu-Mehrpunkt Verbindungen zur Schulung oder Information von Mitarbeitern und Kunden ein.

Mehrpunktkonferenz (Multipoint Videokonferenzen)

Bei einer Multipoint Videokonferenz können mehrere Standorte miteinander kommunizieren, wobei jeder jeden sieht und hört. D.h. alle Standorte sind gleichberechtigt. Bei Multipointkonferenzen gibt es mehrere Möglichkeiten der Bild- und Tondarstellung:

Continuous Presence: Mehrere Standorte können gleichzeitig auf dem Bildschirm dargestellt werden. Üblich sind Aufteilungen zu einem 4er Split.

Sprachgesteuert (Voice Controlled): Auf dem Bildschirm alle Lokationen erscheint der Teilnehmer, der gerade spricht.

Manuelle Auswahl (Chairman Control): Lediglich das Bild des gewählten Teilnehmers wird in Vollgröße gezeigt.

3d. H.323: Der Standard

Ein übergreifendes Standardisierungsgremium hat bereits 1990 mit der H.320-Norm die Richtlinien für ISDN-Videoconferencing festgelegt. Die hohen Anschaffungs- und Telefonkosten durch die parallele Nutzung mehrerer B-Kanäle haben bisher die flächendeckende Verbreitung des ISDN-Conferencing verhindert.

H.323 ist ein nach außen offener Standard. Die Kamerawahl ist dem Anwender überlassen. Selbst für die Umwandlung analoger Videosignale in digitale Daten kommen unterschiedlichste Systeme wie USB-Kameras, Grabber-, Grafik- und Videokarten in Frage. Neben speziellen platzsparenden Videokonferenzkameras kommen als Bildlieferanten auch Camcorder in Frage, die durch ihre Zoomfunktion eine bessere Festlegung des übertragenen Arbeitsplatzausschnitts erlauben. Digitale Kameras nach dem DV-Standard werden bisher nicht direkt unterstützt. Hier ist der Umweg über das analoge Chinch- oder Hi-8 Kabel und einen Videograbber erforderlich.

Ähnlich offen ist der H.323 Standard für den Ton. Auch dieser kann durch handelsübliche Soundkarten aufgezeichnet werden. Die unterschiedlichen Codecs stehen dabei für variierende Sprachqualität.

Systemsteuerung und User-Interface unterscheiden sich von Hersteller zu Hersteller, wobei die Anordnung und das Aussehen der Videofenster eher Geschmackssache sind. Entscheidender sind hier die Vollduplexfähigkeiten. Nicht alle Programme unterstützen sie und erwarten zur Tonübertragung das explizite Drücken einer Sprechtaste. Die clevereren Programme hingegen reduzieren die Datenmenge durch die allgemeine Geräuschpegelmessung bei der Mikrofoninstallation. Nur bei Sprachsignalen, die diesen Geräuschpegel überschreiten, kommt es zur Übertragung. Klar definiert sind wiederum die Systemkontrollen wie etwa die Anrufentgegennahme.

Anders als bei Videorecordern oder DVD Laufwerken, bei denen unterschiedliche Videonormen wie PAL oder NTSC beziehungsweise Ländercodes das Leben schwer machen, haben die Entwickler der Videokonferenzstandards hier glücklicherweise einen übergreifenden Standard gefunden.

3e.TCP/IP als Verbindungsprotokoll

Sowohl im LAN als auch im Internet wird als Protokoll TCP/IP vorausgesetzt. Hieraus resultiert eine Besonderheit. Während die IP-Adressen im lokalen LAN konstant sind, erhalten die meisten Internet-Anwender beim Login eine dynamisch zugewiesene IP. Anders als beim Telefonieren kann man also die Gegenstelle nicht ohne weiteres zielgerichtet ansprechen.

Entsprechend bieten alle Konferenzsoftware-Hersteller eigene Anmeldeserver an. Hier können die Partner nach den gewünschten Teilnehmern Ausschau halten - vorausgesetzt, sie sind zum vereinbarten Zeitpunkt online. Da es sich hierbei allerdings um öffentliche Listen handelt, ist dies ein nicht für alle Bereiche des Geschäftslebens gangbarer Weg.

Die Alternativen: Nach Zuweisung einer festen IP können direkte Anrufe getätigt werden. Wer nur selten diese Funktion benötigt, kann sich bei entsprechenden Service-Providern einen virtuellen Konferenzraum unter einer festen IP reservieren lassen. Sie bieten dann in der Regel gleichzeitig die Möglichkeit der Protokollübertragung, so daß H.232-, H.320- und H.324-Teilnehmer gleichzeitig an der Konferenz teilnehmen können.

Wer öfter konferieren möchte und in zusammengewachsenen internationalen Firmen tätig ist, fährt mit dem Einsatz eines eigenen Servers am besten. Er kann mit einer einzigen festen IP ausgestattet werden und stellt sämtliche für die Firma notwendigen Kommunikationsräume bereit, sei es für das Einzelgespräch oder für die Themenkonferenz.

Gesellschaftliches / Zukunft

1. Videoformate

1a. MPEG

Allgemeines über die ersten MPEG-Formate

Während es sich bei den meisten verfügbaren Kompressionsverfahren um proprietäre Formate handelt, schafft die Moving Pictures Expert Group MPEG, öffentliche Standards, die jeder – gegen Lizenzgebühren – verwenden beziehungsweise selbst implementieren darf.

Der erste Multimedia-Standard des MPEG-Komitees, MPEG-1, definierte ein Format für Digital-Video mit Datenraten von etwa 1,5 Mbit/s. Es war vornehmlich zur Wiedergabe über 1x-CD-ROM-Laufwerke gedacht (Video CD). Qualitativ sollte das hierfür vorgesehene Standardprofil einer VHS-Aufzeichnung ebenbürtig sein. Nichtsdestotrotz kann MPEG-1 auch Videos mit großen Datenraten/Auflösungen kodieren.

MPEG-1 setzt im Wesentlichen auf eine Kombination von JPEG (Einzelbildkompression) und Techniken zur Kompression von Bewegtbildern.

Die Vertonung von MPEG-1-Videos wird normalerweise vom MPEG-1 Layer I und II bewerkstelligt. Währenddessen dient der dritte und bekannteste Vertreter, MPEG-1 Layer III (MP3), de facto als reines Audioformat. Erst DivX und OpenDivX nutzen MP3 tatsächlich als `Tonspur`.

Um einige Beschränkungen von MPEG-1 aufzuheben, begann man 1990 mit der Entwicklung einer Erweiterung des Formates, um `digitales Fernsehen` und später DVD-Video aus der Taufe zu heben. MPEG-2 definierte das Kompressionsverfahren für Standard Defintion Television (SDTV). Es ist im Unterschied zu MPEG-1 darauf ausgelegt, Videomaterial nicht nur progressiv (in Vollbildern) zu kodieren, sondern unter Ausnutzung der Korrelation zwischen den Halbbildern analoger Fernsehsignale eine höhere Kompressionsrate zu erzielen.

Um verschiedenen Einsatzgebieten gerecht zu werden, verfolgt MPEG-2 einen Baukastenansatz, der auf verschiedene `Tools` für unterschiedliche Bildformate und Qualitätsstufen setzt. Am weitaus häufigsten wird jedoch die zu TV- und DVD-Auflösungen konforme Konfiguration `Main Profile at Main Level` (MP@ML) eingesetzt.

MPEG-3 war als MPEG-Erweiterung für High Definition Television (HDTV) gedacht, wurde allerdings wieder verworfen, da man plötzlich feststellte, dass MPEG-2 diese Aufgabe bereits erfüllte.

Im Unterschied zu den Vorgängern will das MPEG-Komitee sein jüngstes Werk MPEG-4 als Universallösung für komprimierte Multimedia-Daten platzieren. Der MPEG-4-Standard beschäftigt sich mit dem Übertragen verschiedener Media-Objekte über einen gemeinsamen Datenkanal sowie mit der Möglichkeit zu Interaktionen durch den Anwender.

Was ist neu an MPEG-4?

Eine weitere Ausprägung des MPEG Formats ist ursprünglich für Anwendungen niedriger und niedrigster Bandbreite entwickelt worden, da diese insbesondere für Internet-Übertragung audiovisueller Inhalte interessant ist. An MPEG-4 wurde schon seit 1996 für den Mobilfunkbetrieb intensiv geforscht. Der momentan aktuelle Layer 2 beinhaltet allerdings wesentlich mehr als nur extrem hohe Kompressionsraten.

So ist er mehr als ein Kombination der MPEG 1 und 2 Techniken mit zusätzlichen Multimedia Elementen zu verstehen. Neben einer speziellen Version der DCT arbeiten hier auch wieder die Motion-Compensation und eine zusätzliche Audiokompression an den Daten.

Erstmals wird bei einem Bild neben der Bewegung (Motion) und der Textur auch die sogenannte Form übergeben (Shape).

Damit ist es möglich mit Hilfe sog. „Sprites“ beliebig konturierte Standbilder über die sich bewegenden Bilder zu schieben.

Außerdem erweitert MPEG 4 die Darstellung hin zu 3D-Objekten, einer VRML-ähnlichen Scriptsprache und einer Java-Schnittstelle zur Ansteuerung externer Hardware.

Die Kompressionsrate für Bilder ist bei MPEG 4 nicht höher als bei MPEG 2. Lediglich Sprites können sehr viel höher komprimiert werden, weil dem Coder dafür wesentlich mehr Zeit zur Verfügung steht.

MPEG 4: Extrem flexibel

MPEG 4 vereinigt zahlreiche unterschiedliche Ansätze, multimediale Inhalte komprimiert darzustellen. Erwähnenswert ist die extreme Fehlertoleranz mit Hilfe eines rückwärts lesbaren Codes, die für den mobilen Funkbetrieb unerlässlich ist, bei stationären Anwendungen allerdings keinen Vorteil bringt.

Erstmals sind in MPEG 4 auch sicherheitstechnisch relevante Anwendungen denkbar, wie z.B. die objektorientierte Darstellung einer Überwachungskamera. Solange sich das Objekt „Hintergrund“ nicht verändert, kann er sehr stark komprimiert werden, Dadurch steht dem Objekt „Vordergrund“ fast die volle Bandbreite zur Verfügung. Darin enthaltene bewegte Objekte können daher mit hoher Qualität dargestellt werden.

Anwendungsgebiete von MPEG 4

Bisher ist „MPEG 4“ als kompletter Standard noch nicht verabschiedet. Die bisher existierenden Implementationen stützen sich immer nur auf einen Teilaspekt. So ist beispielsweise „DivX ;-)“ – Codec für Windows nur auf Video ausgelegt, ohne die restlichen beschriebenen Aspekte zu berücksichtigen.

Gedacht ist MPEG 4 neben Video aber auch für folgende Bereiche:

Echtzeitkommunikation (Delay unter 400ms)

Überwachung/Sicherheitstechnik

Mobile Multimedia (u.a. UMTS)

Infotainment

DVD (Neue Formate und Geräte)

Streaming Video im Internet

Broadcast/Sendetechnik

Set-Top Boxen für Digital TV

TVML (TV Meta Language ähnlich VRML)

Meetings unter Ausnützung von Modellierung virtueller Gesprächspartner

Digitaler AM Rundfunk (Lang-, Mittel-, Kurzwelle)

Interaktive grafische Anwendungen (mit synthetischem Inhalt)

Ausblick

Der erste Schritt, MPEG-4, Layer 2 ist im Oktober 2000 verabschiedet worden. Jetzt geht es für die Hard- und Software-Hersteller an die Implementierung. Was sich heute "MPEG-4" nennt, wird relativ sicher mit zukünftigen Implementationen inkompatibel sein. Für die Video-Codecs eines Windows-PCs ist die Kompatibilität aber so lange gegeben, wie sie noch auf den nächsten Windows-Versionen laufen. Dies ist seit Windows 3.1 der Fall.

Wie komplex die Funktionalität von MPEG-4 ist, kann man an der Einzeldefinition von über 40 Profilen sehen, die jeder eine eigene spezielle Anwendung darstellt. Darunter befinden sich Profile nur für Audio, Video, Grafik und 2/3D-Darstellung.

Ausblick auf MPEG 7 und MPEG 21

Heutzutage treten immer häufiger audiovisuelle Informationen in digitaler

Form, an verschiedensten Orten der Welt auf. Diese Informationen wollen

natürlich auch genutzt werden, doch bevor jemand die Informationen nutzen kann,

müssen diese erst lokalisiert werden.

Zugleich macht die steigende Verfügbarkeit von potentiell interessanten

multimedialen Material die Suche schwieriger. Momentan existieren Lösungen, die

das textbasierte auffinden von Informationen ermöglichen. Die

hochfrequentierten textorientierten Suchmaschinen des WWW zeigen, das der

Bedarf nach Informationslokalisierung sehr groß ist.

Die Identifikation von audiovisuelle Medien ist zur Zeit noch nicht möglich, da

keine generelle Erkennung der Beschreibung dieser Materialien existiert.

Somit ist keine effiziente Web-Suche nach z.B. dem Motorrad aus dem Film

Terminator II, oder nach einem bestimmten Videoausschnitt des Gates Verhör ,

oder nach 20 min. Video nach meinen (voreingestellten) Vorlieben möglich. In

speziellen Fällen existieren Teillösungen, so ist z.B. in heutigen speziellen

Multimedia-Datenbanken die Suche nach charakteristischen Farben, Texturen, oder

Oberflächenbeschaffenheiten von Objekten möglich.

Die Frage nach dem Auffinden von multimedialen Inhalten ist nicht nur auf

Datenbank-Retrieval-Anwendungen beschränkt, sondern ist z.B. auch interessant,

wenn es um eine Auswahl an potentiell interessanten digitalen Fernseh-, oder

Radiosendern geht, die heute in einem immer größer werdenden Angebot

konkurrieren

MPEG-7 soll eine Schnittstelle für die Beschreibung von Multimediainhalten sein, dass eine gewisse Interpretation von Information durch einen Computer ermöglicht. Bilder, Graphiken, 3D-Modelle, Ton, Sprache, Video können mit Hilfe von MPEG-7 indiziert und durchsucht werden. Dieser Standard soll dazu dienen, die Vielzahl an audiovisueller Information beispielsweise im Internet aufzuspüren.

Um Inhalte genau beschreiben zu können, müssen die Forscher Formalismen entwickeln. Diesen liegt eine Analyse der betreffenden Datenstrukturen zu Grunde. Die MPEG-7-Beschreibungen werden aber nicht automatisch aus dem Material extrahiert, sonder MPEG-7 hilft nur, eine einheitliche Beschreibung zu treffen. Dabei werden bestehende Systeme wie SGML beziehungsweise XML genutzt.

Ebenso wie MPEG 4 unterschiedliche Ziele im Vergleich zu MPEG 1/2 verfolgt, ist auch MPEG 7 keine Weiterentwicklung, sondern ein ergänzendes `Multimedia Description Scheme` (MDS) zur Indizierung audiovisueller Inhalte über Meta-Daten. Dieser neue Technikstandard wird multimodale Suche genannt. Man kann, laut MPEG-7-Entwickler Wolfgang Putz, dem Computer eine Melodie vorsummen und er zeigt einem dann einen Filmausschnitt, in dem ein Schauspieler diese Melodie pfeift.

Kommerzielle Anwendungen werden bereits in zwei Jahren auf den Markt kommen. Es gibt aber schon heute an der GMD ein MPEG-7-Kamerasystem, das neben Bild und Toninformationen beschreibende MPEG-7-Information sammelt und entsprechend umsetzt.

Nützlich sind MPEG-7 Anwendungen nicht nur für den privaten Gebrauch, sondern auch in der Bildung, in biomedizinischen Anwendungen, Einkauf und Unterhaltung, bei geographischen Informationssystemen und Überwachungsaufgaben wie der Verkehrskontrolle. So suchen die Forscher nach Möglichkeiten, die Datenbanken mit Satellitenbildern mit Hilfe verschiedener Beschreibungsmodalitäten für Geologen, Wissenschaftler, aber auch dem Militär schneller zugänglich zu machen. Ähnliches gilt für Überwachungskameras, die aufgrund von Objektbewegungen Situationen analysieren oder Gesichter erkennen sollen.

Auch Journalisten, Detektiven und Strafverfolgern wird MPEG-7 gründlich unter die Arme greifen. Detektive und Strafverfolger arbeiten mit forensischen Methoden oder mit der Wiedererkennung bestimmter Körpermerkmale. Journalisten können beispielsweise nach Reden eines bestimmten Politikers suchen, indem sie einen Namen, eine Stimme oder ein Gesicht angeben. Auch im Schulunterricht sollen MPEG-7-Videos künftig zeitgeschichtliche Ereignisse besser vermitteln, indem Radio-, Fernseh- und Filmbeiträge nach Zeitpunkten, Orten und Persönlichkeiten beschrieben werden und so einer Suche zugänglich gemacht werden können.

Andere Anwendungen die ebenfalls von dem MPEG-7 Standard profitieren werden: digitale Bibliotheken (Bildkatalog, Musiklexikon, ...), multimedia "directory services" (gelbe Seiten, ...), selektives multimedia Übertragung (Radio, Fernseh, ...).

Schlussendlich soll MPEG-7 die Datenquellen globalisieren: Die MPEG-7-Beschreibungen können mit dem entsprechenden audiovisuellen Material gespeichert sein, aber auch an einem anderen Ort. Inhalt und Beschreibung können auch mit Links verbunden sein. Deshalb muss MPEG-7 die Interoperabilität von Inhaltsbeschreibungen erlauben. Schon bald werden also Datenbanken mit MPEG-7-Beschreibungen entstehen, auf die Nutzer über das Internet schnell zugreifen können.

Eine Verabschiedung von MPEG 7 ist für Juli 2001 geplant.

Seit Juni letzten Jahres ist noch ein neuer MPEG-Standard in Arbeit – MPEG 21. Hier geht es um ein so genanntes "Multimedia Framework", also ein Multimedia-Rahmenwerk für die Übertragung elektronischer Inhalte. Im Rahmen der Arbeitsgruppe geht es zuerst um die Prüfung, ob die jetzigen MPEG-Standards für die Übermittlung aller denkbaren elektronischen Inhalte ausreichen oder ob noch weitere zu definieren sind. Deswegen ist MPEG-21 als allumfassendes Gesamtkonzept geplant, dass noch bestehende MPEG-Lücken schließen soll und notfalls bis Herbst 2002 neue Standards definieren.

1.b DivX ;-)

Was ist DivX?

DivX ist ein auf MPEG-4 basierendes Kompressionsformat, dass den Film einer DVD-Video statt im MPEG-2- im MPEG-4-Format zu speichern erlaubt.

Mit dem DivX-MPEG-4-Format lässt sich der Inhalt einer DVD bei einer VHS überlegenden Qualität um den Faktor 10 bis 12 reduzieren – statt 6 GByte benötigt ein zweistündiger Film unter 700 MByte. Damit existiert auch ein Format, um DVD-Video digital zu speichern: Es ist die herkömmliche CD-R. Selbst hochauflösende DIVX-Videos in Auflösungen von 640x480 sind daher vom Platzbedarf her geringer als herkömmliche MPEG-1 Dateien im VCD-Format. Die Enkodierung geht zudem in DivX wesentlich schneller als bei gewöhnlichen MPEG-Enkodern.

Für den Heimanwender gab es bislang nur recht begrenzte Möglichkeiten zur digitalen Videoerstellung. Man musste sich mit MPEG1 und dessen begrenzten Möglichkeiten zufrieden geben. In MPEG-1 passten etwa 40 Minuten Video auf einer CDR in guter Qualität.

Da sich in den letzten Jahren Geschwindigkeit und Festplattenkapazität der Rechner vervielfacht hat, ist damit auch die früher benötigte Zusatzhardware zum Aufzeichnen hochauflösender Videos nicht mehr nötig. Eine normale TV-Karte reicht und die Enkodierung erledigt kostenlose Software aus dem Internet.

Gehackter Microsoft Codec?

Die Macher von DivX brüsten sich damit, einen MPEG-4-Coedc von Microsoft gehackt zu haben. Vom Software-Riesen wurde diese Behauptung bislang weder bestätigt noch dementiert. Denn bislang hat Microsoft den DivX-Code anscheinend noch nicht genau analysiert.

Der Hack bei DivX besteht dem Anschein nach lediglich aus zwei Punkten:

- Erhöhung der Bitrate auf bis zu 6000 KBit/s

- Einschalten eines Weichzeichners vor dem Encoding.

Microsoft erste Implementation von MPEG-4 wird seit Windows 98 mit jedem Windows installiert. Sie beschränkt jedoch die maximale Datenrate auf 256 KBit/s, was viel zu wenig ist für flüssiges Video in hoher Auflösung und guter Qualität.

Mit dem DivX-Codec sind aber Bitraten von 6000 KBit/s möglich. Um einem Film von 120 Minuten auf eine CD mit 650 MByte zu packen, sind jedoch Datenraten um 600 KBit/s ausreichend. Bei Datenraten von 1500 KBit/s für 90 Minuten auf zwei CDs ist das Bild kaum noch von der einer DVD zu unterscheiden.

Der Weichzeichner vor der eigentlichen Codierung ist einer der Tricks, die die starke Kompression möglich machen. MPEG-Verfahren benötigen bei hohen Kontrastsprüngen hohe Datenraten, da für ein scharfes Bild mehr hochfrequente Signale erforderlich sind, und die treiben die Datenrate in die Höhe. Wenn diese nicht zur Verfügung steht, wird das Bild mit hässlichen Artefakten ("Klötzchen") versehen. Bei einem weniger scharfen Ausgangsbild ist auch eine niedrigere Datenrate ausreichend, um diese Artefakte zu vermeiden.

DivX alleine kümmert sich nur um Video - für den Ton wird meist MP3 verwendet. Daher steckt im Download-Paket von DivX auch eine gehackte Version des originalen MP3-Encoders des Fraunhofer Instituts. Während der rechtliche Status des angeblichen Microsoft-Codecs noch unklar ist, ist dieser MP3-Codec klar urheberrechtlich geschützte Software.

Zukunft von DivX

Der Nachfolger des MPEG-4-Codecs DivX darf in Zukunft auf breite Unterstützung hoffen. Um mehr Programmierer für die Beteiligung an dem so genannten „Projekt Mayo“ zu gewinnen, haben sich die Entwickler um Joe Bezdek („Direktor of Product Defintion“ von Project Mayo) entschlossen, den aktuellen En- und Decoder-Kern des Videoformates unter der Bezeichnung „OpenDivX als Open Source freizugeben. Damit soll eine möglichst weite Verbreitung über Plattformen und Geräte hinweg gefunden werden.

Die DivX-Entwickler sind, nach eigenen Angaben, derzeit an einem Punkt angelangt, an dem der Code der Allgemeinheit zur Verfügung gestellt werden könne, um eine qualitativ hochwertige Weiterentwicklung gewährleisten zu können.

OpenDivX ist nur ein Schritt auf dem Weg zur Verwirklichung größerer Ziele: einem vielseitigem Video-Codec – von den Programmierern „DivX Deux“ getauft – der hohe Qualität bieten und gleichzeitig frei verfügbar sein soll.

OpenDivX basiert auf einer der Referenzimplementierungen von MPEG-4-Video und wurde vom Institut für Theoretische Nachrichtentechnik und Informationsverarbeitung (TNT) der Universität Hannover und dem Heinrich-Hertz-Institut Berlin (HHI) mitentwickelt und entstammt dem EU-Projekt `Mobile Multimedia Systems` (MoMuSys).

Bei OpenDivX handelt es sich um einen MPEG-4-konformen Codec, der allerdings bislang nur die Minimalfähigkeiten von MPEG-4 – das `Simple Profile` - beherrscht und daher viele der neuen Technologien vermissen lässt. Auch ist dieser Codec im Moment noch für niedrige Bitraten ungeeignet.

Die Filmindustrie dürfte angesichts dieser Entwicklung nicht sehr erfreut sein, hatte sich doch bereits DivX als Standard für den Austausch von Filmen und Videos über das Internet etabliert. Ein optimierter Codec, der bei gleicher Bitrate bessere Qualität verspricht und zudem für jede Plattform verfügbar sein soll, dürfte den Filmschaffenden kaum genehm sein. In Branchenkreisen werden daher bereits Befürchtungen laut, dass man über kurz oder lang eine analoge Entwicklung befürchten müsse, wie sie MP3 der Musikindustrie beschert hat.

Eine anderes Unternehmen, was ebenfalls auf der DivX-Welle mitschwimmt, ist die belgische Firma `Happy Machines`. Deren Entwicklerteam arbeitet derzeit an der Optimierung des DivX-Codec für Videos aus dem Internet und nennen diesen Code „3ivX“. Das Format „3ivX“ erlaubt eine noch geringere Dateigröße, höhere Bildqualität und eine schnellere Encodierung.

Der „3ivX“-Codec ist ein Format, das die Veränderungen von einem Frame zu einem nächsten Frame analysiert und speichert. Die mehr oder weniger großen Unterschiede bestimmen dann die Effizienz des Codecs und damit die Kompressionsstärke.

Der Code ist im Moment noch in der Beta-Phase, wird aber bereits in verschiedenen Versionen zum Kauf angeboten. Diese versprechen Features wie variable Bitraten, 2-Pass-Kodierung oder B-Frames.

1c. Streaming

Die Übertragung von Informationen in Echtzeit, und zwar unabhängig von ihrem Typ, setzt ausgetüftelte Mechanismen voraus. Nur so sind die unzähligen Probleme bei der Datenübermittelung zu lösen.

Die Übermittlung von Videoinformationen ist vom technischen Standpunkt her gesehen dem Datenaustausch bei der Internet-Telephonie sehr ähnlich.

Kontinuierliche Datenübertragung

Datenaustausch im Internet läuft normalerweise nach dem Store-and-forward-Prinzip ab. Das bedeutet, dass Daten auf entsprechenden Servern liegen und darauf warten, dass der Anwender sie abruft. Auch der E-Mail-Versand oder FTP-Zugriffe erfolgen nach diesem Schema. Bezeichnend ist, dass immer eine bestimmte Zeitspanne zwischen Entstehungs- und Verarbeitungsprozess liegt.

Bei der Streaming-Technologie ist das anders: Inhalte erscheinen bereits während der Übermittlung beim Anwender. Man spricht daher auch von Echtzeitübertragungen, da Daten ohne größere Zeitverschiebung vom Client wiedergegeben werden. Eines der größten Probleme bei derartigen Verfahren ist, dass Echtzeitanwendungen kurze Antwort- und Reaktionszeiten sowie einen kontinuierlichen Datenstrom erfordern. Da das Internet von seinen Ursprüngen her nicht auf solche Übertragungsformen vorbereitet ist, mussten die Anbieter dieser Technologien verschiedene Erweiterungen einführen. Das Resultat dieser Bemühungen sind die Streaming-Media-Technologien zur Übertragung von Bild und Ton.

Wie in fast allen Bereichen des Internets gibt es allerdings auch hier eine Vielzahl konkurrierender Lösungen, wobei sich drei Varianten zunehmend durchsetzen: Quicktime, Real Media und die Windows-Media-Technologie.

Das Prinzip der Streaming-Technik

Das zugrundeliegende Prinzip der nachfolgend beschriebenen Streaming-Verfahren ist immer gleich. Am Anfang stehen die unterschiedlichsten multimedialen Inhalte wie Videos, Audiodateien oder auch Grafikinformationen. Nach der Entwicklung beziehungsweise Aufnahme erfolgt die Digitalisierung. Im nächsten Schritt kommen spezielle Kodierprogramme zum Einsatz, die aus den Quelldateien das eigentliche Streaming-File erzeugen. Das Ergebnis lässt sich schließlich entweder auf einem Media-Server oder einem herkömmlichen Webserver ablegen.

Soweit zur Theorie. Die Probleme dabei lassen sich im Prinzip auf zwei wesentliche Punkte reduzieren: die schnelle Komprimierung/Dekomprimierung der Quelldateien und deren effiziente Verteilung über das Internet. Dient beispielsweise ein Video aus einer herkömmlichen analogen Kamera als Datenquelle, so belegt ein einzelnes Bild etwa 1,2 MByte Festplattenkapazität. Übertragen auf die in der Fernsehtechnik üblichen 25 Bilder pro Minute bedeutet dies, dass bereits ein kleiner Werbesport von 30 Sekunden Dauer 900 MByte Daten umfasst.

Um diese Informationen für das Internet brauchbar zu machen, werden verschiedenste Komprimierungstechniken verwendet, die die Datenmenge auf ein angemessenes Maß herunterschrauben.

Grundlagen der Streaming-Technik

Die zentrale Herausforderung für alle Anbieter von Streaming-Anwendungen ist die Reduktion riesiger Datenmengen auf ein für die Übertragung per Internet erträgliches Maß.

Um die Größe von Videodateien zu reduzieren, werden Komprimierungsverfahren verwendet. Dabei ist bei multimedialen Inhalten besondere Effizienz gefragt.

Bei der Übertragung von Videos kommen parallel mehrere Komprimierungsverfahren zum Einsatz. Reine Videoinformationen werden mit speziellen Video-Codecs, Audio-Inhalte hingegen mit Audio-Codecs bearbeitet. Microsoft verwendet beispielsweise für Videos MPEG4 und für Musik MS-Audio.

Das Prinzip der Streaming-Technologie: Zunächst werden die Quellinformationen kodiert, dann über einen Media- beziehungsweise Webserver veröffentlicht.

Um Streaming und Echtzeitübertragungen zu ermöglichen, reicht ein Protokoll leider nicht aus. Vielmehr sind mehrere Protokolle für die verschiedenen Aufgaben erforderlich.

Das Resource Reservation Protocol (RSVP) reserviert die erforderlichen Netzwerkressourcen für den Datenstrom. Gerade bei der Übertragung von Videoinformationen haben schon geringe Paketverluste oder Schwankungen der Verzögerung (Jitter) sehr negative Auswirkungen auf die Qualität.

Das Realtime Transport Protocol (RTP) sorgt für den Transport der Daten. Unter Verwendung von Zwischenpuffern, Zeitstempeln und Folgenummern ermöglicht RTP der empfangenden Station, fehlende, doppelte oder in falscher Reihenfolge empfangene Pakete zu erkennen und den Empfangsstrom zu korrigieren. Durch RTP kann die Synchronisation zwischen den Audio-, Video- und Dateninformationen hergestellt werden.

Das Realtime Streaming Protocol (RTSP) steuert den Datenstrom. Bei den Datenquellen kann es sich um Live-Daten oder Aufzeichnungen handeln. RTSP arbeitet mit gängigen Protokollen wie RTP und HTTP zusammen. RSTP ist HTTP in Syntax und Operation sehr ähnlich.

Die Synchronized Multimedia Integration Language (SMIL) ist für die Stream-Beschreibung und -Formatierung zuständig. Die XML-basierte Integrationssprache ermöglicht eine einfache, textgesteuerte Synchronisation von Multimedia-Anwendungen, wie es bei Streaming Video erforderlich ist.

Anwendungsmöglichkeiten

Dass solche Technologien gerade bei Firmen auf großes Interesse stoßen, ist klar: Videos bieten interessante Anwendungsbereiche - besonders im Intra- und Extranet, beispielsweise für Schulungen. Videos sind hierfür bekanntermaßen ein probates Mittel. Aber nicht nur auf lokaler Ebene machen Videoanwendungen Sinn. Genauso können Unternehmen per Video Produkte oder Dienstleistungen über das Internet präsentieren und so eine neue Werbeplattform schaffen. Auch das Internet-Learning wird in Zukunft an Bedeutung gewinnen - Videos sind eine sinnvolle Ergänzung zur konventionellen Wissensvermittlung. Aber nicht nur im Internet lassen sich solche Techniken anwenden.

Verteilermechanismen

Die Streaming-Technologie sieht prinzipiell mehrere Möglichkeiten vor, wie Daten zum Client übermittelt werden. Im Mittelpunkt stehen stets die zwei Verteilungsmechanismen Unicast und Multicast. Bei beiden ist der Client-PC passiver Zuschauer: Er empfängt den Datenstrom und stellt ihn dar, ähnlich der Radio- und Fernsehübertragung.

Unicast bedeutet in diesem Zusammenhang, dass die Daten vom Server zu einem Client übertragen werden. Einen Schritt weiter geht Multicast. Hier erfolgt der Datentransfer vom Server zu verschiedenen Systemen in einem Rechnerverbund. Voraussetzung ist dabei allerdings, dass die im Netzwerk betriebenen Router mit Multicast-Unterstützung ausgestattet sind.

Eine weitere Methode ist denkbar: On-demand (auf Abruf). Bei diesem einfachen Verfahren handelt es sich um eine aktive Verbindung zwischen Client und Server, wobei der User eine Verbindung zum Server initialisiert und den dort verfügbaren Content abruft.

Zukunft von Streaming-Videos

In Zukunft werden die wichtigsten Themen für die Weiterentwicklung von Streaming-Videos, besserer Bildqualität, Interaktionsmöglichkeiten und Verbindung von Text und Grafik mit Videos sein. Was heute schon möglich ist bzw. was der Ausblick auf die nächsten Monate und Jahre ist, ist nun in ein paar Punkten angeführt:

Fentergröße und Qaulität bei schnellen Internetverbindungen

Die aktuelle Standardgröße von 192 x 144 Pixel (4:3) stellt einen Kompromiss zwischen Bildqualität, Bildfluss, und der gebräuchlichsten Übertragungsgeschwindigkeit mit Modem und ISDN dar.

Schon mit gebündeltem 2-Kanal-ISDN oder LAN und z.B. 2Mbit-Verbindungen können größere Formate und besser Qualität übertragen werden. Der Media Player passt sich mit Hilfer der Multiple-Bandwith-Technologie, bei diesen Beispielen der Bandbreite zwischen 100k und 300k an: Video mit 240x180p und mit 320x240p

Dieses Video ist für nahezu alle Internet-Benutzer unabhängig von den jeweiligen Internetzugängen geeignet. Von Modem über ISDN bis Mbit-Verbindungen kann sich das Video auf die mögliche Bandbreite d.h. die Geschwindigkeit des Internetzugangs einrichten. Fenstergröße, Bildfluss, Ton- und Bildqualität passen sich automatisch der möglichen Datenübertragungsrate an.

Sie können natürlich auch selbst die Zugangs-Einstellungen vornehmen bzw. verändern und so die verschiedenen Qualitäten vergleichen.

Interaktivität in Verbindung mit Filmen

Während eines Filmes können synchron zu diesem zusätzliche Informationen interaktiv angeboten werden. Beispielsweise können so begleitende Bilder, Text Informationen, Animationen oder sogar Tickets bestellt werden.

Individuelle Player-Fenster

Ein weiteres Highlight des Windows Media Players stellt die individuelle Gestaltung des Video-Fensters dar. Videos werden nicht mehr im WMT Player-Fenster geöffnet, sondern in einem neuen Fenster. Auf diese Weise können nun Text, (Hintergrund-) Grafiken oder Links beliebig eingebaut werden. Dabei muss der Benutzer natürlich nicht auf die gewohnten oder auch nur speziell gewünschten Funktionen des Players verzichten.

Einbindung von Banner und Grafik

In das Fenster des Media Players können sowohl Banner mit Linkmöglichkeiten, als auch Grafiken eingebunden werden. So erscheint bei diesem Beispiel eine Grafik nach dem Abbruch des Videos mit der Stopp-Taste. In dem Informationsfeld erscheint ein kleines Icon (16x16 Pixel).

Verbindung von Videos und Text

Es gibt die Möglichkeit Texte oder Grafiken in Verbindung mit einem Video anzuzeigen. Dies ist sowohl auf Live-Übertragungen als auch Streaming Media Dateien anwendbar. Dabei werden synchron zum Video, Texte und Grafiken angezeigt.

Viele Informations-Veranstaltungen werden heute durch PowerPoint Präsentationen unterstützt. Diese können mit der Videoübertragung synchron via Internet übermittelt werden.

2. DVD-Ländercodes

2a. Grundlegendes:

Ländercodes sind immer wieder ein heiß umstrittenes Thema. Wozu dienen jetzt diese?

In erster Linie zu Copyright Zwecken. Der herkömmliche Weg eines Filmes ist, dass der Film zuerst in den USA in den Kinos läuft, nach Europa in die Videotheken kommt, dann ins Pay TV, als Kaufvideo angeboten wird und zum Schluss im Free TV ausgestrahlt wird. Nun ist es aber möglich mit DVD, einige dieser Schritte zu überspringen, wenn man sich in Amerika den Film kauft und bei uns ansieht bevor er vielleicht noch im Kino läuft. Das ist für die Filmindustrie der Hauptgrund, Ländercodes einzuführen.

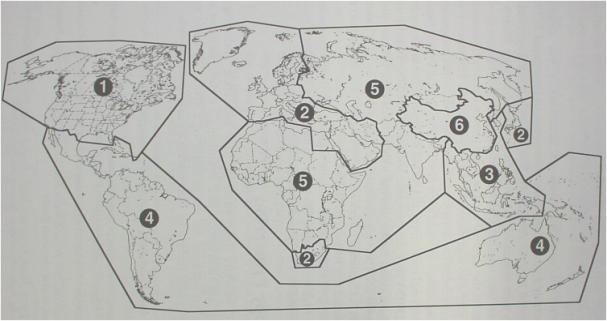

Ein weiterer Grund für die Einteilung in Regionen (siehe Grafik unten) ist, dass auf einer DVD ja viele Länderspezifische Daten gespeichert sind und man so für die Region 2 zum Beispiel die gleichen Untertitel verwenden kann.

Region 1: Kanada, USA,

Region 2: Europa, Japan, Südafrika, mittlerer Osten, Ägypten

Region 3: Südostasien, Ostasien,

Region 4: Australien, Neuseeland, Mittel- Südamerika, Karibik

Region 5: ehem. Udssr, Afrika, Nordkorea, Mongolei

Im Prinzip funktioniert der Ländercode über den DVD Player, das heißt ist der Player codefree kann ich damit DVDs mit einem anderen Code anschauen. Meistens bieten Hersteller codefree- Player um einen Aufpreis legal an, andere Player lassen sich durch Tastenkombinationen auf der Fernbedienung freischalten.

Dies ist aber auch nicht mehr aktuell, da neueste DVDs selbst einen Schutz besitzen. Sie fragen ab, ob der Player auf einen Ländercode eingestellt ist, ist dieser komplett codefrei spielt der Film nicht ab, selbst wenn der Player legal codefrei gekauft wurde

.

2.b Zukunft

Wie schaut nun die Zukunft des Ländercodes aus? Genau kann man das nicht sagen, aber bestimmte Tendenzen machen sich bemerkbar.

Zum einen versucht man bestehende Codes zu verbessern beziehungsweise zu erweitern. Ein Beispiel ist, dass jetzt DVDs ausgeliefert werden, die softwareseitig abfragen, auf welchen Ländercode der Player eingestellt ist. Ist dieser komplett codefrei, d.h. kann man keinen Code manuell einstellen, spielt der Film einfach nicht ab. Und das egal ob man jetzt legal einen codefreien Player teurer gekauft hat oder illegal seinen bestehenden freigeschalten hat.

Es laufen auch in Amerika Verfahren bezüglich des Codes, die im Moment eher die großen Filmfirmen für sich entscheiden können, doch eines ist tendenziell bemerkbar: Ländercodes in der Art und Weise wie wir sie jetzt haben werden in Zukunft- nach Meinung der Filmindustrie- sowieso hinfällig sein. Sie wollen, dass der Kunde nicht für den Film, sondern für die Nutzung zahlt. Das heißt ich zahle einen gewissen Betrag und darf mir dafür einen bestimmten Film zum Beispiel fünf mal anschauen. Danach ist er für mich wieder gesperrt und ich muss erneut zahlen. Das ist aber nicht nur die Vorstellung der Filmindustrie, sondern soll sich auch in Bereiche wie Musik und e- books ausdehnen.

Jetzt kann ich prinzipiell, so wie bei der jetzigen DVD auch, die digitalen Daten wohl kopieren (denn zum Beispiel der Copyright Standard bei der DVD, CSS, ist nicht etwa ein Kopierschutz, sondern ein „Betrachtungsschutz“), wenn mir die Industrie aber keine entsprechenden Geräte zur Verfügung stellt, die diese Codes verarbeiten können, kann ich diese Daten aber nicht abspielen. Wie sicher diese Codes sind ist eine andere Frage, zumindest wird es nicht legal sein!

Wird man also in Zukunft vielleicht gar kein Videoarchiv mehr besitzen können, das man nicht mehr für den Film, sondern für die Betrachtung zahlt und das Material vielleicht dann online zur Verfügung gestellt wird? Geht nach dem Sinn der Industrie- ja!

3. Digitale Fotografie

3a. Technik

Die digitale Fotografie ist immer mehr im kommen. Die Vorteile liegen auf der Hand. Man kann die Bilder über das Display direkt kontrollieren, diese löschen, man bekommt- je nach Auflösung- sehr viele Bilder auf eine Speicherkarte, man kann die Bilder direkt in den Computer spielen für Onlineaktionen oder zum Nachbearbeiten oder man schickt die Fotos die man haben will einfach zum Ausarbeiten.

Diverse Berufsgruppen arbeiten nur noch mit digitaler Fotografie wie zum Beispiel die Medien. Bei einem Sportereignis, dass in Amerika stattfindet, will man die Bilder am besten gleich in der Abendausgabe haben- kein Problem mit digitaler Fotografie, bei Versicherungen macht man zum Beispiel Bilder direkt am Unfallort und schickt diese sofort ins Büro- ebenfalls kein Problem.

Was unterscheidet jetzt aber Digitalkameras untereinander? Der Hauptunterschied ist natürlich die Auflösung. Aktuelle Modelle haben eine Auflösung von 3.3 Megapixel, was einer Bildschirmauflösung von 2048x1536 entspricht. Diese ist ausreichend um Bilder im A4 Format mit sehr guter Qualität auszudrucken.

Zum Faktor Qualität muss man natürlich sagen, dass die herkömmliche analoge Fotografie qualitativ noch besser ist (diese hat umgerechnet eine Auflösung von etwa 10 Megapixel). Rein theoretisch könnte man natürlich auch im digitalen Bereich die Chips hochauflösender machen, wie es auch im Laufe des Jahres passieren wird (bis 5 Megapixel), warum dies aber nicht im großen Ausmaß geschieht hat einen Grund- den Speicherplatz. Eine einfache Rechnung zeigt, wie viel Speicherplatz ein VGA Bild unkomprimiert benötigt:

640x480 = 307.200 Pixel

307.200 x 24 bit = 7.372.800 bits

7372800 / 8 = 921.600 bytes ~1 MB

Standardmäßig werden Speicherkarten mit acht Megabyte den Kameras beigefügt, die immerhin ausreichen um 120 Bilder in VGA Qualität komprimiert zu speichern. In der höchsten Auflösung passen allerdings auch nur etwa 10 Bilder auf ein acht Megabyte Speichermedium, also nicht gerade viel. Und größere Karten sind teuer. Das ein Hauptgrund, warum es also kein Chips im Bereich von über zehn Megapixel im Moment gibt.

3.b Zukunft

Die große Frage ist jetzt natürlich, wie schaut die Zukunft der digitalen Fotografie aus? In welche Richtung wird es Weiterentwicklungen geben?

Hier gibt es mehrere Ansätze:

Auflösung: Ganz klar ein Faktor, der von Modell zu Modell verbessert wird, ist die Auflösung. Selbst wenn es im Moment noch teilweise Probleme mit dem Speicher gibt wird die Anzahl der Megapixel steigen. Ein Chip der Firma Foveon schaffte es bereits ein Bild mit 4000 x 4000 Pixel aufzunehmen- sprich mit 16 Megapixel! Natürlich ist dieser noch nicht marktreif, aber man sieht, welche Möglichkeiten technisch ohne Probleme drinnen sind. Und wenn einmal Kameras mit einer so hohen Auflösung und mehr auf dem Markt sind, wird auch die digitale Fotografie in den Profibereich Einzug halten. Man kann dann nicht mehr vom Qualitätsunterschied Auflösung zwischen digitaler und analoger Fotografie sprechen (herkömmliche Fotografie hat eine Auflösung um die 10 Megapixel).

Speichermedien: Angefangen bei den Wechselspeichermedien hat es mit

herkömmlichen Disketten die nicht mehr als 1,44 MB speichern konnten. Diese

wurden aber schnell abgelöst durch alternative, wesentlich größere,

Speichermedien wie Speicherkarten und CDs. Bei den Speicherkarten beträgt das

aktuelle Fassungsvermögen 128 MB. Hier ist jedoch auch noch lange nicht das

Ende erreicht. In den Labors der Entwicklerfirmen liegen schon fix fertige

Gigabyte Medien, die in absehbarer Zeit im Handel für den Käufer erhältlich

sein werden. Spätestens dann werden auch hohe Auflösungen weiter

interessant.

Zusätzlich in eine etwas andere Richtung gehen einige Firmen mit beschreibbaren

Disks. Von Sony kamen heuer digitale Kameras mit wiederbeschreibbaren 8cm CDs

heraus, die ein Fassungsvermögen von 156 MB haben. Ebenso gibt es Prototypen,

die auf Mini Disc abspeichern. Was aber die Zukunft ist, nicht nur in der

Unterhaltungselektronik, ist die DVD. In Zukunft werden wiederbeschreibbare

DVDs in digitalen Fotoapparaten eingesetzt werden und dann befindet sich das

Fassungsvermögen eines solchen Speichers schon jenseits einer Gigabyte.

Eine Entwicklung, die in eine ganz andere Richtung zielt, ist die Konvergenz von Produkten. Diese wird sich wenn dann eher im Heimanwenderbereich wohl durchsetzen. Hier gibt es bestehende Modelle von diversen Firmen, die digitale Kameras mit integrierten MP3- Player auf den Markt bringen. Ob diese Art von Geräten sich in Zukunft durchsetzen wird bleibt abzuwarten. Wenn die Qualität der einzelnen Module in Ordnung ist warum nicht. Im Moment muss man bei solchen Konvergenzprodukten jedoch gerade in Punkto Qualität wesentliche Abstriche machen. Hier heißt es also wirklich abwarten, was die Zukunft bringt.

Weiterführende Informationen

Verweise auf Arbeiten anderer gruppen

>Entstehung | Ausbreitung | Verlierer | Sicherheit | Veränderung | Auswirkungen | Interaktiv | Zusammenfassung