|

Allgemeines

Es werden die Audioformate wav, midi, mod und- wie koennte es anders sein-

mp3 verglichen. Man kann diese vier Formate prinzipiell in 2 Gruppen

einteilen: wav und mp3 auf der einen und mod und midi auf der anderen Seite.

Bei wav werden die gesamten Audiodaten in einzelnen Samples gespeichert; mp3

komprimiert diese Audiodaten ohne spürbaren Qualitätsverlust, wobei man mit

einem Bruchteil des ursprünglichen Speicherbedarfs auskommt.

Mod-files verwenden ein ganz anderes Prinzip: Statt das Musikstück in

einzelne Samples zu zerlegen, werden hier die Samples der Instrumente

abgespeichert. MIDI funktioniert auf eine ähnliche Art und Weise.

WAV

technisch

WAV ist ein sogenanntes chunkformat: Es besteht aus einer Reihe sogenannter

chunks, welche die gesamte Information über das Audio-Stück beinhalten. Dabei

kann man zunächst zwischen notwendigen und optionalen chunks unterscheiden.

Es gibt 3 chunks, welche in jedem WAV-file enthalten sein müssen. Dies sind

der Form-, der FMT- und der Data- Chunk. Diese 3 Chunks bilden das

Grundgerüst des files. Alle weiteren Chunks, wie z.B. der Playlist-Chunk,

sind optional.

WAV-files sind im Allgemeinen unkomprimiert. Abhängig von der Abtastrate und

davon, ob das signal monoform oder stereoform vorliegt und ob 8 oder 16 bit

für jeden Abtastwert verwendet werden, kann eine Aufzeichnung von einer

Minute Dauer zwischen 644 KB und 10 MB Speicher benötigen.

Auf CDs werden Daten im sog. CD-DA Format gespeichert, welches dem Standard

WAV-Format sehr ähnlich ist.

historisch

Das WAV-Format ist ein Subset von Microsoft's RIFF-Spezifikation und kann

verschiedenste Arten von Daten enthalten. Ursprünglich war es für

Multimedia-Files vorgesehen, doch die Spezifikation ist relativ offen (also

nicht besonders strikt) und erlaubt es, praktisch alles in einem solchen file

zu plazieren; ungeeignete Daten würden von einem Programm, welches das Format

korrekt interpretiert, einfach ignoriert.

RIFF ist ein Format für Multimedia-Daten wie Audio und Video, es basiert auf

sog. Chunks und Sub-Chunks. Das gesamte RIFF-File ist wiederum ein Chunk, der

alle anderen Chunks enthält.

WAVE (WAV) ist ein Subtyp von RIFF und muss aus mindestens 3 Chunks bestehen,

alle weitere RIFF-Chunks sind außerdem zulässig. Da eine einfachere

(unvollständige) Version des WAVE-Formats vor der Win32 API veröffentlicht

wurde, haben ältere Programme unter Umständen Probleme, WAVEs zu

interpretieren, welche aus mehr als 3 Chunks bestehen.

Es ist eine relativ unbekannte Tatsache, dass WAVE-files Datenkompression

unterstützen. Tatsächlich sind komprimierte WAVE-files relativ unüblich. Die

Win32 API Dokumentation gibt Aufschluss darüber, welche Kompressionen möglich

sind und wie komprimiert / dekomprimiert wird.

Anwendung

Im Prinzip für alle Gelegenheiten geeignet, aber normalerweise

(unkomprimiert) erzeugt WAV (bei hoher bzw. CD-Qualität) sehr große Dateien.

Aufnahme und Wiedergabe sind problemlos. Verwendung bei:

- Qualitätsmässig

hochwertigen aber kleinen Tondateien

- Sprachaufnahmen in

mono

- Einfachen

Musikaufnahmen

- Eingeschränkten

Aufnahmemöglichkeiten.

Zusätzlich ist WAV meist das Zwischenformat

zwischen MP3 und CDDA: Wenn man ein mp3 von Songs auf einer CD erzeugen will,

erzeugt man erst die WAVs von den Tracks auf der CD und komprimiert diese

dann zu mp3s. Umgekehrt werden oft mp3s zu WAVs dekomprimiert und dann als

CDDA auf CD gebrannt. Die Konvertierung WAV -> CDDA übernimmt dabei die

CD-R-Software.

MP3

technisch

MP3 steht für MPEG Layer III. Vereinfacht kann man mp3's als komprimierte

wav-files betrachten. Generell kann man sagen, dass ein "typisches"

mp3 1/10 des Speicherplatzes des korrespondierenden unkomprimierten

audio-formats benötigt.

Unkomprimierte Audiodaten, wie z.B. auf einer Audio-CD, speichern mehr Daten

als das menschliche Ohr verarbeiten kann. Wenn zwei Noten sich sehr ähnlich

sind und sehr nahe beieinander liegen, wird das menschliche Ohr nur eine der

beiden Noten hören. Wenn zwei Sounds sehr unterschiedlich sind, jedoch einer

sehr viel lauter als der andere ist, hört das menschliche Ohr nur den

lauteren Sound. Außerdem ist das menschliche Ohr für gewisse Frequenzen

empfänglicher als für andere. Die Studie dieser Phänomene nennt man

Psychoakustik, und darüber ist sehr viel bekannt. Diese Phänomene sind

genauestens in Tabellen, Diagrammen und mathematischen Modellen des

menschlichen Hörprozesses zusammengefasst. Sehr vereinfacht gesagt liest ein

mp3 encoder also ein wav-file und lässt all jene Daten weg, die das

menschliche Ohr sowieso nicht hören würde.

Mp3 wird auch als "perceptual codec" bezeichnet. Ein

"Codec" ist ein Satz von Kompressions- und Dekompressionsalgorithmen.

Mit "perceptual" ist gemeint, dass es wenig Sinn hat, Information

zu speichern, welches Menschen sowieso nicht hören können. Wie einfach sich

dies auch anhören mag- man ist überrascht, erfährt man, dass gute Aufnahmen

eine Unmenge an Daten speichern, welche man nie hören wird, weil das

recording equipment (Mikrophone, Gitarren, etc.) für ein breiteres Spektrum

von Sounds und Audioauflösungen empfänglich ist.

Mp3 verwendet zwei Kompressionsverfahren, um diese Kompressionsraten über

unkomprimierte Audiodaten zu erzielen. Im ersten Schritt wird verworfen, was

wir nicht hören (bzw. akzeptable Kompromisse gemacht); im zweiten Schritt

werden Redundanzen mit herkömmlicheren Algorithmen weiter komprimiert. Der

erste Schritt ist bei weitem komplizierter und komplexer als der zweite.

- Signal wird in

Frames aufgespaltet (typische Länge: Bruchteil einer Sekunde).

- Signal analysieren:

Auf dem gesamten Spektrum der hörbaren Frequenzen, herausfinden, wie die

bits verteilt werden müssen, um die Audiodaten optimal zu komprimieren.

Da verschiedene Frequenzbereiche am besten mit ähnlichen Algorithmen

behandelt werden, wird das Signal hier in sub-banden eingeteilt, welche

parallel verarbeitet werden können.

- Aus der angegebenen

Bitrate wird berechnet, wieviele bits auf ein Frame fallen. Mit 128 kbps

gibt es z.B. eine Obergrenze, welche angibt, wie viele Daten in einem

Frame gespeichert werden können (außer, man arbeitet mit Variablen

Bitraten (VBR)). Dieser Schritt entscheidet, wieviel der vorhandenen

Audiodaten gespeichert werden und wieviel davon verworfen wird.

- Die Frequenzen,

welche jedes Frame belegen, werden mit mathematischen Modellen der

Psychoakustik verglichen, welche im Codec als Referenztabelle

gespeichert sind. Aus dem Modell kann abgeleitet werden, welche Frequenzen

genauestens erfasst werden müssen und welche weggelassen werden können

bzw. nur wenige bits in Anspruch nehmen dürfen, da der Mensch sie

sowieso nicht hören kann.

- Auf den erhaltene

Bitstream wird der Prozess des Huffman-Coding angewendet, welcher

redundante Information komprimiert. Huffman-Coding arbeitet nicht mit

psychoakustischen Modellen sondern mit traditonelleren Methoden. Man

kann also den gesamten mp3-encoding-Prozess als zwei-Schritt-System

sehen: Zuerst die psychoakustischen Modelle anwenden, wobei Daten

weggelassen werden, dann die restlichen Daten komprimieren, um

Redundanzen zu vermeiden. Der zweite Schritt lässt keine Daten weg- er

ist verlustfrei!

- Die Frames werden in

einen (seriellen) Bitstream umgewandelt, vor jedem Frame gibt es header-Informationen,

welche essentielle Daten über das Frame angeben.

Der de-facto-Standard vor

noch einem Jahr war es, mp3s mit einer Rate von 128 kbps zu komprimieren.

Dabei gibt es z.T. heftige Kontroversen über die Frage, ob man in einem

128kbps-mp3 (stereo, 44.1 KHz) den unterschied zu CD-Qualität hört oder

nicht, und weitere Kontroversen über die Frage, ob nicht etwas

grundsätzliches verlorengeht, obwohl man den Unterschied nicht hören kann

("es ist nicht dasselbe!").

Inzwischen ist man vielfach dazu übergegangen, mp3s mit 160kbps und 192kbps

zu komprimieren. Dies hat stark mit den beständig steigenden Kapazitäten von

Festplatten und gleichzeitig sinkenden Preisen zu tun, außerdem besitzen- im

Vergleich zu von vor 4 Jahren- sehr viele PC-Besitzer CD-Brenner und

verwenden diese auch für die Archivierung von mp3s.

Es ist beim mp3-format (im Gegensatz zu JPEG) nicht möglich, den

Verlustfaktor bei der Kompression direkt anzugeben. Stattdessen kann man die

Anzahl der bits pro Sekunde angeben, was ein ähnliches Endresultat hat. Bei

einer niedrigeren Bitrate wird das codec "strikter" angewendet bzw.

Irrelevanz- und Redundanzkriterien werden schärfer beurteilt. Das hat

natürlich zur Folge, dass mehr Daten verworfen werden, was eine geringere

Qualität zur Folge hat.

Bitrates geben die Gesamtrate für alle komprimierten Kanäle an. Das bedeutet,

dass 128kbps stereo gleichbedeutend ist (sowohl in Größe als auch in

Qualität) mit 2 * 64kbps mono.

Variable Bitrate mp3s (VBR) sind mp3s, bei denen sich die Bitrate von Frame

zu Frame ändern kann. Ursprünglich war die Bitrate durch alle Frames konstant

(CBR). Tatsache ist jedoch, dass Musik in keinster Weise konstant

strukturiert ist- Passagen mit vielen Instrumenten und Stimmen werden von

Passagen mit sehr wenigen abgelöst usw. Bei der Kompression mit VBR wird eine

Toleranzschwelle angegeben, welche- verwirrenderweise- bei verschiedenen

Encodern verschiede mögliche Werte annehmen können (zB 0-10 oder 0-100).

Die Kompression von mp3s erfordert sehr viel mehr Ressourcen als die

Dekompression (Wiedergabe). Wiedergabe in Stereo / 128 kbps / 44.1 KHz

erfordert typischerweise mindestens einen Pentium 100.

Anwendung

Mp3s sind sehr weit verbreitet- man spricht oft von einem "mp3

boom". Sie werden überwiegend für die Wiedergabe von Musik in

CD-Qualität über das Internet verwendet. Obwohl es inzwischen Formate gibt,

welche über leicht bessere Kompressionsalgorithmen verfügen (wma), haben sie

sich bis jetzt kaum durchgesetzt. Zu dieser Entwicklung gibt es zahllose

historische Parallelen.

MOD

technisch

Anstatt das gesamte Musikstück in Samples zu zerlegen, werden hier nur die

Samples der verwendeten Instrumente abgespeichert und die sog.

"Partitur" des Musikstücks. Man unterteilt das Musikstück hier also

nicht in Abschnitte, sondern gliedert es mehr inhaltlich.

In einem mod-file stehen mehrere kurze Samplings, welche jeweils ein

Musikinstrument darstellen. Zusätzlich wird die Partitur mit den Noten

abgespeichert.

Man kann damit vorhandene Musikstücke natürlich nicht einfach digitalisieren-

es bedeutet einen hohen Produktionsaufwand. Auf der anderen Seite verringert

sich hier die Datenmenge immens, da nur die Instrumente und nicht das ganze

Stück als Sample abgespeichert werden.

Bis zur Position 20 ist der Titelname untergebracht. Falls dieser kürzer als

20 Zeichen sein sollte, wird der Rest mit Nullen aufgefüllt. Danach werden

bis zu 30 Samples abgespeichert: Diese Samples sind die einzelnen

Instrumente. Das bedeutet, daß nicht mehr als 30 Instrumente bei einem

Musikstück im MOD-Format benutzt werden können. Die Tonhöhe der einzelnen

Instrumente ist in achtel-Halbtonschritten variierbar. Sämtliche

Informationen, wie welches Instrument einzusetzen ist, sind in der Partitur festgehalten.

Die ersten mod-files entstanden auf dem Amiga, zu einer Zeit, wo die

Sound-Hardware von PCs nicht mehr als einige Piepser von sich geben konnte.

So ist es nicht verwunderlich, dass das Format von MOD-files genau auf die

Fähigkeiten der Amiga-Hardware abgestimmt ist (d.h. 8 Bit Auflösung, linear,

max. 28KHz Abtastrate, max. 4 Stimmen). Das Mischen der Stimmen geschieht auf

dem Amiga in Hardware, die Sample-Daten werden per DMA übertragen, sodass

selbst für heutige Verhältnisse lahme Prozessoren nur zu einem geringen Teil

belastet wurden.

historisch

1987 veröffentlichte Karsten Obarski, der damals für EIDOS Interactive

arbeitete, ein Programm namens Soundtracker. Tatsächlich legte er mit diesem

Schritt den Grundstein für eine ganze Szene.

Verglichen mit heutiger Musiksoftware bot Obarskis Software eher bescheidene

Möglichkeiten. Es gab keine Unterstützung für externe Instrumente wie Sample

oder Synthesizer, und dank des Amiga-Soundchips konnten nur 4 Stimmen

gleichzeitig wiedergegeben werden, echte Stereoausgabe war ebenfalls

unbekannt.

Die so genannten Modules bestehen aus einzelnen Samples und den Anweisungen

darüber, wann und wie diese gespielt werden sollen. Die Daten werden von

einem MOD-Player interpretiert.

Die Technik beeinflusste die Szene der Amiga-Musiker ganz wesentlich. Die

Samples konnten exportiert werden, die Programmierung lag offen, jeder Track

war eine Anleitung zum Selbermachen, jeder Remix nur einen Mausclick

entfernt. Es gab keine Trennung zwischen Konsumenten und Produzenten.

Gerade aus diesen Gründen- weil jeder jedem in die Karten schauen darf- war

Originalität besonders gefragt. Außerdem hatte damals im Wesentlichen jeder

die gleichen technischen Voraussetzungen und konnte nicht aufgrund eines

besseren Equipments bessere Tracks produzieren.

Der Internetboom bedeutete so etwas wie einen Wendepunkt für die

Tracker-Szene: Mit der Zeit sahen die Musiker ihre Tracks nicht mehr nur als

Beiwerk zu Demos und emanzipierten sich von dieser Szene. Eigene Music-Groups

schlossen sich zusammen und bildeten im neuen Medium neue Vertriebsnetzwerke.

Einen kräftigen Schub bekam diese Entwicklung dann mit dem Aufkommen des WWW.

Die Gruppen designten sich eigene Websites und gaben sich damit ein eigenes

Gesicht; statt "music group" nannte man sich "net label".

Anstatt musik stilistisch wild durcheinander zu veröffentlichen, suchte man

sich seine Sparte. In den Jahren ´94 bis ´96 entstanden viele auch heute noch

engagierte Netzlabels.

Als der mp3-Boom ausbrach, hatten viele Tracker Angst, vom neuen Format

überrollt zu werden. Die öffentliche Diskussion spitzte sich auf mp3.com und

illegale mp3s zu, Trackerlabels waren den meisten Neulingen im Netz

unbekannt. Einige Sites sahen darin auch die Chance, mehr Aufmerksamkeit zu

bekommen: Seit einem Jahr bietet die Site ModPlug Central (www.modplug.com)

mp3s an, die gleichzeitig als mod veröffentlicht werden und so die

"Angst" vor dem unbekannten Format nehmen sollen. Modplug Central

möchte damit mod-files als unkommerzielle Alternative zu Plattenlabeln und

Raubkopien empfehlen.

In den letzten Jahren haben jedoch immer mehr Trackerlabels das mp3-format

für sich entdeckt, der open-source-Gedanke geht dabei zwangsläufig verloren.

Bandbreite spielt heute eine geringere Rolle bei der Distribution der Musik,

und auch der durchschnittliche PC ermöglicht, was früher nur Studios mit

professionellem Equipment vorbehalten war. Auch die Trackerentwicklung hat

eben vor dem technischen Fortschritt nicht haltgemacht.

Anwendung

Tatsächlich sind mod-files den vielen neuen Benutzern des Internet und

Personen, welche sich nicht seit Anfang der 90er Jahre mit Computern

befassen, weitgehend unbekannt. Tatsächlich gab es mod-files natürlich auch

auf dem PC, doch ihre Nutzung beschränkte sich auf wenige Interessierte und "Power

User" des PC. Der sog. "mp3 boom" beschränkt sich indessen

nicht nur auf erfahrene PC-Benutzer, sondern hat unabhängig von der Erfahrung

mit dem Umgang des Computers praktisch grosse Teile des Internets befallen.

Diese Entwicklung hat sicher auch mit der fortschreitenden Vereinfachung der

Bedienung eines Computers (Betriebssysteme mit grafischer Benutzeroberfläche

etc) im Vergleich zum Stand Anfang der 90er Jahre zu tun.

MIDI

technisch

Midi erzeugt keine eigentlichen Tondateien, sondern legt "nur" intern

eine Liste an, mit welchen Mitteln das vorhandene Hardware-Equipment

(Soundkarte mit MIDI-Interface) bestimmte Instrumente "nach"spielen

soll. "MIDI-Musikstücke" können auf jedem Rechner unterschiedlich

klingen.

Das MIDI-Format ist dem MOD-Format im Prinzip sehr ähnlich, nur fehlen hier

die Samples der einzelnen Instrumente. Statt der Informationen über die

einzelnen Instrumente sind bei diesem Format dort nur Nummern verzeichnet.

Die entsprechenden Instrumentinformationen zu den Nummern müssen dann in einer

speziellen Software oder auf der Hardware realisiert werden.

Die meisten Soundkarten besitzen eine MIDI-Schnittstelle. Weiters sind sie in

der Lage, selbst solche MIDI-Sequenzen zu verarbeiten und dazu die

entsprechenden Töne zu erzeugen. Die Töne sind in digitaler Form auf der

Karte abgelegt, im sog. Wavetable-ROM. Bessere Karten verfügen zusätzlich

über ein RAM, wo man selbst neue Sounds ablegen kann. Der MIDI-Teil einer

Soundkarte lässt sich jedoch auch in Software nachbilden.

Da keinerlei Samples untergebracht werden müssen, ist das Format natürlich

unheimlich "klein". Andererseits ist eine getreue Wiedergabe des

Musikstücks fast nicht möglich, da häufig die genauen

Instrumenteninformationen nicht vorhanden sind und jeder Hersteller solche

Instrumentensamples etwas anders gestaltet. Einigkeit besteht zumindest

darin, dass eine Gitarre wie eine Gitarre klingen soll und ein bestimmter

Grundvorrat an Instrumenten immer vorhanden ist.

Ein weiteres, grundsätzlicheres Problem bei MIDI ist- ebenso wie bei MOD-

dass kein Gesang abgespeichert werden kann, da sich die Stimme nicht wie ein

einfaches Instrument samplen lässt. Grade bei neueren Musikstilen wie Techno

können diese Formate eine echte Alternative sein.

historisch

Mitte der 80er Jahre tasteten sich die Musikstudios vorsichtig auf das neue

Feld der auf MIDI-Recording und Soundsampling basierenden Musikcomputer vor.

Die ersten Geräte befanden sich damals z.T. in Privatbesitz von Dozenten an

Universitäten. Anfang 1986 startete Wolfgang Martin Stroh eine Artikel-Serie

in der Zeitschrift "Populäre Musik im Unterricht" mit Tips und

Praxistests für den Commodore-Einsatz.

1987 begann der Einstieg in die Digitalära und das Midi-Recording. Bis heute

wird z.T. noch auf den robusten Atari ST gearbeitet.

Der Atari ST war der erste Rechner, welcher über eine MIDI-Schnittstelle

verfügte. Damit zog er in die Musikstudios ein.

Vergleiche

Eine Stunde aufgezeichneter Musik benötigt mit 16 bit, 44KHz Stereo (unter

der Voraussetzung, dass sie in CD-Qualität wiedergegeben werden soll) im

WAV-Format ca. 600 MB. Im MOD-Format erreicht man zwar keine CD-Qualität,

kommt aber schon mit 1/10 des Speicherplatzes aus. Bei MIDI ist man dann

schon bei nur 200 KB angekommen. Allerdings kann man hier auch beim besten

Willen nicht mehr von CD-Qualität sprechen.

Wenn man sich den Speicherverbrauch und die Qualität der Wiedergabe der

einzelnen Formate ansieht, versteht man, warum man so interessiert daran ist,

die Musik als ganzes zu samplen, danach aber so zu komprimieren, dass man ohne

spürbaren Qualitätsverlust mit einem Bruchteil des ursprünglichen

Speicherplatzes auskommt -> mp3!

Während mp3s und wavs sich weltweit eines großen Nutzerkreises erfreuen, sind

midi-files und wohl vor allem mod-files der "neuen Generation" der

(Internet-) Benutzer wohl weitgehend unbekannt.

|

|

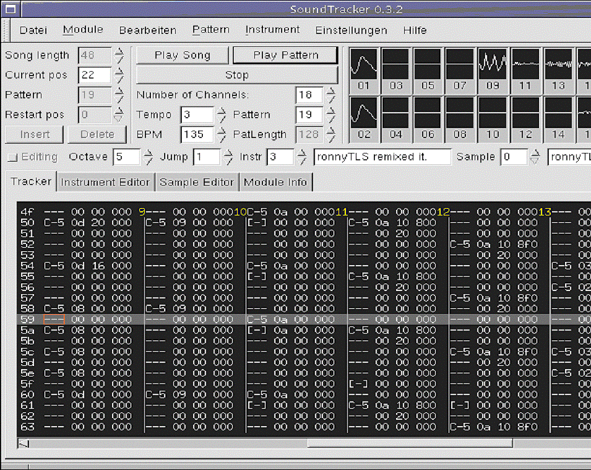

Was ist ein Soundtracker?

Im wesentlichen handelt es sich bei einem Soundtracker um ein Tool, mit dem

Samples in einer festgelegten zeitlichen Reihenfolge plaziert werden können.

Zusätzlich können auf diesen Samples noch einfache DSP-Aktionen ausgeführt

werden (Tonhöhe verändern, Echo, Portamento). In gewisser Weise ist also ein

Soundtracker mit einem Midi-Sequencer vergleichbar, der ebenfalls für die

Aufzeichnung der zeitlichen Aneinanderreihung von Events verantwortlich ist.

Der große Unterschied ist aber einerseits die Art, wie Klänge erzeugt werden,

und anderersseits das verwendetete Fileformat. Während im Midi-Format

Zeitpunkt (Note On, Note Off-Events), das verwendete Instrument (z.B. nach

dem GM-Standard), Höhe und einige andere Effektinformationen in einem

standardisierten Format abgespeichert werden (siehe http://www.midi.org/), sind im MOD-Format der

Soundtracker die verwendeten Samples bereits im File inkludiert (siehe http://www.wotsit.org/download.asp?f=modfil11).

Grundsätzlich ist ein Soundtracker-Modul (so werden die Songs genannt) aus

Patterns aufgebaut, die dann beliebig oft wiederholt und aneinandergereiht

werden können.

Die einzelnen Spuren ("Tracks") eines Moduls werden spaltenweise

angeordnet, wobei jede Zeile in einer Spalte einem Beat in einem festgelegten

Raster entspricht. So lässt sich beispielsweise eine Zeile mit einer

16tel-Note assozieren, 16 Zeilen entsprechen dann einem Takt. Für jede

gesetzte Note steht an erster Stelle der Ton, die Oktave und dahinter noch

zusätzliche Informationen (Portamento, Vibrato,...).

Die Eingabe findet bei Trackern grundsätzlich über die Tastatur statt, wobei

eine Klaviertastatur auf das Computerkeyboard gemappt wird.

Die Eingabe der Patterns kann einerseits "in Echtzeit" geschehen,

oder aber im Editiermodus, hier kann man dann auch Effektinformation genau

angeben und beispielsweise fließende Übergänge zwischen Noten realisieren

("Portamento").

historisches

Der erste Soundtracker wurde von Karsten Obarski im Jahr 1987 für die

Amiga-Plattform veröffentlicht. Der Amiga konnte bereits vier unabhängige

Spuren mit 8 Bit Auflösung wiedergeben, dadurch konnten bei effizienter

Ausnutzung der Ressourcen bereits relativ komplexe Musikstücke wiedergegeben

werden. Die meisten Soundtracks für Amiga-Spiele wurden damals auf

Soundtrackern komponiert.

Später gelang es, mit Hilfe von Tricks 8 Spuren auf einem Amiga wiederzugeben

(Oktalyzer). Mit der steigenden Verbreitung von IBM-PC's (und kompatiblen) im

Heimbereich und der Verfügbarkeit von technisch immer ausgereifteren

Soundkarten (allen voran der Soundblaster von Creative Labs) verbreiteten

sich auch in diesem Bereich die Soundtracker-Clones (Noisetracker).

Heute ist der Ur-Soundtracker nur für die Linux/XWindow-Plattform

erhältlich (siehe http://www.soundtracker.org), für MS Windows gibt es derzeit

keine funktionierende Portierung. Es existiert jedoch eine ganze Reihe von

(oft um viele Features erweiterten) Tracker-Derivaten für Windows (siehe http://www.soundtrackers.de).

Features / Weiterentwicklungen

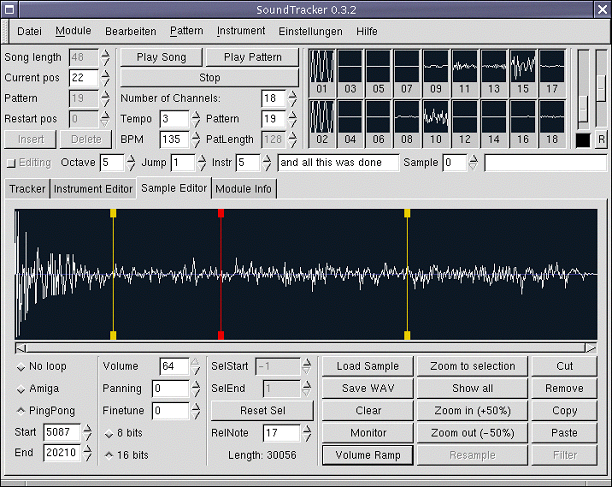

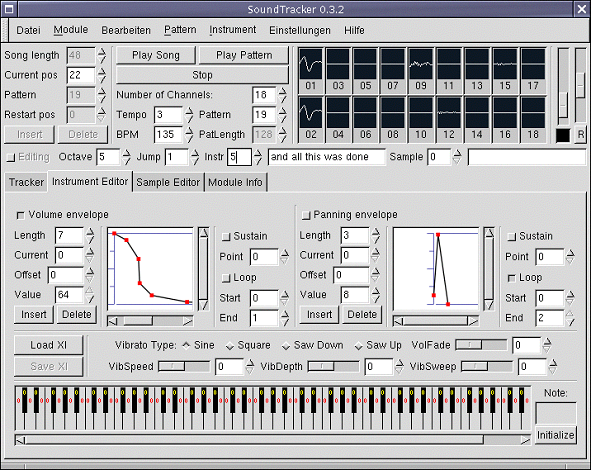

Abbildung 1: Main window eines typischen

Soundtracker

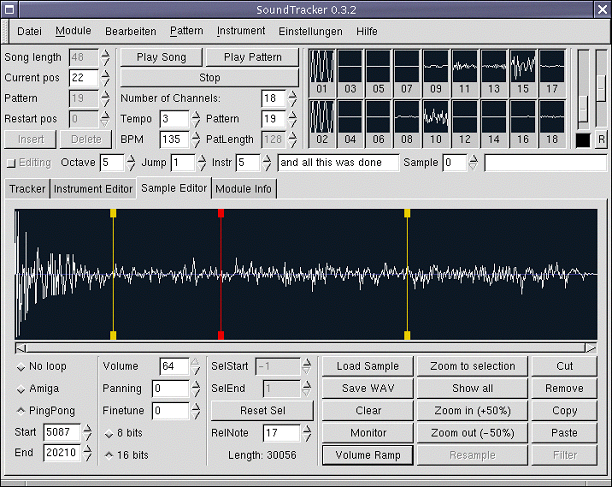

Im Laufe der Zeit wurden die Soundtracker um immer ausgefeiltere Features erweitert.

So wurden z.B. mehr oder weniger leistungsfähige Sample-Editoren integriert

(Abbildung 2).

Abbildung 2: Sample-Editor

Sample-Editoren gestatten es, Sound aufzunehmen und ihn mit Hilfe von Cut-,

Copy- und Paste-Operationen nachzubearbeiten. Ausserdem ist es möglich,

Sounds als "Loop" zu definieren, d.h. dass man beispielsweise einen

Drumbeat zyklisch wiederholen kann. Als besonders nützlich erweist sich auch

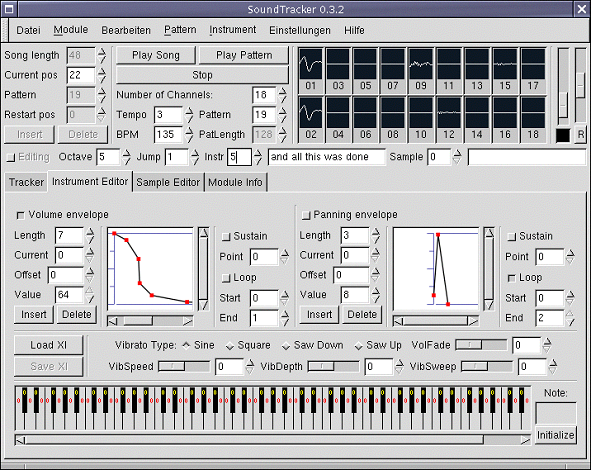

ein Instrument-Editor, mit dem es möglich ist, Parameter wie das Ausklingen

des Instruments oder Effekte festzulegen (Abbildung 3).

Abbildung 3: Instrument-Editor

Was ist Reason?

Ohne Übertreibung kann man Reason aus der schwedischen Musiksoftwareschmiede

Propellerhead ( http://www.propellerhead.se/)

als revolutionäre Software bezeichnen. Grundsätzlich besticht es durch

folgende Features:

- Intuitives UI, die

Bedienung ähnelt in verblüffender Weise ähnlich funktionierender

Hardware.

- Qualität der

erzeugten Sounds, bei verhältnismäßig niedrigen Anforderungen an den

Rechner.

- Außer einer 16

Bit-Soundkarte und einer hinreichend schnellen CPU (läuft problemlos auf

einem PII 350) gibt es keine zusätzlichen Anforderungen an die Hardware.

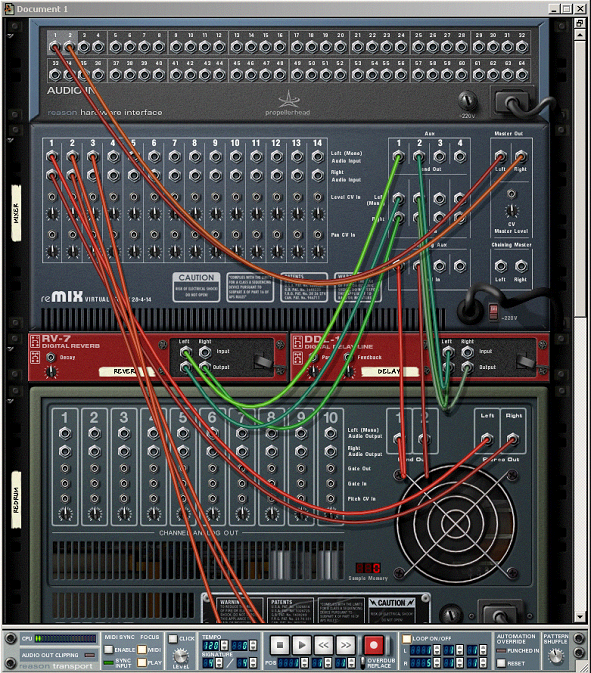

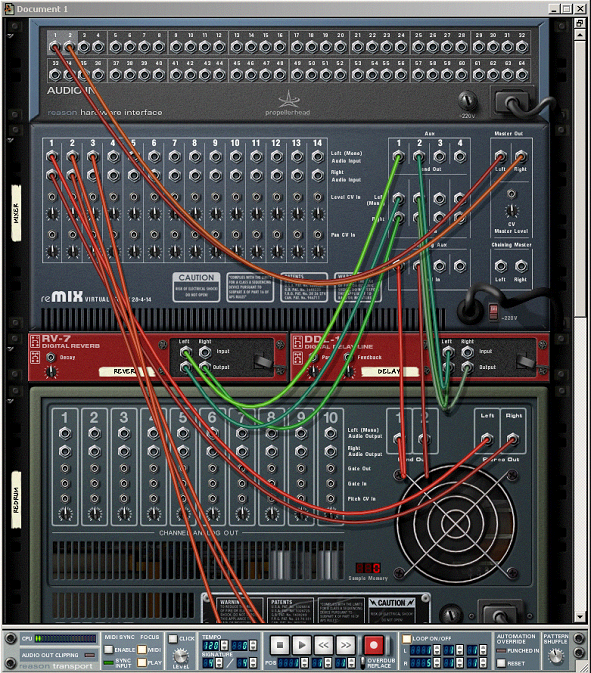

Dem User präsentiert sich

Reason als virtuelles Studio-Rack, in das verschiedene Klangerzeuger,

Sequencer, Effektgeräte und Mischer eingesetzt werden können. Dabei geschieht

die Zusammenstellung und Verkabelung der Geräte vollkommen grafisch und per

Drag&Drop (siehe Abbildungen 4 und 5).

Welche Komponenten beinhaltet Reason?

Neben Geräten wie Sequencern, Analog-(Software)Synths, Mixern, Drumcomputern

und Effektgeräten gibt es auch Sampler, Loop-Player und Midi-Input-Devices.

Außerdem gibt es die Möglichkeit, den Audio-Output über das ReWire-Protokoll

an Software wie Steinberg Cubase VST oder Logic Audio umzuleiten und dort zu

mischen bzw. mit Effekten nachzubearbeiten.

Indem man [TAB] drückt, kann man das gesamte Rack von hinten betrachten (Abb.

5) und mit Hilfe der Maus die einzelnen Geräte miteinander verbinden. Dabei

verfügt jedes klangerzeugende Gerät über einen CV (Control Voltage) und einen

Gate-Eingang, das mit einem entsprechenden Ausgang eines steuernden Gerätes

verbunden werden kann. Effektgeräte können - so wie bei einem echten

Studiomischpult - in den Effektweg des Reason-Mischpultes eingeschleift

werden.

MIDI-Integration

Alle Geräte in Reason können über Midi kontrolliert werden. Dabei kann Midi

sowohl bei der Komposition (beispielsweise können Synthesizer-Spuren mit

einem Keyboard eingespielt werden) als auch im Production Level eingesetzt

werden. So kann Reason komplett über einen anderen Sequencer kontrolliert

werden, und auf diese Weise kann es auch in komplexen Studio-Environments

eingesetzt werden.

Mittels des ReWire2-Protokolls ist es möglich, Reason von Cubase aus zu

verwenden. Cubase fungiert dann als Sequencer und Reason übernimmt nur mehr

die Klangerzeugung.

Vergleich

Grundsätzlich muss gesagt werden, dass sich die Ansprüche, die an

Musiksoftware gestellt werden, im Laufe der Zeit stark verändert haben. So

ist es vor 10 Jahren noch undenkbar gewesen, mit Hilfe eines

Software-Synthesizers hochqualitative Sounds zu erzeugen, sie durch ein

Mischpult zu routen und gleichzeitig mit Effekten zu versehen und dann

digital auf einer Harddisk zu speichern.

Es hätte also wenig Sinn, die technischen Daten der Programme direkt

gegenüberzustellen. Ich werde jedoch versuchen, einige Anwendungsszenarios

und (Un)Möglichkeiten für den Einsatz der Programme zu zeigen.

Während es sich bei einem Soundtracker - wie schon weiter oben erwähnt - um

eine Software handelt, die im wesentlichen nichts anderes tut, als Samples in

einer zeitlich festgelegten Abfolge und in unterschiedlicher Geschwindigkeit

abzuspielen, bietet Reason viele Möglichkeiten, die in einem modernen Studio

vorzufinden sind. Daraus folgt, dass sämtliche Sounds, die ein Tracker

wiedergeben kann, in Form eines Samples vorliegen müssen, während Reason die

Möglichkeiten der künstlichen Klangerzeugung mit Software-Synthesizern

bietet. Reason kann jedoch auch die von einem Tracker gebotenen Möglichkeiten

mit Hilfe des integrierten Pattern-Sequencers und des Digitalsamplers

abdecken. Hier zeigt sich ein kleiner "Vorteil" der Soundtracker

gegenüber dem modular aufgebauten Reason, da in die meisten Tracker bereits

ein kleiner Sample-Editor mit Aufnahmemöglichkeit eingebaut ist. Dieser

Vorteil wird jedoch durch die Verfügbarkeit leistungsfähiger Editoren (e.g.

Cool Edit, Propellerhead ReCycle, Steinberg WaveLab) mehr als kompensiert.

Genau hier schließt auch der nächste große Vorteil von Systemen wie Reason

an: Durch die Midi-Fähigkeit und das ReWire-Protokoll von Propellerhead wird

die Integration sowohl mit Midi-Hardware als auch mit anderer Software

(Steinberg Cubase, Logic Audio) zum Kinderspiel. So kann man beispielsweise

ein Laptop mit Reason und Cubase VST nahtlos in ein bestehendes Midi-Setup

integrieren. Ein PC/Laptop wird somit zum (portablen) Synthesizer, Sampler,

Sequencer und Effektgerät und das alles bei professioneller Soundqualität.

Somit sind eigentlich auch die Zielgruppen definiert: Während die

Soundtracker eindeutig für den Homecomputer- und später Home-PC-Anwender und

für Spieleprogrammierer entwickelt wurde, zielt Reason eindeutig auch auf den

professionellen Bereich ab. Allerdings ist es aufgrund seines relativ

niedrigen Preises auch für Homerecording-Anwendungen und Hobbymusiker

erschwinglich.

Der Preis ist aber gleichzeitig der größte Vorteil der Soundtracker, da

mittlerweile alle Tracker als freie Software bzw. Shareware existieren.

Allerdings glaube ich, dass der hohe Entwicklungsaufwand den Preis von Reason

mehr als rechtfertigt, und wenn man sich mal die Preise für entsprechende

Hardware ansieht, ist das Preis/Leistungsverhältnis unschlagbar.

Fazit

Zweifelsohne waren die ersten Soundtracker mit den damals überragenden

Soundfähigkeiten des Commodore Amiga beeindruckend. Allerdings sind die

Schwächen der Tracker offensichtlich. Die nicht vorhandene Midi-Integration

und die Beschränkung auf gesampelte Sounds schränken das Anwendungsfeld sehr

ein, da es mittlerweile andere Sampler-Software gibt, die außerdem über Midi

angesteuert werden kann, sind Tracker heute eine Spielerei für Freaks und

nicht mehr.

Mit der Veröffentlichung des Realtime-Softwaresynthesizers mit integriertem

Sequencer, Rebirth, sorgte Propellerhead bereits für Gesprächsstoff in der

Szene. Mit dem neuen Tool Reason wurden jedoch sowohl in puncto Soundqualität

und als auch Usability neue Maßstäbe gesetzt. Bereits nach kurzer

Einarbeitungszeit kann man - einige Erfahrung mit Sound-Hardware

vorausgesetzt - erste Ergebnisse erzielen, für den Profi bietet es alle nur

erdenklichen Features, vor allem auch in der Integration mit anderer

Software.

Natürlich muss gesagt werden, dass Reason/Rebirth bei weitem nicht die

einzigen Softwaresynthesizer-Systeme sind. Für eine umfangreiche Liste siehe http://www.synthzone.com/softsyn.htm.

Es gibt andere System, z.B. csound (http://www.csound.org),

die über eine eigene Programmiersprache gesteuert werden können, und die noch

viel weitreichendere Möglichkeiten, u.a. aber auch die

Realtime-Softwaresynthese, bieten. Allerdings liegt der Schwerpunkt beim

System Reason eben auch im User Interface, und dieses User Interface ist

bisher wirklich einzigartig.

Der Trend hin zu den Softwaresynthesizern wird sicher Auswirkungen auf die

Art, wie Musik komponiert und produziert wird, aber auch - zusammen mit

Entwicklungen wie mp3 oder anderen "netztauglichen" Audioformaten -

auf die gesamte Musikbranche, und das sowohl in qualitativer Hinsicht, als

auch auf die Beziehung zwischen Komponisten/Künstlern, Produzenten und

Plattenfirmen/Verlegern haben. Hier sehe ich aber auch Chancen für Musiker,

da mit der Verfügbarkeit professioneller Software im Consumer-Bereich dem

Trend hin zum völlig gesichtslosen Musiker, dessen Image nur noch von einer

Marketingabteilung festgelegt wird und der aufgrund der Notwendigkeit

professioneller Produktionstechnik und eines funktionierenden Vertriebs

Produzenten und Plattenfirmen vollkommen ausgeliefert ist, entgegengewirkt

werden könnte. Das trifft zwar nur auf den Bereich der elektronischen Musik

zu ("richtige" Bands werden nach wie vor kaum um einen Vertrag herumkommen

- man sehe sich einmal die Kosten für eine professionelle CD-Produktion im

Detail an), gerade in diesem Bereich wird aber von den großen Konzernen am

meisten Geld umgesetzt und gerade hier sinkt das Niveau immer tiefer. Das

Argument, es könnte mit Hilfe solcher Tool "ein jeder so einen Mist

produzieren", kann ich nicht gelten lassen, da gerade ein freier

Wettbewerb, in dem nicht von Plattenfirmen diktiert wird was gut und was

schlecht sei, für eine andere Bewertung der diversen "DJ Ötzis" und

Konsorten sorgen könnte.

Abbildung 4: Frontansicht des Reason-Racks

Abbildung 5: Rückansicht des Reason-Racks

|

|

Langspielplatten

Die älteste Form Musik auf Scheiben zu verfrachten ist die Long Play Platte. Die

Musikqualität ist in den von mir vorgestellten Trägern sicherlich die

schlechteste, allerdings findet sie nichtsdestotrotz auch heute noch

Anwendung. Im Gegensatz zu den Kontrahenten wird die Musik auf Schallplatten

(LP's) in analoger Form gespeichert, was zwar eine genaue Aufzeichnung der

Musik bedeutet, die Abtastung ist jedoch derart fehleranfällig und ungenau

dass sie nicht mehr genau so widergegeben werden kann wie sie aufgenommen

wurde.

Kurioses nebenbei: Schallplatten lassen sich inzwischen mittels eines

3D-Scanners so genau abtasten dass sich die dadurch gewonnenen Rillen und

somit der gespeicherten Musikinformation auf der Plattenoberfläche mittels

Berechnungen in Hochqualitative digitale Musik im MP3 Format umwandeln

lassen.

Somit ist eine Schallplatte nicht mehr nutzlos, sondern eigentlich einer CD

fast gleichwertig. Das Abtasten mittels 3D-Scanner ist jedoch mit hohen

Kosten unterbunden, als noch nicht Marktreif und sicherlich nur für besondere

Platten einsetzbar, da es sich sonst einfach nicht lohnt.

Der Schall wird bei Schallplatten so aufgezeichnet wie er in der Natur auch

vorkommt, nämlich als sich fortbewegende Wellenform.

Die Aufzeichnung erfolgt mittels einer Nadel welche durch eine Membran,

welche den Ton aus der Umgebung abnimmt in Schwingung gesetzt wird. Auf der

Platte wird somit ein vertieftes Abbild dieser Schallschwingungen erstellt.

Das Abspielen der Schallplatte erfolgt auf die selbe Weise. Eine in der

fortlaufenden Rille auf der Schallplatte angesetzte Nadel welche durch das

abtasten in di selbe Schwingung versetzt wird wie auf der Platte eingeritzt,

leitet die Schwingungen an eine Membran weiter, welche sie als Ton an die

Umgebung abgeben kann.

Anfangs war die Schallplatte eine zylindrische mit einer Metallfolie

beschichtete Walze. Da diese aber ziemlich schlecht in der Massenproduktion

hergestellt werden konnte kam man zur heutigen Form, nämlich der Scheibe.

Die durchlaufende Rille beginnt dabei am äußersten Rand und folgt der Platte

spiralenförmig bis kurz vor dem Mittelpunkt der Platte.

Im Jahre 1887 erfand der in Deutschland geborene Amerikaner Emil Berliner

eben diese Form der Schallplatte, der heutigen Vinyl-platte. Anfangs benutzte

man dafür ein Gemisch aus Schellack, Schiefer, Asbest, Ruß und Schwerspat.

Diese Vinylplatten lassen sich schnell durch eine einfaches Pressverfahren

beliebig oft vervielfältigen, was sehr positiv für die Massenproduktion ist.

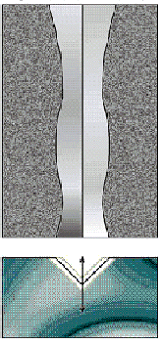

Der Schall kann auf zwei verschiedene Arten auf die Platte aufgetragen

werden. Es gibt dabei die Tiefenschrift, die sogenannte Edisonschrift und die

Seitenschrift, die sogenannte Berlinerschrift. Die Tiefenschrift ist der

historische Vorgänger der leichter maschinell zu erzeugenden Seitenschrift

und wurde natürlich durch die Seitenschrift abgelöst welche auch heute noch

gängig ist. Bei der Tiefenschrift wird die Schallwelle in Form von tieferen

bzw weniger Tiefen Rillen auf die Platte aufgetragen. Hingegen wird bei der

Seitenschrift, wie sicherlich bereits vermutet, die Welle durch Links -und

Rechtsschwenkungen gespeichert.

Im Laufe der Zeit wurden die Platten ständig verbessert, es gab verschiedene

Größen und verschiedene Abspielgeschwindigkeiten um mehr und mehr Ton auf

eine Scheibe verfrachten zu können. Die Seitenschrift wurde aber stets

beibehalten. Mit dem Einführen von elektronischen Geräten wurde es ermöglicht

die Rillen durch einen Abtaster (meistens aus Diamant) in elektronische

Impulse umzuwandeln welche beliebig verstärkt werden konnten. Während es bei

alten Platten nur Monoaufnahmen gab wurden nun Stereo-Platten vonnöten.

Aus diesem Grund, nämlich um zwei Kanäle auf der Platte zugleich speichern

zukönnen musste man eine Kombination aus Seiten- und Tiefenschrift einführen.

Die Nadel muss somit nicht nur Nach links und rechts sondern auch nach oben

und unten Ausschlagen. Aus diesem Grund konnte trotz der großen

Platzersparnis und somit steigerund der Kapazität, welche die Tiefenschrift

gebracht hätte nicht mehr auf sie zurückgegriffen werden.

Einige Daten

Die Standard LangspielPlatte (LP) hat einen Durchmesser von 12 Zoll und wird

mit 33 r.p.m abgespielt.

Weiters gibt es Single-Platten mit zwei bis vier Titel pro Platte. Sie haben

unterschiedliche Durchmesser werden jedoch mit 45 r.p.m abgespielt. Durch die

beiden verschiedenen Abspielgeschwindigkeiten wurde ein Krieg der beiden

Standards entfacht, denn man konnte lange Zeit am Plattenspieler die

Abspielgeschwindigkeiten nicht auswählen.

Heutzutage ist dies natürlich möglich, allerdings kaum mehr notwendig, denn

die Platte wurde um 1993 schnell durch die CD abgelöst.

Ein verzweifelter Versuch eines Comebacks der Schallplatten durch Einführung

eines neuen Standards, dem Direct Metal Mastering (DMM) bei welchem die Platte

durch einen Laser abgetastet wird, schlug kläglich fehl, da das Gerät im

Gegensatz zum CD-Player einfach zu teuer war.

Heutzutage findet die Schallplatte nur mehr unter Nostalgikern und als

Instrument der DJ's und "Scratcher" im Vergleich zu der CD minimalen

Einzug.

Compact Disc (CD)

Die CD ist der Datenträger der sich in der letzen Zeit am schnellsten

durchsetzen konnte. Sie löst die LP mit einer besseren Musikqualität und dazu

noch einem kleineren und handlicherem Format ab.

Die CD hat im Normalfall eine Kapazität von 74 Minuten und 33 Sekunden, eine

Umdrehungsgeschwindigkeit von 1,2-1,4 m/s das wären 200-500 U/sec. Der

Durchmesser der CD ist 120 mm und damit eindeutig kleiner als die LP'S. Die

Scheibe ist 1,2 mm dick und besteht aus einem transparenten Material mit

einem Brechungsindex von 1.55 (z.B Polycarbonat).

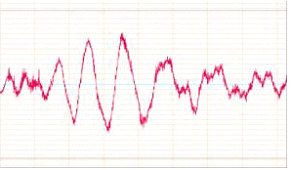

Die Daten werden auf der CD in digitaler Form gespeichert. Das bedeutet dass

der in der natur Vorkommende analoge Schall erst in digitale Werte

umgewandelt werden muss. Dies erledigt ein Analog - Digital Wandler

(A/D-Wandler). Diesem A/D Wandler muss durch eine Abtastfrequenz angegeben

werden wie oft pro Zeiteinheit ein Wert von der Originalschwingung, also der

Wert der Amplitude gelesen werden soll. Diese Abtastfrequenz ist normalerweise

44.100Hz. Eine höhere Abtastfrequenz wird eine genauere bzw. bessere

Annäherung an die Originalschwingung liefern, jedoch geht dies auf Kosten des

Speicherplatzes auf dem Medium.

Die Abtastfrequenz ist deshalb so gewählt, da das menschliche Gehöhr keine Signale

oberhalb von 20kHz wahrnehmen kann. Das Nyquist Theorem besagt dass die

Abtastfrequenz mindestens doppelt so groß sein soll wie die größtmögliche

vorkommende Signalfrequenz. Werte welche über die 20KHz hinausgehen werden

vom Aufnahmegerät durch einen Tiefpass abgeschnitten. Da es jedoch keinen so

perfekten Tiefpass mit einer so steilen Flanke gibt können Werte bis zu 22kHz

vorkommen. So erhält man den Wert von 44.1kHz.

Die so erhaltenen Werte werden nun quantisiert, d.H sie werden in Intervalle

eingepasst. Im Normalfall wird der Wert mit 16 Bits codiert. Auch hier gilt,

je größer das Intervall desto besser die Qualität desto größer die

Anfallenden Datenmengen.

Die erhaltenen Werte sind nun Bitfolgen und können auf beliebige Medien

abgespeichert werden. Die CD hat sich als solches Medium durchgesetzt, da sie

ähnliche Qualitäten wie die Schallplatte aufwies und dabei qualitativ viel

besser abschnitt.

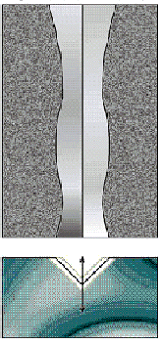

Wie wird die Information nun genau abgespeichert?

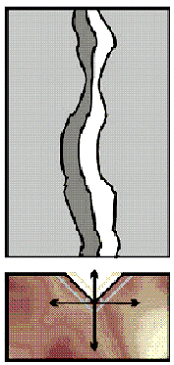

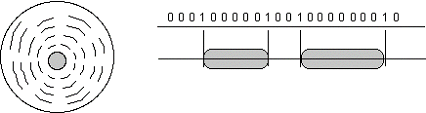

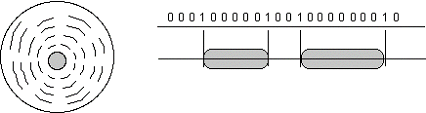

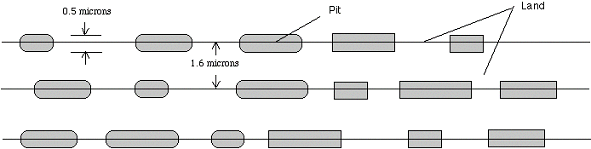

Die erhaltenen Audiodaten bestehend aus einem binären Code der aus 0 und 1

besteht werden in Form von "Pits" und "Lands" auf der Cd

gespeichert. Pits sind Vertiefungen und Lands sind nicht vertiefte Stellen.

Ein Laserstrahl tastet beim abspielen dabei die sich drehende Scheibe von

innen nach außen ab. Das kohärente Licht des Strahls wird von den Pits und

Lands unterschiedlich zurückgestrahlt. Nach der Ablenkung durch ein Prisma

wird der zurückgeworfene Laserstrahl von einem Photosensor aufgenommen und in

elektrische Impulse umgewandelt.

Damit die Pits und Lands auch überhaupt Licht zurückwerfen wird die Cd mit

einer sehr dünnen (50-100nm) Metallschicht (Aluminium, Silber, Gold) bedeckt.

Zum Schutz dieser Schicht wird darauf noch eine dünne Kunststoffschicht

(10-30µm) angebracht auf welcher das Label der Cd aufgedruckt ist. Der

Laserstrahl durchwandert somit die transparente Schicht und landet auf den

mit metallisierten Böden versehenen Pits und Lands. Bei Lands wird das

Laserlicht als ganzes reflektiert und bei Pits wird der Strahl gestreut.

Fehlerkorrektur

Während sich bei der LP Fehler wie Kratzer oder Verunreinigungen durch

Rauschen bemerkbar machten ist dies bei der CD nicht so stark der Fall und

zwar aus einem einfachen Grund. Dadurch dass die Lands und Pits so

mikroskopisch klein sind, gibt es bereits ab dem Werk Fehler innerhalb

geregelter Toleranzen. Bei Gebrauch lassen sich Kratzer aber nicht vermeiden,

deshalb muss die CD über eine Fehlerkorrektur verfügen. Die unvermeidbaren

Fehler werden somit durch die Fehlerkorrektur ausgemerzt. Wenn eine CD sehr

stark beschädigt ist kann natürlich die beste Fehlerkorrektur nicht mehr

helfen.

Standards

Schon bald wurde die CD Standardisiert um jeglichem Benutzer

unterschiedlicher CD-Player die selben Möglichkeiten zu bieten. Die Standards

wurden in den sogenannten Books festgehalten.

Die meisten weiterentwickelten Books sind für Audio nicht interessant sondern

beschreiben lediglich Videoformate Fotocds oder ähnliches.

Red Book (CD-DA)

Dieses Book erlaubt bis zu 74 Minuten digitale Musik.

- Die Samplerate

(Abtastfrequenz) ist auf 44,1kHz festgelegt, was 44100 Samples in der

Sekunde entspricht.

- Die Transferrate

welche der Player schafft ist auf 150 kbytes in der Sekunde festgelegt.

Dies ist auch als Singlespeed (1X) bekannt

- Die CD kann bis zu

99 Tracks beinhalten

Das Redbook ist auch unter

dem Namen CD-DA (Compact Disk Digital Audio) bekannt. Die beiden Firmen Sony

und Philips schufen diesen Standard im Jahre 1980 als einen Standard der

einfach eine universelle Methode digitalisierte Musik zu vertreiben

darstellte.

Dieser Standard wurde jedoch bald dazu benutzt um andere Daten abspeichern zu

können.

Eine Red Book Cd ist in drei Teile eingeteilt: Das Lead-In, die Daten und das

Lead Out. Jeder Track auf der CD ist im TOC (Table of Contents) festgehalten,

welches im Lead In einer jeden CD gespeichert ist.

Dieser Standard ist der Vorreiter aller darauffolgender Books.

Minidisc

Die MiniDisc sollte die CD ablösen konnte sich jedoch wegen des florierens

des MP3 Formates durch das Internet nicht so richtig durchsetzen.

Der Unterschied zur CD besteht vor allem darin dass die MiniDisk um einiges

kleiner und handlicher ist, dadurch werden die Player natürlich ebenfalls

viel kleiner und handlicher, was der eigentliche Wunsch gewesen ist. Nebenbei

kann man die MiniDisc auch beschreiben und wiederbeschreiben. Für die

Musikindustrie ist dies nicht mehr so positiv, jedoch kann sie mit MiniDiscs

und einer eingeschränkten Möglichkeit der Anfertigung von Kopien der

Musikpiraterie entgegenwirken, da die illegale Anfertigung von CD Kopien

inzwischen einem jeden offen steht. Die Idee wäre eigentlich gut gewesen,

wenn nicht das MP3 Format das kopieren von Musik noch wesentlich vereinfacht

hätte.

Die MiniDisc hat so viel Speicher auf so engem Raum vor allem deswegen Platz,

weil Frequenzbereiche, welche das menschliche Gehöhr nicht wahrnehmen und

Töne welche durch andere Töne so überlagert werden dass sie ebenfalls nicht

hörbar sind, rausgeschnitten werden und somit eine stattliche Menge unnützer

Daten entfernt wird.

|

|

Geschichtliches

Die Minidisc ist ein System zur Speicherung von Audiodaten. Es wurde im Jahre

1992 von Sony entwickelt und besteht aus einer 2,5“ großen Catridge die einem

somit geschützten magnetooptischen Datenträger enthält. Man kann sie wie eine

Kassette beschreiben, löschen und wieder beschreiben. Und das bis zu eine

Million Mal.

Im gewissen Sinne ähnelt die Minidisc der CD, da sie mittels eines Lasers

gelesen wird und die Speicherung der Daten digital erfolgt. MD’s, so die

Kurzbezeichnung der Minidiscs, verwenden das im Computerbereich eingesetzte

magneto-optische Verfahren.

MD’s sind in zwei Ausführungen erhätlich: 60 und 74 Minuten. Somit können die

MD’s gleich viel Daten aufnehmen wie eine herkömmliche CD mit 650 MB. Die MD

verfügt nur über ein Platzangebot von 140 MB. Sony erreichte durch das

sogennannte ATRAC – Verfahren eine Kompressiondichte von 5:1. Die ATRAC

Kompression verwendet dazu ein psychoakustisches Verfahren und der

Unterschied ist für den Menschen nicht wahrnehmbar.

Die MD wurde anfangs nur in den USA verkauft und eingesetzt. Erst in den

letzten Jahren interessierten sich immer mehr Hersteller wie SHARP, KENWOOD,

JVC usw. für die MD und brachten ihre eigenen Geräte auf den Markt. Dies

führte wiederum zu einer eindeutigen Verbilligung der Minidisc.

ATRAC Kompression

ATRAC steht für Adaptive Transform Acoustic Coding

Bei ATRAC handelt es sich

um eine intelligente Komrpimierungsmethode, die nicht einfach nur blind aus

einem Musikstück ausliest, sondern versucht, dem menschlichen Gehör

vorzutäuschen, dass es sich hier um das Originalstück handelt, ohne

Qualitätsverlust. Das Endresultat: Musik die kling wie die Originalvorlage,

aber eben 1/5 der Größe des Ursprungsstückes. Da sich das Wahrnehmungsmodell

ständig  ändert wird auch der ATRAC Algorithmus

ständig verbessert, um so eine noch bessere Qualität zu gewährleisten.

Deshalb wird der Minidisc nachgesagt, dass sie von besserer Qualität ist als

MP3. Wie bereits erwähnt gibt es mehrere Versionen von ATRAC. Am Anfang hieß

das Verfahren noch ADC und DAC. Da das Verfahren damals noch nicht ausgereift

war und die Geräte noch extrem teuer waren, wurde die MD bald totgesagt. Erst

die Verfahren ATRAC 2 und ATRAC 3 konnten überzeugen. Mit ATRAC 4 wurde sogar

eine wesentlich bessere Qualität als die der CDs erreicht. ändert wird auch der ATRAC Algorithmus

ständig verbessert, um so eine noch bessere Qualität zu gewährleisten.

Deshalb wird der Minidisc nachgesagt, dass sie von besserer Qualität ist als

MP3. Wie bereits erwähnt gibt es mehrere Versionen von ATRAC. Am Anfang hieß

das Verfahren noch ADC und DAC. Da das Verfahren damals noch nicht ausgereift

war und die Geräte noch extrem teuer waren, wurde die MD bald totgesagt. Erst

die Verfahren ATRAC 2 und ATRAC 3 konnten überzeugen. Mit ATRAC 4 wurde sogar

eine wesentlich bessere Qualität als die der CDs erreicht.

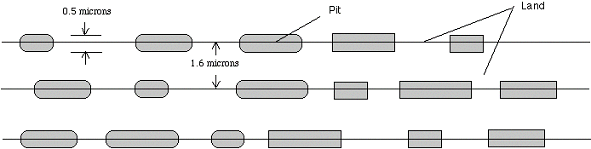

Aufbau

der MD

Der prinzipielle

Aufbau einer MO-Disc, ist hier schematisch dargestellt.

Ein aus Polycarbonat gesprizter

Grundkörper trägt eine bereits vordefinierte Rillenstruktur, der für die

exakte Führung der Optik sorgt. Darauf werden bei der Fertigung mittels

Dünnfilmtechnologie verschiedene Schichten aufgetragen, welche dem Träger

seine magneto-optischen Funktion verleihen.

Die magnetisch wirksame Schicht besteht aus Seltenerdmetallen (Godolinium, Terbium, Dysprosium) bzw. deren Legierungen (z.B.

Terbium-Ferrite-Cobalt bei der MD) und befindet sich zwischen einer

reflektierenden und zwei dielektrischen Schichten. Die magnetische Schicht,

welche ein Wiederbeschreiben überhaupt zulässt, besitzt bei Raumtemperatur

eine extrem hohe Koerzitivfeldstärke, wodurch die Disc selbst gegen starke

Magnetfelder unempfindlich wird.

Die Oberfläche wird zudem mit einem Schutzlack überdeckt und die fertige Disc

als zusätzlichen mechanischen Schutz in ein Kunststoffgehäuse gepackt. Da für

ein Schreiben auf die Disc ein Zugang von beiden Seiten her erforderlich ist,

sind diese Gehäuse mit einem doppelseitigen Schieber ausgerüstet der sich

aufgrund des relativ grossen Schreibkopfes meist über den ganzen Radius

erstreckt.

Dieser Aufbau bewährt sich seit

einigen Jahren bei MO-Speichern und erlaubt laut Hersteller das Beschreiben

von über einer Million Zyklen ohne Qulitätsminderung.

Die Zukunft der Minidisc

Lange Zeit hatte das Minidisc-System grosse Schwierigkeiten, sich auf dem Markt

durchzusetzen. Die früheren Versionen von ATRAC (Datenkompression) erreichten

nicht CD-Qualität und viele Experten gaben der MD keine Chance.

Die heutige Version 6 von ATRAC ist punkto Audioqualität mit dem CD-Standard

vergleichbar. Nach der Aufnahme eines CD-Tracks auf eine recordable MD sind

keine hörbaren Unterschiede mehr feststellbar. Das System hat sich auf dem

Markt etabliert und der Name Minidisc ist wohl jedem Musikkonsument ein

Begriff. Besonders die Möglichkeit der digitalen Aufnahme liess die Minidisc

(MD) zu den vorher bekannten Systemen wie Musikkassette (MC), Compact-Disc

(CD) und Digital Audio Tape (DAT) aufsteigen.

Vergleich

MC, CD, MD, DAT

Musikkasette, MC

Als Motivation zur Entwicklung des MD-Systems diente das Verlangen der Konsumenten

für einen Ersatz der Compact-Kassette. Das neue Konzept sollte die Vorteile

der Kassette (Robustheit, Erschütterungsfestigkeit, Mobilität) und die der CD

(bessere Musikqualität, digitale Aufzeichnung) verschmelzen. Diese Ziele

wurden vollständig erfüllt.

Sicherlich wird das MD-System die alte Compact-Kassette in den meisten

Bereichen ablösen, aber wie sieht es mit den digitalen Medien aus?

Compact Disc, CD

Die MD wurde entwickelt um Musikdaten in digitaler Form aufzeichnen zu

können, doch auch die wiederbeschreibbare CD-ROM hat sich in letzter Zeit auf

dem Markt durchgesetzt. Jedoch ist die recordable MD kompatibel zu sämtlichen

MD-Systemen, während die re-writable CD von vielen CD-Playern noch immer

nicht gelesen werden kann.

Die technischen Daten der Minidisc sind deren der CD sehr ähnlich. Der

grösste Unterschied ist die Speicherkapazität der CD mit 650 MB im Vergleich

zur MD mit nur 140 MB. Beide Systeme weisen eine maximale Spieldauer von 74

Minuten auf. Trotz einigen Stimmen, welche behaupten, die Minidisc sei als

CD-Ersatz eingeführt worden, wird sie aufgrund der enormen Verbreitung der CD

diese nicht vom Markt verdrängen können. Vielmehr ist die MD als Ergänzung

zur CD gedacht.

Digital Audio Tape, DAT

Es ist eher unwahrscheinlich, dass sich die MD im professionellen Bereich

etablieren wird. Das Problem ist, dass die Musikqualität noch nicht den hohen

Standard von DAT- und ADAT-Systemen erreicht hat.

Zukunftsaussichten

Der Produktionspreis einer pre-mastered Minidisc beträgt immer noch

mindestens gleich viel wie der einer CD. Die Beliebtheit der bespielbaren

Minidisc ist jedoch sehr gross und steigt weiter an.

Die Minidisc-Technologie breitet sich auch auf anderen Systeme wie Computer

und digitale Kameras aus. Mit einer Kapazität von 100 Floppydiscs ist die MD

gut als portables Speichermedium oder als Backupspeicher im Computerbereich

geeignet. Die Firmen Syquest und Iomega sind dabei die führenden Anbieter in

diesem Bereich.

Sharp entwickelte eine digitale Kamera, die fähig ist, 2000 Bilder mit einer

Auflösung von 640 x 480 Pixel auf eine einzige MD zu speichern. Die Audio-

und Videosysteme sind sowieso nicht von der 140 MB Standard-MD abhängig, denn

die führenden Entwickler wie Sony, Sharp, Philips und Fujitsu arbeiten

gemeinsam an einer hochkomplizierten Minidisc, die fähig sein wird, 8 GB an

digitalen Videodaten zu speichern. Die Einführung eines solchen System würde

dem heutigen digitalen Videodisc- (DVD) und LaserDisc-Markt echte Konkurrenz

bieten.

Alle portablen Geräte wie Laptops, Palmtop-Organizer und Videospiele könnten

von der Minidisc-Technologie profitieren, da die Systeme immer kleiner und

leichter werden. Auch Hybrid Minidiscs (ein Teil Schreib- und Lesbar, ein

Teil nur Lesbar) könnten in Videospiel-Konsolen Platz finden; Die Software

wird im festen Teil und Spielstände und Einstellungen im beschreibbaren Teil

gespeichert.

Diese Beispiele zeigen, dass die Anwendungsbereiche der Minidisc-Technologie

sehr vielfältig sind. In naher Zukunft wird die Minidisc in erster Linie

versuchen, unsere Wünsche nach leichteren, kleineren, genaueren und

rentableren Systemen zu erfüllen.

|