|

fit 2001 >

Gruppenthema > Entstehung |

Version 8.6. |

| Überblick | |

| Allgemein | |

|

| |

| Entstehung der Technologie | |

|

Wie jedem digitalen System unserer Zeit, ebnete auch dem digitalen Audio das analoge Audio den Weg: | |

| Die Griechen | |

|

Es waren wieder einmal die Griechen, die schon 1500 v. Chr. einen Weg gefunden hatten immer die selben Klänge aus einer Harfensaite zu zaubern. Das hatte natürlich rein spirituellen Zweck und wurde deshalb in eine Statue des Memnon in Theben eingebaut. | |

| Mechanische Klänge | |

|

Im Mittelalter erzeugte man Klänge die man beliebig oft wiederholen kann, und nichts anderes sind unsere modernen Aufnahmen, mit Hilfe von Zylindern, die mit kleinen Stiften bestückt waren, die wiederum die Melodie erzeugten indem sie Glöckchen oder Metallstreifen zum läuten bzw. schwingen brachten. Tongeräte dieser Art sind aus dem Jahre 1502 erhalten. Das Europa der Renaissance war fasziniert von den sogenannten Automaten, welches für die Zeit stilgerecht schön geschmückte und verziertet Möbelstücke waren, die nicht anders als ihre Vorgänger aus dem Mittelalter mechanisch funktionierten. Dabei war das System natürlich ausgereifter und verfeinert worden. Es wurden durch eine Uhrwerk nicht nur eine Melodie erzeugt, sondern auch Figuren zur selbigen im Rhythmus bewegt. Nun war es Zeit etwas leicht auswechselbares zu erfinden, so das ein und der selbe Automaten auch verschiedenen Melodien spielen konnte. Plastik so wie wir es heute fast überall verwenden gab es noch nicht und so musste Holz für die ersten „Lochkarten“ herhalten, die übrigens vom französischen Seide Hersteller Joseph Marie Jacquard erfunden wurde, der mit Musik nichts am Hut hatte. Er schuf sich mit seiner Erfindung nur Probleme, weil er eigentlich einen automatisierten Webstuhl erfunden hatte, was den Angestellten weniger gefiel. Seine Erfindung wurde verbrannt, aber Napoleon erkannte später die Wichtigkeit der Erfindung und rettet sie. Der Einfluss dieser „Lochkarten“ ist nicht zu übersehen. Sie halfen nicht nur der Entwicklung von selbst musizierenden Instrumenten wie Orgeln oder Pianos aus dem 19 Jh., sondern waren am Ende auch maßgeblich an der Entwicklung unserer heutigen Computer beteiligt (Lochkarten – Speicher). | |

| Der PC | |

|

· Erste Klänge des PC kamen aus dem (vielgehaßten) sogenannten PC-Piepser ·

älteste und einfachste Art der Klangausgabe ·

nur Tonhöhe und -länge veränderbar ·

Die Tonausgabe wurde ab 1981 bei den IBM PCs durch

einen kleinen, fest in das Computergehäuse eingebauten Lautsprecher

realisiert, der Töne in einem sehr begrenzten Frequenzbereich

wiedergeben konnte. Diesen Lautsprecher findet man auch heute noch in

den meisten PCs. Die Audiofähigkeiten der ersten IBM-PCs waren zudem

auf die Ausgabe beschränkt, es war keine Möglichkeit vorhanden,

analoge Klänge zu digitalisieren und weiterzuverarbeiten. Die Computer

der Firma Apple (Apple II) hatten ähnliche Eigenschaften, mit dem

Unterschied, daß es für den Apple II sehr früh (1978) eine

Zusatzkarte gab, die Töne produzieren und über ein Mikrophon

aufnehmen konnte, was allerdings nur in Verbindung mit dem Modem möglich

war und somit nicht unmittelbar als digitales Audio bezeichnet werden

kann. ·

Zu Beginn der Achzigerjahre erschienen Konsolen, die

an Fernsehgeräte angeschlossen werden konnten und die eine eingebaute

Tastatur hatten. An Software waren Spiele erhältlich, die in einem

festen Speicher auf einer Platine gespeichert waren. Hersteller waren

etwa Philips oder Sega, Nintendo sowie Atari. Letzere hatten sich

allerdings primär auf die Herstellung von Automaten in Spielhallen

spezialisiert. Die Audioeigenschaften dieser Geräte waren bereits um

einiges ausgereifter als bei den PCs, hier übernahmen spezielle ICs

die Tonausgabe, wodurch auch eine mehrstimmige Wiedergabe von Signalen

möglich war. So hatte zum Beispiel das Sega Master System 3 Soundgeneratoren ·

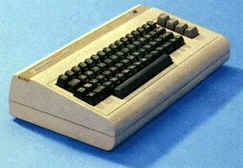

1982 wurde von Commodore ein Computer präsentiert,

der zur damaligen Zeit in puncto Musiksynthese neue Maßstäbe setzte.

Dieses Gerät war der C64, mit dem 6581 Sound Interface Device (SID). Nach

einigen Neuauflagen des 64ers, die im Wesentlichen auf leichten

Modifizierungen der Hardware beruhten, jedoch keine Erweiterungen der

Funktionalität mit sich brachten, kam im Jahr 1986 ein weiterer

Homecomputer der Firma Commodore auf den Markt, der die Bezeichnung

Amiga 500 trug und die Fortsetzung des Erfolges des C64 sein sollte.

Dessen Soundchip hatte vier separate Kanäle, die auf zwei Stereokanäle

zusammengemischt wurden. Es war das erste Gerät in dieser Preisklasse,

das Stereoton produzieren und digitalisierte Töne verarbeiten konnte.

Zwar waren auch hier standardmäßig keine Audioeingänge am Gerät

vorgesehen, jedoch konnten für einen geringen Kaufpreis Zusatzkarten,

sogenannte Digitizer, erworben werden, die die Möglichkeit boten,

analoge Signale in digitale umzuwandeln und mit Hilfe des

Soundprozessors im Amiga weiterzuverarbeiten. Die Qualität war mit der

Auflösung von 8Bit für damalige Verhältnisse zwar nicht schlecht,

konnte aber nicht mit den von der CD gewohnten 16 Bit mithalten.

Weiters war die Samplerate von 30kHz ebenfalls unter der der CD mit

44.1kHz. Dies tat der Beliebtheit dieses Computers vor allem bei

Hobbymusikern jedoch keinen Abbruch, im Gegenteil, nun war es das erste

mal möglich, mit einem relativ preiswerten Computer, der nebenbei auch

noch für andere Aufgaben wie zum Beispiel Videobearbeitung benutzt

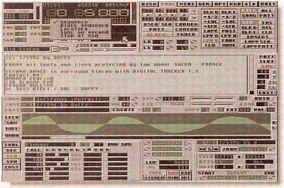

werden konnte, qualitativ hochwertige Musik zu machen. Mit dem MOD Format (Music On Disk) und spezielle

Programme zu deren Erstellung, sogenannte Tracker, war es auf einfache

Art und Weise möglich Musik zu komponieren und auszutauschen. Im

Prinzip besteht eine MOD Datei aus einer Ansammlung an digitaliserten

Klängen. Diese Klänge werden samples genannt und der Vorgang des

Konvertierens eines Tones von der analogen Form in das digitale Format

wird folglich sampeln genannt. Die einzelnen samples werden aufgrund

eines vom Komponisten angegeben Musters in einer bestimmten Reihenfolge

in einer festgelegten Tonhöhe und Geschwindigkeit hintereinander

abgespielt. In der Praxis sieht das so aus, daß man sich zuerst die

gewüschten Instrumente „einsampelt“ und dann im Tracker die Tonhöhen

und Reihenfolge angibt in der die Samples abgespielt werden sollen. Bei

vielen Programmen ist es auch möglich, auf die Samples zusätzliche

Effekte wie zum Beispiel Hall anzuwenden. Vorteil des MOD Formates ist

eine große Flexibilität bei der zur Verfügung stehenden Klänge. Man

kann sich jedes beliebige Instrument samplen oder aber eingene

Softwaresynthesizer verwenden, die komplett synthetische Töne

erzeugen. Weiters ist eine Datei in diesem Format besonders kompakt, da

die eingentlichen Noten und Steuerbefehle im Vergleich zu den Samples

relativ wenig Platz beanspruchen. Auf eine damals im Amiga 500

verwendete 720kB Diskette ließen sich durchaus an die zehn ca. 3

Minuen lange Musikstücke abspeichern. Wie gesagt kann diese Zahl sehr

start variieren, kommt es doch vor allem auf die Anzahl und Qualität

der Samples in dem Modfile an. Ungefähr zeitgleich mit dem Amiga 500 kam der Atari 1040ST auf den Markt, der als Konkurrenzprodukt positioniert war. Seine Grafikeigenschaften waren denen des Amiga unterlegen, was ihn jedoch für unsere Betrachtung interessant macht, sind seien Audioeigenschaften, die jene seines unmittelbaren Konkurrenten nochmals übertrafen. Im Atari, der damals um 999 Dollar erhältlich war, steckte ein Soundprozessor, der ebenfalls drei voneinander unabhängige Tonkanäle besaß, der AY-3-8910. Dieser konnte ebenfalls Töne im ADSR Verfahren erzeugen und hatte 16 Lautstärkestufen, die für jeden Kanal getrennte eingestellt werden konnten. Allerdings waren als Wellenformen ausschließlich Rechtecksignale möglich, was die Fähigkeiten als Synthesizer etwas einschränkte. Der Frequenzbereich umfasste 9 Oktaven, es konnten Töne in einem Frequenzbereich von 30Hz bis 16kHz produziert und wiedergegeben werden. Wie beim Amiga betrug die Auflösung nur 8 bit, was den 1040ST aber wirklich vom Amiga unterschied, war das bereits serienmäßig integrierte MIDI Interface (Musical Instruments Digital Interface). Damit war es möglich, andere Musikinstrumente zu steuern beziehungsweise von Instrumenten, die ebenfalls mit dieser Schnittstelle ausgerüstet waren, den Computer anzusprechen. Vor allem in der Studiotechnik sind auch heute noch die Geräte von Atari anzutreffen, da die meisten professionellen Geräte ein MIDI Interface besitzen.Der Nachfolger des 1040ST, der Atari Falcon erschien 1992 und sah seinem Vorgänger zwar optisch sehr ähnlich, die Audioeigenschaften wurden jedoch sehr verbessert. So betrug die Auflösung nun 16 Bit, die Abtastfrequenz bis zu 50kHz, und erstmals war es möglich, mit einem Homecomputer Harddisk-recording zu machen.

| |

| MIDI | |

|

· 1982 MIDI Standard (Musical Instrument Digital Interface) begründet von führenden Herstellern elektronischer Musikinstrumente und Software Entwicklern (Anfangs keine Kommunikation mit dem Computer, sondern Kommunikation zwischen Synthesizern) · gespeichert sind nicht Amplituden (samples) in gewissen Zeitabständen, sondern Art des Instruments, Tonhöhe, Tonlautstärke, Position von Tonanfang und Tonende) ·

nicht zur Übertragung von Audiosignalen, sondern

zur Steuerung von elektronischen Tonerzeugern ·

Wesentlich geringerer Speicherbedarf etwa

20 Kbytes pro Minute ·

Derzeit keine direkte Umwandlung von Audio-CD

oder Waveformat in MIDI möglich · ermöglicht Kommunikation von elektronischen Musikinstrumenten und Computern ·

seit Version 3.1 in Microsoft Windows enthalten ·

Im MIDI-Datenformat gibt es 128 Tonhöhen in 10

Oktaven, Jeweils eins von 128 Instrumenten oder Geräuschen wird einem

der maximal 16 Kanäle zugeteilt. ·

Der Datenaustausch erfolgt über sogenannte MIDI

Messages. Diese berstehen aus dem Status-Byte und den Data-Bytes. Das

Status-Byte beschreibt um was für eine Message es sich handelt. Man

unterscheidet zwischen folgenden Message Typen:

·

Zeitliche Synchronisation

·

Zwei Arten von Musikausgabe:

·

Midi-Sample-Dump (1985): Die einheitliche Übertragung

von Sampledaten über MIDI wird ermöglicht. ·

Midi-File-Format (1988): Daten (insbesondere

MIDI-Songs6.3)

lassen sich zwischen verschiedenen Sequenzern austauschen. ·

General MIDI (GM)

·

GS

·

Anwendungen ·

Sequenzer o

Aufnahme von Musik über angeschlossene

MIDI-Instrumente

·

Editoren o

Verwaltung von Klangfarben in der Regel umständlich

·

Notationsprogramme

·

Kompositionsprogramme o

Komponieren nach Zufallsmustern oder nach

Vorgaben des Benutzers. Ersteres Prinzip erzeugt aber bis heute keine

wirklich zufriedenstellenden Ergebnisse. ·

Lernprogramme o

Hilfe zum Erlernen musikalischer

Grundfertigkeiten (Schulung des Gehörs, Grundregeln der

Kompositionslehre, Einüben von Tonleitern auf bestimmten

Musikinstrumenten, Zurodnung von Akkorden zu einem bestimmten Musikstück)

·

Begleitautomaten o

Elektronische Band als Hilfe für Komponisten o

Begleitung von Bands oder Orchestern o

Sogar Improvisation mit dem Computer im Duo möglich ·

Digitalisierung als Klangwelle (Waveform) ·

variable Klangqualität und damit variabler

Speicherbedarf | |

| Soundkarten | |

|

· 1982 MIDI Standard (Musical Instrument Digital Interface) begründet von führenden Herstellern elektronischer Musikinstrumente und Software Entwicklern (Anfangs keine Kommunikation mit dem Computer, sondern Kommunikation zwischen Synthesizern) ·

Aufbau:

·

Geschichte: o

Die erste brauchbare Soundkarte war die ADLIB

Karte, die auch schnell zum ersten Standard wurde (gute Musikausgabe, mäßig

gute Audioausgabe) o

Nächster Standard war der Sound Blaster von

Creative Labs; seine Nachfolger, wie Sound Blaster 2.0, Sound Blaster

16 etc.) sind heute gültige Standards o

Parallel zum Sound Blaster wurden Soundmodule zur

MIDI-Ausgabe entwickelt; bemerkenswert ist der Roland MT 32 von der

Firma Roland (Erste Soundkarte mit Multi Mode, gleichzeitiges Abspielen

mehrerer Kanäle), der so erfolgreich war, daß er zu einem noch heute

verwendeten Standard wurde. Er ist der Vorläufer des General MIDI. | |

| Komprimierung und Medien | |

|

Getragen wurde die

Entwicklung des CD-Systems hauptsächlich vom niederländischen

Elektronikkonzern Philips Gloeilampen N.V. Die 1972 in kleinem Maßstab

begonnenen Forschungs- und Entwicklungsarbeiten am CD-Vorläufer

"ALP" (Audio Long Play) wurden bis 1978 in den Status der

offiziellen Produktentwicklung überführt. Aus strategischen Gründen

wurde ab 1979 der japanische Unterhaltungselektronikkonzern Sony an der

Endphase der Entwicklung und der Ausarbeitung der Systemspezifikationen

des Compact-Disc-Systems beteiligt. Prägenden Einfluß auf die gesamte

Entwicklung der CD hatte die intensive Zusammenarbeit von

Wissenschaftlern und Ingenieuren. Insbesondere durch die Rückgriffsmöglichkeit

auf naturwissenschaftliche Kompetenz, die im Eindhovener Natuurkundig

Laboratorium (Nat.Lab.) des Philips-Konzerns zur Verfügung stand,

konnte mit der Compact Disc ein technisches System unternehmensintern

zur Marktreife entwickelt werden, das den Stand der Technik verkörperte. Einen normierenden Einfluß

übte die CD-Entwicklung auf die sich gleichzeitig im Audiobereich

etablierende digitale Signalverarbeitungstechnik aus. Bemühungen, auf

internationaler Ebene insbesondere den wichtigen digitalen Parameter

der Samplingfrequenz unter Berücksichtigung vielschichtiger Interessen

zu standardisieren, wurden durch die interne Festlegung der von Sony

aus praktischen Gründen bevorzugten Frequenz 44,1 kHz als

Samplingfrequenz für das Compact-Disc-System untergraben. Ebenso wie

sich im Zuge der Durchsetzung des CD-Systems diese Samplingfrequenz in

der gesamten digitalen Audiotechnik etablierte, strahlte die aufgrund

großer produzierter Stückzahlen preiswert verfügbare Technologie der

Compact Disc auch auf andere Bereiche der Technik aus (z.B.

Datenspeicherung auf CD-ROM). Die von der Compact Disc ausgehenden

technischen und auch gesellschaftlichen Einflüsse können zu den

wichtigsten technologischen Impulsen des 20. Jahrhunderts gezählt

werden. |

|

| Die DVD | |

|

Die Entwicklung der DVD begann 1993 als man es an der Zeit fand  die

Speicherkapazität der CD zu erhöhen um möglicherweise auch von den

Videokassetten wegzukommen. Verschiedenste Firmen wie Toshiba/Warner

oder Sony/Philips kamen mit teilweise recht unterschiedlichen Ideen und

Formaten auf. Im September 1995 wurde schließlich ein Konsens gefunden

und der DVD Standart wurde als ein Standard festgelegt der mehrere

Spezifikationen akzeptierte. Die

DVD-Qualität ist 96000 Hz und 24-bit die

Speicherkapazität der CD zu erhöhen um möglicherweise auch von den

Videokassetten wegzukommen. Verschiedenste Firmen wie Toshiba/Warner

oder Sony/Philips kamen mit teilweise recht unterschiedlichen Ideen und

Formaten auf. Im September 1995 wurde schließlich ein Konsens gefunden

und der DVD Standart wurde als ein Standard festgelegt der mehrere

Spezifikationen akzeptierte. Die

DVD-Qualität ist 96000 Hz und 24-bitVerbreitung der DVD |

|

|

Weiterführende Informationen | |

|

| |

|

Verweise auf Arbeiten anderer Gruppen | |

|

| |

die Töne in einem Frequenzbereich über vier Oktaven

wiedergeben konnten. Man wollte eine besonders realistische Wiedergabe

von Tönen in den Spielen erreichen, was für die angepeilte Zielgruppe

ein wesentliches Kaufkriterium war. Aufgrund der beschränkten

Speicherkapazität der Cartridges auf denen die Spiele erhältlich

waren, war es allerdings nicht möglich, natürliche Töne in

digitaliserter Form zu speichern. Stattdessen wurde die Tonerzeugung über

die eingebauten Synthesizer realisiert. Diese setzten die auszugebenden

Töne aus Rechteck- und Sägezahnwellen zusammen wodurch sich auch der

als „krächzend“ beschreibbare Klang der ersten Spielkonsolen erklären

lässt.

die Töne in einem Frequenzbereich über vier Oktaven

wiedergeben konnten. Man wollte eine besonders realistische Wiedergabe

von Tönen in den Spielen erreichen, was für die angepeilte Zielgruppe

ein wesentliches Kaufkriterium war. Aufgrund der beschränkten

Speicherkapazität der Cartridges auf denen die Spiele erhältlich

waren, war es allerdings nicht möglich, natürliche Töne in

digitaliserter Form zu speichern. Stattdessen wurde die Tonerzeugung über

die eingebauten Synthesizer realisiert. Diese setzten die auszugebenden

Töne aus Rechteck- und Sägezahnwellen zusammen wodurch sich auch der

als „krächzend“ beschreibbare Klang der ersten Spielkonsolen erklären

lässt. Dieser Signalprozessor wurde auch für elektronische Musikinstrumente

eingesetzt und verfügte über eine große Anzahl an Variationsmöglichkeiten

der zu erzeugenden Geräusche. So konnten Tonhöhe, Wellenform und

Lautstärke eingestellt werden. Er verfügte über drei

Tonoszillatoren, die Töne in einen Frequenzbereich von 0-4kHz erzeugen

konnten. Pro Oszillator standen insgesamt 4 Wellenformen zur Verfügung:

Dreieck-, Sägezahn- und Rechtecksignale sowie Rauschen. Es waren auch

drei Hüllkurvengeneratoren vorhanden mit Hilfe deren man Töne nach

dem ADSR-Verfahren erzeugen konnte. Diese Abkürzung steht für die

einzelnen Phasen, die ein Ton bei seiner Wiedergabe durchläuft, also

Attack, Decay, Sustain, Release. Dabei ist mit Attack das Anschwellen

des Tones zu Beginn gemeint, Decay bezeichnet das kurze Abfallen vor

beginn der Sustainphase, in der der Ton konstant gehalten wird. Release

schließlich bestimmt die Ausklingphase des Tons. Um nun einen Ton zu

erzeugen, gibt man, vereinfacht gesagt, die grundlegende Wellenart und

die ADSR Parameter in Zeiteinheiten an. Mit dieser Technik ist es

sowohl möglich, Töne von Musikinstrumenten nachzubilden als auch

komplett neue Geräusche zu kreieren, die in der Natur nicht vorkommen.

Viele Synthesizer in den Achzigerjahren verwendeten diese Art der

Klangerzeugung und sie wird auch heutzutage noch angewandt. Ein Vorteil

hierbei ist, daß ein Ton mit einer relativ geringen Anzahl an

Parametern beschrieben werden kann, da der Prozessor die Hauptaufgabe

bei der Klangerzeugung leistet und somit der Speicherplatz auf dem

Medium, das die Töne aufnehmen soll, gering gehalten werden kann.

Weiters war es bei dem Soundchip des Commodore 64 auch möglich,

programmierbare Filter, wie zum Beispiel Hochpass, Tiefpass und

Bandpass anzuwenden. Obwohl vom Chip her theoretisch vorgesehen, verfügte

der C64 nicht über Audioeingänge. Es konnten aber externe

Audiosignale verarbeitet werden, sodaß es möglich war, mehrere SID

Chips parallel zu betreiben um sie zum Beispiel in polyphonen

Umgebungen

Dieser Signalprozessor wurde auch für elektronische Musikinstrumente

eingesetzt und verfügte über eine große Anzahl an Variationsmöglichkeiten

der zu erzeugenden Geräusche. So konnten Tonhöhe, Wellenform und

Lautstärke eingestellt werden. Er verfügte über drei

Tonoszillatoren, die Töne in einen Frequenzbereich von 0-4kHz erzeugen

konnten. Pro Oszillator standen insgesamt 4 Wellenformen zur Verfügung:

Dreieck-, Sägezahn- und Rechtecksignale sowie Rauschen. Es waren auch

drei Hüllkurvengeneratoren vorhanden mit Hilfe deren man Töne nach

dem ADSR-Verfahren erzeugen konnte. Diese Abkürzung steht für die

einzelnen Phasen, die ein Ton bei seiner Wiedergabe durchläuft, also

Attack, Decay, Sustain, Release. Dabei ist mit Attack das Anschwellen

des Tones zu Beginn gemeint, Decay bezeichnet das kurze Abfallen vor

beginn der Sustainphase, in der der Ton konstant gehalten wird. Release

schließlich bestimmt die Ausklingphase des Tons. Um nun einen Ton zu

erzeugen, gibt man, vereinfacht gesagt, die grundlegende Wellenart und

die ADSR Parameter in Zeiteinheiten an. Mit dieser Technik ist es

sowohl möglich, Töne von Musikinstrumenten nachzubilden als auch

komplett neue Geräusche zu kreieren, die in der Natur nicht vorkommen.

Viele Synthesizer in den Achzigerjahren verwendeten diese Art der

Klangerzeugung und sie wird auch heutzutage noch angewandt. Ein Vorteil

hierbei ist, daß ein Ton mit einer relativ geringen Anzahl an

Parametern beschrieben werden kann, da der Prozessor die Hauptaufgabe

bei der Klangerzeugung leistet und somit der Speicherplatz auf dem

Medium, das die Töne aufnehmen soll, gering gehalten werden kann.

Weiters war es bei dem Soundchip des Commodore 64 auch möglich,

programmierbare Filter, wie zum Beispiel Hochpass, Tiefpass und

Bandpass anzuwenden. Obwohl vom Chip her theoretisch vorgesehen, verfügte

der C64 nicht über Audioeingänge. Es konnten aber externe

Audiosignale verarbeitet werden, sodaß es möglich war, mehrere SID

Chips parallel zu betreiben um sie zum Beispiel in polyphonen

Umgebungen Es ist möglich, einen analogen Ton in

unterschiedlichen Qualitätsstufen zu digitaliseren und dementsprechend

ändert sich dann auch der Platzbedarf der Datei. Der Vorteil dieses

Formates, die eingesampelten Instrumente konnten sich allerdings auch

als gravierender Nachteil herausstellen. So hört sich eine solche

Datei unter Umständen durch die sich ständig im gleichen Muster

wiederholenden Instrumente eintönig und unprofessionell an. Weiters

hat man gerade am Amiga das Problem, daß pro Stereokanal genau zwei

Soundkanäle zur Verfügung standen und es somit oft passierte, daß

man ein Instrument ständig auf dem rechten Kanal hörte und die

anderen auf dem Linken. Das ursprüngliche MOD-Format war, da es ja vom

Amiga kam, auf vier Kanäle ausgelegt, es wurde jedoch weiterentwickelt

und mit modernen Soundkarten, die es auch für die Commodore Computer

zu kaufen gab, konnte man mit bis zu 64 Kanälen gleichzeitig arbeiten.

Auch für die IBM-kompatiblen PCs gab und gibt es sowohl Player als

auch Tracker für dieses Format es hatte aber auf dieser Plattform nie

eine derartig weite Verbreitung wie am Amiga.

Es ist möglich, einen analogen Ton in

unterschiedlichen Qualitätsstufen zu digitaliseren und dementsprechend

ändert sich dann auch der Platzbedarf der Datei. Der Vorteil dieses

Formates, die eingesampelten Instrumente konnten sich allerdings auch

als gravierender Nachteil herausstellen. So hört sich eine solche

Datei unter Umständen durch die sich ständig im gleichen Muster

wiederholenden Instrumente eintönig und unprofessionell an. Weiters

hat man gerade am Amiga das Problem, daß pro Stereokanal genau zwei

Soundkanäle zur Verfügung standen und es somit oft passierte, daß

man ein Instrument ständig auf dem rechten Kanal hörte und die

anderen auf dem Linken. Das ursprüngliche MOD-Format war, da es ja vom

Amiga kam, auf vier Kanäle ausgelegt, es wurde jedoch weiterentwickelt

und mit modernen Soundkarten, die es auch für die Commodore Computer

zu kaufen gab, konnte man mit bis zu 64 Kanälen gleichzeitig arbeiten.

Auch für die IBM-kompatiblen PCs gab und gibt es sowohl Player als

auch Tracker für dieses Format es hatte aber auf dieser Plattform nie

eine derartig weite Verbreitung wie am Amiga.