fit 2001 >

Gruppenthema > Entstehung

Überblick

Soundkarten & Multimedia

| Jänner 1982: | Commodore kündigt den Commodore 64 an. Er ist der erste Personal Computer mit integriertem Sound Synthesizer Chip. Er wird bald zum bestverkauften Computer mit geschätzten 17-22 Millionen verkauften Exemplaren. |

| Juni 1982: | Commodore veröffentlicht den BX256 mit dem 16-bit 8088-Prozessor von Intel und einer 3-Voice-Soundkarte. Der Preis beträgt 3000$. |

| 1982: | Bei der National Association of Music Manufacturers convention, eine Gruppe von elektronischen Musikgesellschaften, wird vereinbart, dass man einen digitalen Übertragungsstandard für Musik schaffen will. Ein Jahr später wird MIDI geboren. |

| Jänner 1985: | Atari veröffentlicht den 65XE und kurz darauf den 65XEM. Dieser enthält einen eingebauten 8-Voice-Syntesizer. |

| 1986: |

Das erste Virtual Reality-System wird vorgestellt.

|

| Oktober 87: | Ad Lib Incorporated enthüllt sein Ad Lib Personal Computer Music System für 245$. Diese Soundkarte verfügt über eine FM-Synthese mit 11 gleichzeitigen Stimmen. |

| 1989: | Creative Labs führt den Sound Blaster ein, eine 8-bit Mono Soundkarte mit einem 11-voice FM Synthesizer, Text-to-Speech-Fähigkeiten , digitalisierten voice input/output, einem MIDI port, einem Joystick port und einem Software-Bundle. |

| November 1990: | Das Multimedia PC Marketing Council bestimmt das erste Mal in der Geschichte eine Minimalkonfiguration für einen PC, der sich als Multimedia-PC bezeichnen will und auf dem MPC-Software laufen kann: 10-MHz 286 Prozessor, 2MB RAM, 30MB Festplatte, 16-color VGA, Maus, 8-bit Soundkarte, 150KBps CD-ROM-Laufwerk. |

| Oktober 1991: | Microsoft und andere Gesellschaften veröffentlichen ein knappes Jahr später den Multimedia PC (MPC) Standard. |

| Oktober 1991: | Apple Computer und IBM entwickeln Kaleida, eine Hardware-unabhängige Multimedia Skript-Sprache. |

| 1991: | Creative Labs veröffentlicht den Sound Blaster Pro Deluxe, die erste Stereo PC Soundkarte. |

| 1992: | Creative Labs veröffentlicht den Sound Blaster 16 mit einem "Advanced Signal Processor", eine 16-bit Stereo PC Soundkarte. |

| 1992: | Das Multimedia PC Marketing Council die Mindestanforderungen von MPC auf einen 16-MHz 386SX Prozessor. |

| März 1993: | Microsoft veröffentlicht Microsoft Encarta, die erste multimediale Enzyklopädie für einen Computer. |

| August 1993: | Compton's New Media Incorporated erhält ein Patent für Multimedia-Suche und -multimediale Informationsgewinnung vom U.S Patent and Trade Office. Compton's New Media behauptet darauf, dass alle, die Informationen in einem multimedialen Format verkaufen wollen, Lizenzgebühren zahlen müssen. |

| Sommer 1993: | Das Multimedia PC Marketing Council veröffentlicht den MPC Level 2 Standard, mit folgenden Mindestanforderungen: 486 Prozessor, 160MB Festplatte, 2x XA-ready Multisession CD-ROM-Laufwerk, 16-bit Soundkarte und eine 16-bit SuperVGA Grafikkarte mit 65,000 Farben in 640x480 Auflösung. |

| Februar 1994: | Apple Computer veröffentlicht QuickTime 2.0, mit interaktivem Fernsehen, Musik und Vollbild-Video-Support. |

| 1995: | Intel liefert seine Prozessoren mit MMX-Technologie aus und fügt später in seinem Pentium III die ISSE-Instruktionen ein. AMD entwickelt das Gegenstück zu ISSE, nämlich 3DNOW. DVD und MP3, sowie 3D-Grafikkarten machen den modernen Computer zu Alleskönnern und beginnen Stereoanlagen, Videoschnittgeräte, Videorekorder und Spielkonsolen zu ersetzten. Auch das Internet gewinnt an Popularität und Themen wie Video-Streaming und Zugriff auf weltweite multimediale Inhalte aus dem Netz werden immer wichtiger. Microsofts Direct X bietet eine einheitliche Schnittstelle zu den verschiedenen Hardwaregeräten. Soundkarten und Boxensysteme entsprechen immer häufiger den Standards Dolby Sourround, sowie Dolby Digital und äquivalenten Systemen. |

- PC-Speaker: Dieser stand ganz am Anfang und ist bis heute in jedem PC vorhanden. Es handelt sich hierbei um einen billigen Lautsprecher, der piepsende Töne von sich gibt, wenn man verschiedenen Spannungen anlegt.

- FM-Synthese: Zu diesen zählen unter anderem die OPL-Chips . Hierbei werden durch FrequenzModulation (FM) synthetische Klänge erzeugt. Diese Methode wurde vor allem in den 80er und Anfang der 90er angewandt (z.B. die meisten Soundblaster-Karten aus dieser Zeit).

- Wave-Table: Diese Technik liefert die besten Resultate. Hierbei werden in einem Speicherbereich auf der Soundkarte (oder evtl. auch im Hauptspeicher) Samples von echten Instrumenten gespeichert. Mit Hilfe geeigneter Algorithmen können diese dann beliebig in Tonhöhe und Lautstärke verändert werden. Die meisten modernen Soundkarten basieren auf dieser Technik.

| Jahr | Hersteller | Anzahl der Stimmen | Anzahl Lautsprecher |

| 1982 | Commodore BX256 | 3 | Mono/1 |

| 1985 | Atari 65XEM | 5 | Mono/1 |

| 1987 | AdLib PC Music System | 11 | Mono/1 |

| 1991 | Creative Labs SB Pro | 16 | Stereo/2 |

| 1992 | Creative Labs SB 16 | 32 | Stereo/2 |

| 1997 | Creative Labs SB PCI 64 | 64 | Quadrophonie/4 |

| 1998 | Creative Labs SB PCI 128 | 128 | Quadrophonie/4 |

| 1999 | Creative Labs SB PCI 512 | 512 | Quadrophonie/4 |

| 2000 | Creative Labs SB Live! Platinum | 1024 | Dolby Digital/5.1 |

Ausgabegeräte für Blinde & Sehbehinderte

In den frühen 70er Jahren wurde ein Forschungsprojekt von F.H. Papenmeier und Prof. Dr. Werner Boldt an der Universität Dortmund (REHA-Technik) gestartet. Es handelte sich dabei um die Entwicklung eines elektronischen Ausgabemediums für Sehbehinderte. Nach fünf Jahren Entwicklung wurde dann schließlich in Kooperation mit einer kommerziellen Firma das erste Ergebnis vorgestellt: BRAILEX, die erste Braillezeile. Es handelte sich dabei um eine Erweiterung für den Computer, mit deren Hilfe der Bildschirminhalt auch für Blinde sichtbar gemacht werden konnte. Es war möglich jedes Zeichen einer Zeile des Bildschirms in eine spezielle Computer-Braille-Schrift zu übersetzten. Diese unterscheidet sich im wesentlichen durch die Anzahl der Punkte, die ein Zeichen beschreiben (8 gegenüber 12). Mit Hilfe von Steuertasten konnte der sichtbare Ausschnitt verändert werden. Diese Variante bildete bis auf kleine Änderungen (Interfaces zu anderen Geräten, wie z.B. eine speziellen Schreibmaschine, usw.) den stand der Technik für etwa 10 Jahre. In den frühen 80ern wurde dann ein eigene Schreibmaschine für Blinde entwickelt. Sie verfügte über eine Braille-Tastatur und eine Braillezeile, welche die aktuelle Zeile wiedergab. Weitere fünf Jahre später wurde dann ein weitere Meilenstein gesetzt, die Entwicklung einer Braillezeile für den PC. Sie war im wesentlichen eine angepasste Version der BRAILEX. Eröffnete allerdings einen viel größeren Markt. Jedoch verlor mit dem Entstehen der ersten graphischen Benutzeroberflächen die Braillezeile an Attraktivität, obwohl auch für Windows spezielle Softwarelösungen erarbeitet wurden. Ein weiterer großer Schub war der Boom des Internet, der das Thema Blinde und Computer auch in das gesellschaftliche Bewusstsein brachte. Es wurden auch Erweiterungen zu normalen Zeilen angeboten. So wurde beispielsweise eine Braille mit zusätzlichem Übersichtsfeld entwickelt, auf dem der Inhalt des Bildschirm grob als Relief angezeigt wurde. Ein ähnliches Projekt wurde auch an der Technischen Universität Wien bearbeitet, in dem es darum ging den Inhalt des Bildschirms als Relief darzustellen und so auch Bilder gut sichtbar zu machen, und vielleicht die Braillezeile überflüssig zu machen. Über den Erfolg bzw. Misserfolg des Projekts ist leider nichts zu finden.

Eine andere Möglichkeit für Sehbehinderte mit dem Computer zu arbeiten wurde erst später als die Braillezeile entwickelt: die Sprachausgabe. Bei der Sprachausgabe werden alle Informationen des Bildschirms in Sprache umgewandelt und entweder mit spezieller Hardware oder mit Software über normale Soundkarten ausgegeben. Im allgemeinen ist diese Variante der Ausgabe nicht so effizient wir beispielsweise die Braille, da der Informationsfluss nicht genau gesteuert werden kann. Im Internet findet die Sprachausgabe jedoch häufig Anwendung. Auf dem PC wurde bereits 1989 mit dem ersten Soundblaster ein (zwar beschränktes) Sprachausgabe Programm angeboten. Heute werden vor allem Browser-Plugins (beispielsweise von Appell und IBM) und eigenständige Browser (Brooks-Talk) angeboten, allgemeine Screenreader sind meist um einiges teurer.

Aber auch dir dauerhafte Ausgabe auf Papier ist mit Hilfe spezieller Drucker möglich. Über diese Drucker war aber keine Entwicklungsgeschichte im Internet auffindbar daher sind hier lediglich Bilder zur Illustration. Ein Drucker dieser Art kann 10 bis 70 Zeichen pro Sekunde ausgeben, dies kann bei teureren Modell sogar beidseitig geschehen. Technisch dürften diese Drucker nicht viel aufwendiger als normale Drucker sein. Jedoch preislich sind Drucker ab 20.000 ATS erhältlich.

Motive & IdeenDie Entwicklung der ersten Braillezeile wurde an einer deutschen Universität gemacht, dabei spielten keine kommerziellen Unternehmen mit. Erst als konkrete Konzepte vorhanden waren wurde ein Parten für die weitere Vermarktung gesucht. Die Motive für das Forschungsprojekt lagen also nicht im wirtschaftlichen. Über die weiteren Hintergründe, beispielsweise den Auftraggeber konnten wir allerdings keine Informationen beschaffen.

Konzepte, Vorbilder & technische RealisierungenDas Vorbild für die Computer-Braille-Schrift war klarerweise die normale Braille-Schrift, dabei mussten jedoch Abstriche gemacht werden, da eine Realisierung mit 12 Zeichenpunkten am Computer zu aufwendig gewesen wäre. Es wurde daher ein abgeänderter 8 Punkte-Code erstellt, der relativ leicht auf die Zeichen des Bildschirms umzulegen war. Technisch wurde die Braille über normale Schnittstellen (z.B. serielle Schnittstelle) am dem jeweiligen Computer angeschlossen und über spezielle Software angesteuert. Die Umrechnung der Daten auf die Blindenschrift erfolgte jedoch in Hardware in der Zeile selbst.

Speichergeräte

In gewissen Sinne waren die Lochkarten die Vorfahren der heutigen Speichermedien, sie dienten unter anderem als Ausgabemedium der ersten Computergenerationen. Schon 1805 wurden Lochkarten zur Steuerung von Webmaschinen verwendet. Die erste Rechenmaschine, welche die Idee der Lochkarte verwendete wurde bereits 1838 von Charles Babbage erfunden, jedoch zur damaligen Zeit als Unsinn abgetan.

1886 wurden Lochkarten das erste mal als Speichermedium eingesetzt, bei einer Volkszählung in den USA wurden Lochkarten zum Zählen verwendet. Das System der Lochkarten wurde bis Mitte des 20.Jahrhunderts beibehalten. Der nächste große Sprung war die Verwendung von CRT-Röhren zur dauerhaften Speicherung von Daten. Dabei konnten jedoch nur wenige Bits gespeichert werden, und es wurden andere Techniken entwickelt um größere Datenmengen zu speichern.

Die Erfindung von Magnetbändern (1935, durch Fritz Pfleumer) stellte den entscheidenden Schritt für die Speicherung großer Datenmengen dar. Ab 1957 wurden dann Computer Systeme entwickelt, die Disketten verwendeten. Die 8½ Zoll große Scheibe konnte Daten bis 200kb Speichern. Aus ihre entstanden später die 5¼ und schließlich 1981 die 3½ Zoll Disketten.

Die Festplatte ist heute das am weitesten verbreitete Speichermedium der Welt. Das System der Speicherung ist ähnlich dem von Disketten, allerdings ist die Datendichte und die Genauigkeit des Zugriffes um vieles größer. Der erste PC, der standardmäßig mit einer Festplatte ausgeliefert wurde, kam 1981 von Vector Graphics Inc. auf den Markt. Sie bot platz für ca. 10 MB Daten. Im laufe der Jahre wurde die Datendichte immer weiter erhöht So hat sich die Datendichte von 1985 bis 1998 um das 30ig Fache erhöht.

In Zukunft werden allerdings neue Speichertechniken, die meist eine Kombination aus optischen und magnetischen Speichertechniken darstellen, die Rolle der Massenspeicher übernehmen.

Motive & IdeenMan brauchte einfach eine Möglichkeit große Datenmengen billig und dauerhaft sic

hern zu können. Konzept, Vorbilder & technische Realisierungen- Lochkarten, Lochstreifen, Lochbänder

- Magnetbänder, Magnettrommeln, Magnetscheiben, Magnetscheiben, die gar nicht genützt werden

- Optische Medien

- Chemische Medien

- ...

Drucker

- 1969: Gary Starkweather angestellt bei Xerox entwickelt den Laserdrucker

- 1978: Epson stellt den X-80 vor, welcher der erste kommerziell erfolgreiche Matrixdrucker für Computer ist.

- Mai 1981: Xerox stellt den Xerox Star vor. Er verfügt über einen Laserdrucker, der als erster zu kaufen ist. Der Preis für das Gesamtpaket belief sich auf ca. $17.000 was für viele zu teuer war und daher nicht oft verkauft wurde.

- Sep. 1981: Microsoft beginnt mit der Entwicklung eines Interface Managers, der Ausgabe- als auch Eingabegeräte ansteuern kann.

- Jänner 1982:Sharp bringt den Sharp PC-1500 auf den Markt. Dabei handelte es sich um einen eher kleinen Taschencomputer mit Drucker. Der Computer selbst kostete $300 und dazu war ein kleiner Drucker um $250 erhältlich.

- Juni 1982: Epson America Inc. präsentiert den HX-20. Auch ein Taschencomputer, welcher einen Drucker enthält.

- Juli 1982: Apple Computer stellt den ersten Punkt-Matrix-Drucker für US$700 vor.

- 1982: Aval entwickelt den AVC-777J2 tragbaren Microcomputer. Er verfügt über einen 5-inch großen Thermodrucker.

- 1983: Apple Computer bringt einen Drucker, der besonders gut für den Druck von Briefen geeignet ist. Allerdings kostet dieser $2.200.

- Juni 1984: Commodore stellt seinen MCS 801 Farb-Matrix-Drucker vor.

- 1984: Hewlett-Packard entwickelt den LaserJet Drucker mit einer Auflösung von 300dpi

- 1986: Hewlett-Packard präsentiert den HP PaintJet. (Einer der ersten Farbtintenstrahldrucker)

- 1988: Hewlett-Packard bringt den HP DeskJet Tintenstrahldrucker für $1.000 auf den Markt.

- 1988: QMS verkauft den ColorScript Model 30 Thermofarbdrucker mit guter Qualität zu einem Preis von $25.000.

- Sommer 1990: Canon USA stellt den BJ-10e tragbaren Tintenstrahldrucker vor. Er wiegte 4 Pfund.

- März 1991: IBM gründet das Unternehmen Lexmark und vertreibt mit der Marke Lexmark seine Drucker.

- Herbst 1992: HP stellt seinen HP LaserJet 4 Laserdrucker vor.

- März 1994: Hewlett-Packard beginnt mit dem Verkauf der HP DeskWriter 520 Tintenstrahldrucker. Dieser Drucker kostete $365 und war damit einer der ersten Drucker, welche auch für den Heimanwender gedacht war.

- Juni 1995: Apple Computer präsentiert seinen ersten Farblaserdrucker, den Color Laser Printer 12/600PS. Er verfügt über eine Auflösung von 600x600 dpi und einer Speicherkapazität von 12 MB RAM. Allerdings basiert er auf der von Canon entwickelten Technologie und kostete ca. $7,000.

- August 1995: Hewlett-Packard verkauft seinen DeskJet 850C und 855C Tintenstrahldrucker für US$658 und US$663. Ab dem Jahr 1996 beginnt der Kampf um die Heimanwender. Jeder Anbieter versucht mit billigen Druckern Kunden für sich zu gewinnen. Es werden fast monatlich neue Drucker auf den Markt gebraucht.

Der wesentliche Vorteil von Druckern gegenüber Bildschirmen, LED-Schirmen usw. ist, dass Ausgabe auf Papier keine elektrische Energie benötigt um lesbar gemacht zu werden. Außerdem können Informationen auf Papier - zu dieser Zeit - besser ausgetauscht, verschickt und bearbeitet werden. Auch kann man den Drucker als eine Art frühes "Speichermedium" ansehen: Berechnungen, die von einem Computer durchgeführt werden, waren zu Beginn des Computers recht zeit- und ressourcenaufwendig. So wurde es notwendig, gewonnene Information (Berechnungen) festzuhalten und zu verhindern diese nochmals ausführen zu müssen. Deshalb ist der Drucker dafür das ideale Gerät.

So war es auch wenig überraschend, dass nach der Vorstellung der ersten Computer auch bald Computer mit Druckern folgten. Als einen der ersten Vertreter könnte man hier den im Mai 1981 vorgestellten Computer Xerox Star 8010 nennen.

VorbilderDas Vorbild für den Drucker war die Schreibmaschine. Obwohl die Schreibmaschine zu Beginn kein großer Erfolg war (Der Mechanismus war langsam und schwerfällig, führte außerdem zu Zwängen bei der Eingabe, ....), setzte sich dieses Gerät durch. Es wurde nun versucht das Konzept der Schreibmaschine auf den Drucker umzulegen. Dies wurde insbesondere bei Matrix-, Thermo- und Laserdruckern verwirklicht. Wie bei der Schreibmaschine werden auch hier Anschläge über ein Farbband (Farbtrommel) durchgeführt. Doch auch das menschliche Schreiben war Vorbild für den Drucker. (realisiert durch den Plotter)

RealisierungenMatrixdrucker: Das Konzept eines Matrixdrucker beruht darauf, dass über das Papier eine Matrix von Punkten geführt wird. Je nach dem welcher Buchstabe oder Zeichen gedruckt werden soll, werden Punkte der Matrix aktiviert. Technisch realisiert wurde der Matrixdrucker durch den Nadeldrucker und Tintenstrahldrucker.

Nadeldrucker: Bei einem Nadeldrucker schlagen Nadeln auf ein Farbband. Dadurch werden Punkte auf Papier gedruckt, die im Ganzen gesehen Buchstaben, Zahlen oder Zeichen darstellen.

Tintenstrahldrucker: Dieser Drucker ähnelt sehr dem Nadeldrucker. Doch hier werden in Matrix aufgebaute Düsen verwendet, welche Tinte auf das Papier befördern. Dieser Drucker ist gegenüber dem Nadeldrucker qualitativ besser, da die Matrix hier viel engmaschiger gewählt werden kann und somit die gedruckten Buchstaben, Zahlen und Zeichen detaillierter erscheinen.

Das wesentliche Konzept hinter dem Thermodrucker ist, dass der Druck durch Wärme gesteuert wird. Die Wäre die von einem Kopf ausgestrahlt wird bewirkt ein Einfärben des Papiers. Der wesentliche Unterschied zum Tintenstrahldrucker ist, dass die Farbe nicht von einem Kopf auf das Papier gedruckt wird, sondern die Farbe bereits auf dem Papier ist und durch Wärme sichtbar gemacht wird.

Thermotransferdrucker: Ein spezielles Papier, welches Farbfolien enthält, wird durch den Drucker geführt. Aufgrund von Wärme wird das Papier dazu gebracht sich zu verfärben und so einsteht ein Ausdruck. Der Vorteil im Thermotransferdrucker liegt darin, dass er schneller als der Tintenstrahldrucker ist. Allerdings ist das benötigte Spezialpapier recht teuer und damit eine wesentlicher Nachteil. Auch kann das Papier schnell beschädigt werden, da ja Farbfolien auf dem Papier selbst vorhanden sind.

Laserdrucker: Bei einem Laserdrucker wird mittels eines Laserlichtes das Papier erhitzt. Dann wird es durch eine Farbtrommel geführt und an den erwärmten Stellen bleibt die Farbe haften.

Plotter: Das Konzept des Plotters entspricht am ehesten dem menschlichen Zeichen. Wie der Mensch einen Stift über das Papier führt, so soll auch der Plotter einen Stift über das Papier führen.

Monitore

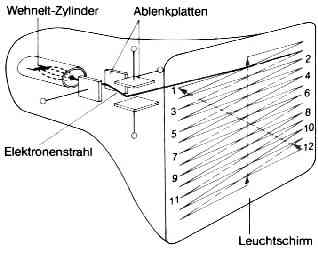

EntwicklungsgeschichteDer heutige Monitor funktioniert nach einem Prinzip, dass von K.F. Braun 1897 entwickelt wurde. Der "Urtyp" des Monitors ist die Braun'sche Röhre.

Monitore gab es zuerst einfarbig - in grün, bernsteinfarben oder grau.

- Jänner 1982: Casio führt den FX-9000P Mikrocomputer ein. Er hat einen 2.75-MHz Prozessor, 12KB ROM, 4KB RAM (erweiterbar auf 32KB), eingebauten 256x128 Monochrom Monitor. Auch beim PC war der einfarbige Monitor lange Zeit der Standard. Heimcomputer wurden lange Zeit nur an den Fernseher angeschlossen - was allerdings die Auflösung so auf max. 320 x 200 beschränkte. Das war aber auch die Standardauflösung der IBM PC's für die man aber einen echten Farbmonitor brauchte.

- Jänner 1982: NEC führt den Advanced Personal Computer (N5200 in Japan) ein. Er besitzt einen 5-MHz NEC PD8086 Mikroprozessor, single oder dual. 1.2MB 8-Zoll Festblatte, 128KB RAM, 12-Zoll Monochrom- oder Farbbildschirm, 80x25 Text, 640x475 Grafik und unterstützt CP/M-86 oder MS-DOS. Mit Einführung von EGA (640 x 350) und VGA (640 x 480) stieg langsam die Auflösung, während die Monitorgröße bei 12" blieb.

- August 1984: IBM kündigt den Enhanced Color Display Monitor mit 640x350 Auflösung an. Preis ca. US$850 IBM kündigt den Professional Graphics Display Monitor an. Preis ca. $1300. Der 14-Zoll Monitor kann gleichzeitig bis zu 256 (von 4096) Farben mit einer Auflösung von 640x480 anzeigen.

- Oktober 1988: Steve Jobs stellt den ersten NeXT computer vor. Für US$6500 bekommt man einen 25-MHz Motorola 68030 Prozessor mit 68882 math coprocessor, 8MB RAM, 17-Zoll Monochrom Monitor, 256MB read/write Magneto-optical Laufwerk, und ein Objekt-orientiertes NeXTSTEP Betriebssystem

- 1986: NEC Home Electronics führt den ersten Multisync Monitor ein.

- Dezember 1993: ·Samsung Electronics Canada führt die SyncMaster GL Serie mit 14-, 15-, und 17-Zoll high-performance "green" monitors ein. Seitdem steigt der Durchmesser der Monitore langsam aber stetig. 1992 war der 14" Standard, 1996 der 15" und heute ist es der 17".

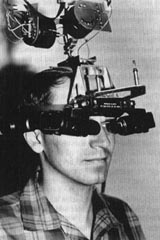

Aktuelle Monitore beschränken sich auf eine 2-dimensionale Ausgabe, doch man wollte schon sehr früh(ca. 60-er Jahren) ein 3-dimensionales Ausgabegerät verwirklichen. Warum wir Menschen in der realen Welt Dinge 3-dimensional wahrnehmen hat einen einfachen Grund: Wir betrachten die Objekte aus unterschiedlichen Blickwinkel, wodurch jedes Auge ein unterschiedliches Bild sieht. Nun werden diese beiden Bilder von unserem Gehirn interpretiert und wir erhalten den Eindruck von Distanz, Größe und Transparenz. 1968 wurde von Ivan Sutherland das erste 3D-display veröffentlicht. Bei diesem 3D-display wurden vor den Augen zwei Displays positioniert, die zwei unterschiedliche Bilder erzeugten und dadurch einen 3D-Effekt erzielten.

Ähnliche 3D-displays(sog. 3D-Brillen) werden heutzutage auch angeboten, konnten sich aber nie wirklich durchsetzen. Die Nachteile von 3D-Brillen sind, dass sie nur von einer Person genutzt werden können und das Objekte nicht aus verschiedenen Positionen betrachtet werden können. 3D-displays, die es erlauben, dass Benutzer Objekte aus unterschiedlichen Positionen betrachten können, werden in der Forschung(Virtual Reality) eingesetzt.

3D-LCD-Displays: Bereits im Jahr 1994 begann Philips mit der Entwicklung von 3D-LCD-displays. 3D-displays sind herkömmliche LCD-Displays, wobei aber gleichzeitig zwei unterschiedliche Bilder erzeugt werden, und somit ein 3-dimensionales Bild erzeugen. Im Gegensatz zu 3D-Brillen hat man bei dieser Technik völlige Bewegungsfreiheit und es können 3D-Objekte von mehreren Benutzern gleichzeitig betrachtet werden. Im Jahr 1995 wurde das erste monochrome 3D-LCD-display präsentiert. In den folgenden Jahren wurde die Technik weiter verbessert. Zur Zeit sind von Philips 14,5-Zoll Farb-3D-LC-displays für Entwickler erhältlich.

Holographie:

- 1947: Das Prinzip der Holographie wird von Dennis Gabor entwickelt

- 1960: Entwicklung des LASERS(Voraussetzung für Holographie)

- 1967: das erste Hologramm einer Person erstellt

- 1971: Verleihung des Nobelpreises für Physik an Gabor für die Erfindung der Holographie

Die Geschichte der flüssigen Kristalle:

- 1888: Der österreichische Botaniker Friedrich Reinitzer entdeckte das Phänomen der flüssigen Kristalle.

- 1973: Nach der Erfindung der verdrillten (engl. twisted) nematischen Zelle 1971 durch die Darmstädter Firma Merck - weltweit größter Hersteller von Flüssigkristallen - gab es 1973 die ersten Uhren und Taschenrechner mit LCD.

- 1983: Sharp bringt das erste Notebook mit monochromen LC-Monitor auf den Markt.

- 1988: die ersten farbigen LC-Monitor kommen auf den Markt.

- 1992: Apple Computer führt das PowerBook 160 ein. Es besitzt einen 10-Zoll LCD Display mit 16- Graustufen, 25-MHz 68030 Prozessor, System 7 Betriebssystem, 4MB RAM (erweiterbar auf 14 MB), 512 KB Video RAM, 40 MB Festplatte, SuperDrive Diskettenlaufwerk, und wog 6.8 Pfund. Preis ca. US$2429.

Bei aktuellen TFT-Bildschirmen werden die dünnen Gläser einer Flüssigkristall-Zelle wie beim Kreuzworträtsel mit einem Gitter aus senkrecht (z. B. 640) und waagerecht (z. B. 480) verlegten, durchsichtigen Leiterbahnen überzogen. Da das Netz aus winzigen Transistoren auf den Gläsern der Flüssigkristall-Kammer so dünn wie ein Film ist, war der Name für diese LC-Technik schnell gefunden: Dünnfilmtransistor-Technik oder auf englisch: Thin Film Transistor (TFT)-Technik.

An jedem Kreuzungspunkt der transparenten Leiterbahnen liegt ein mikroskopisch kleiner Transistor. Die einzelnen Transistoren können gezielt ein- oder ausschalten werden. Je nachdem wie hoch die angelegte Spannung an diesen Transistor-Punkten ist, entsteht ein stärkeres oder schwächeres elektrisches Feld. Die Flüssigkristalle reagieren darauf. Je stärker es ist, desto weniger Licht wird durch die Flüssigkristalle hindurchgelassen.. Der Punkt erscheint dunkler.

Addiert man die Lichtintensitäten der drei Grundfarben Rot, Grün und Blau, lassen sich unterschiedliche Farbtöne erzeugen.

Weiterführende Informationen

- http://www.microprocessor.sscc.ru/comphist/

- http://www.xerox.com

- http://www.hp.com

- http://www.epson.com

- http://home.germany.net/101-156119/computer.htm

- http://www.heise.de/tp/deutsch/html/result.xhtml?url=/tp/deutsch/inhalt/te/1354/1.html&words=Sprachausgabeger%E4te

- http://www.ewetel.net/~marcus.kroeger/referate.htm

- http://www.fb1.uni-siegen.de/ifer/ir/multi_t.htm

- http://www.computer-modell-katalog.de/welcome.htm

- http://irb.cs.tu-berlin.de/~zuse/history/index.html

- http://www.apple-history.com/german.html

- http://www.young.de/

- http://inventors.about.com/science/inventors/library/inventors/blcomputer_peripherals.htm

- http://palimpsest.stanford.edu/icom/vlmp/computing.html

- http://www.tecchannel.de/hardware/658/index.html

- http://www.digitalcentury.com/encyclo/update/comp_hd.html

- http://www.cyberstreet.com/hcs/museum/chron.htm

- http://www.zakros.com/wvr/timeline.html

- http://www.trinity.edu/rjensen/bookbob4.htm

- http://www.sci.sdsu.edu/classes/bio595/index.html

- http://www.cwizard.com/cwizard/computer.htm

- http://www.unet.univie.ac.at/~a9207034/

- http://www.oebsv.at

Verweise auf Arbeiten anderer gruppen

>Entstehung | Ausbreitung | Verlierer | Vergleich | Sicherheit | Veränderung | Auswirkungen | Interaktiv | Zukunft